【经典书】贝叶斯强化学习概述,147页pdf

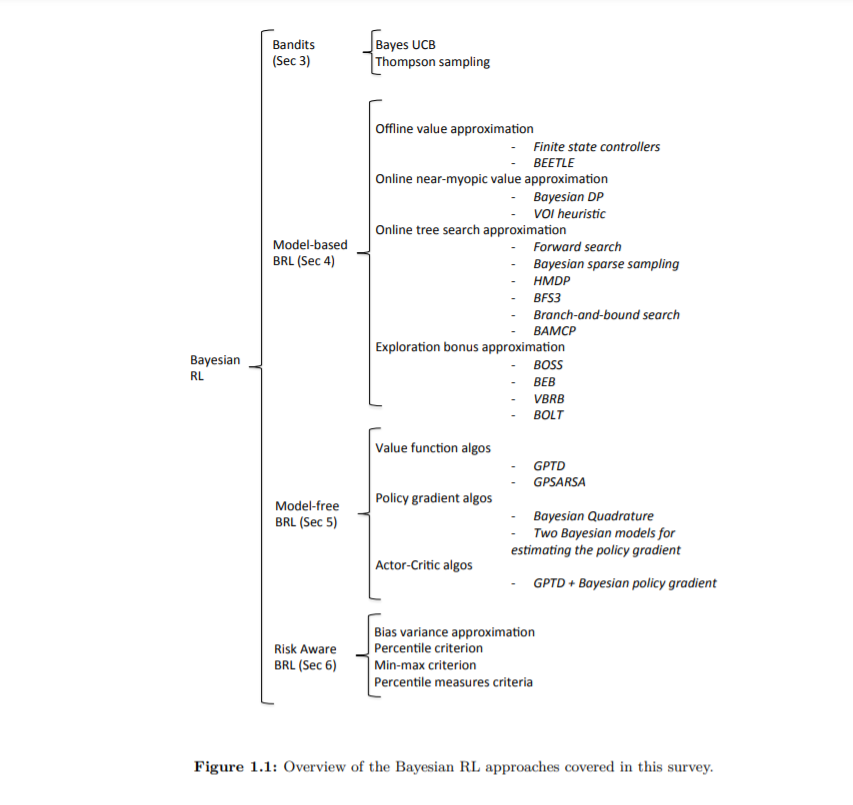

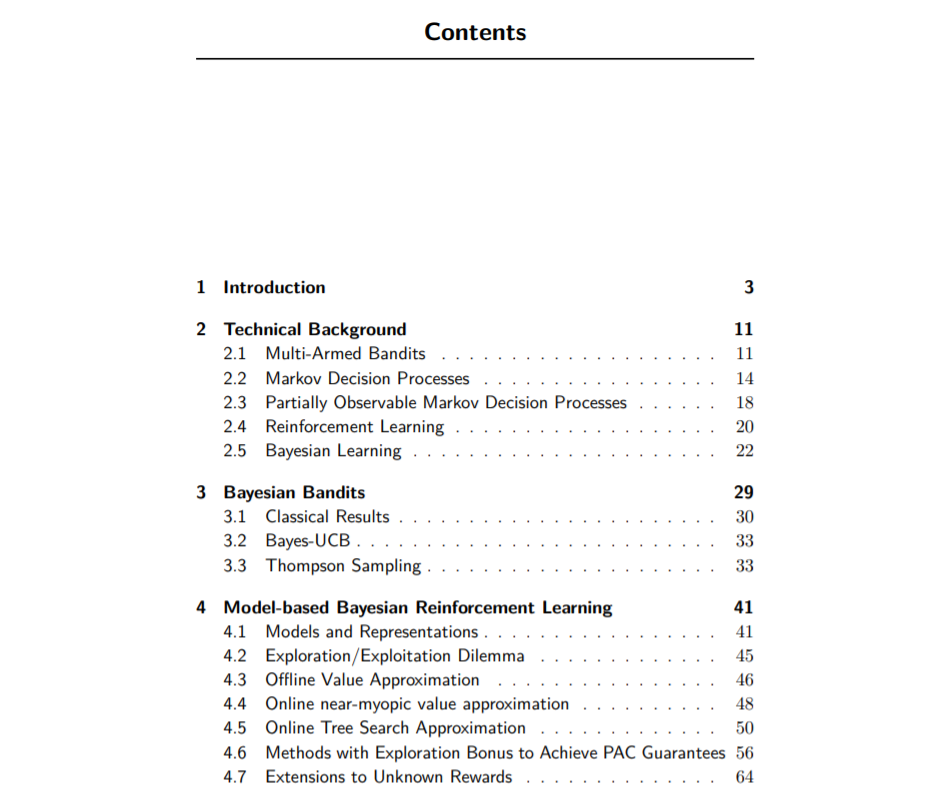

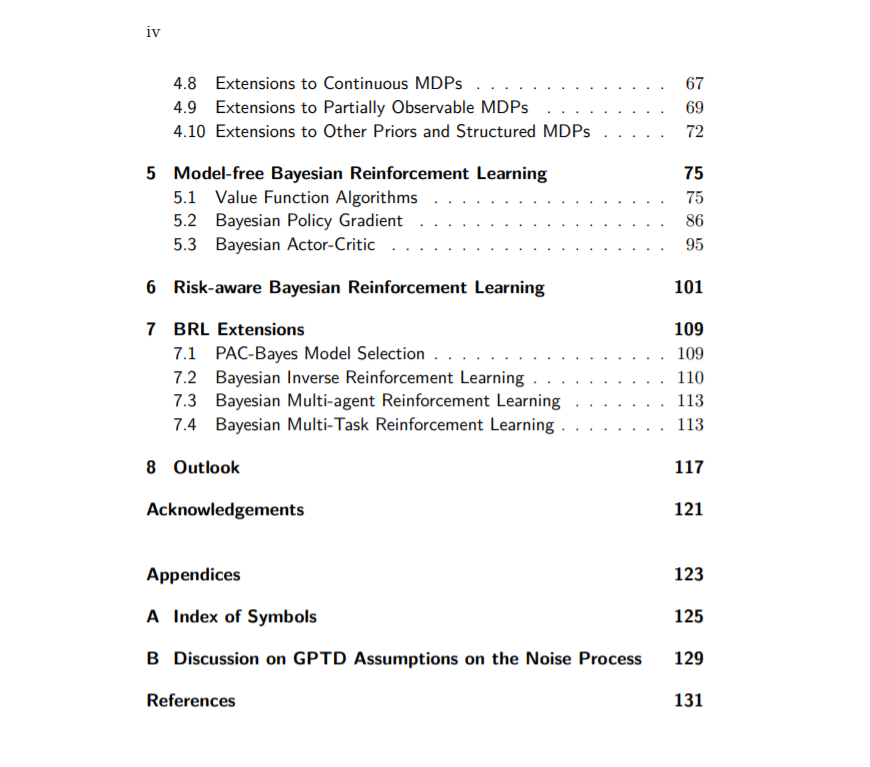

用于机器学习的贝叶斯方法已经被广泛研究,产生了将先验信息纳入推理算法的原则方法。本文对贝叶斯方法在强化学习(RL)范式中的作用进行了深入的评述。在RL中整合贝叶斯推理的主要动机是,它提供了一种优雅的行动选择(探索/开发)方法,作为学习中的不确定性的函数,并且它提供了一种将先验知识整合到算法中的机制。

贝叶斯强化学习:综述首先讨论了简单单步Bandit模型中的贝叶斯推理模型和方法。然后回顾了最近关于基于模型的RL的贝叶斯方法的广泛文献,其中先验信息可以表达在马尔可夫模型的参数上。它还提出了无模型RL的贝叶斯方法,其中先验是在值函数或策略类上表示的。

《贝叶斯强化学习》是一个全面的参述,为学生和研究人员与兴趣的贝叶斯RL算法及其理论和经验性质。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“BRLS” 就可以获取《【经典书】贝叶斯强化学习概述,147页pdf》专知下载链接

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月18日