极市直播 | 超硬核!12位CVPR2020论文一作联合直播,涵盖分类/分割/ReID等多个热门方向

| 极市线上分享 第56期 |

今年CVPR 2020会议将于6 月 14-19 日在美国西雅图举行, 目前会议接收论文结果已公布,从 6656 篇有效投稿中录取了 1470 篇论文,录取率约为 22% 。极市平台特推出了CVPR 2020专题直播分享,往期分享请前往

bbs.cvmart.net/topics/149 或直接阅读原文

极市本期5月16日(星期六)的CVPR 2020专题直播分享将独家直播由中国图象图形学学会(CSIG)和广东省图象图形学会(GDSIG)主办的CSIG-广东省CVPR 2020论文预交流在线学术报告会。

CSIG-广东省CVPR 2020论文预交流在线学术报告会,邀请了12位广东省此领域部分优秀团队的青年学子,介绍他们今年CVPR 2020录用论文的最新研究成果,旨在给本领域研究者、技术开发人员和研究生介绍计算机视觉前沿理论、方法及技术的一些最新进展。

01

直播信息

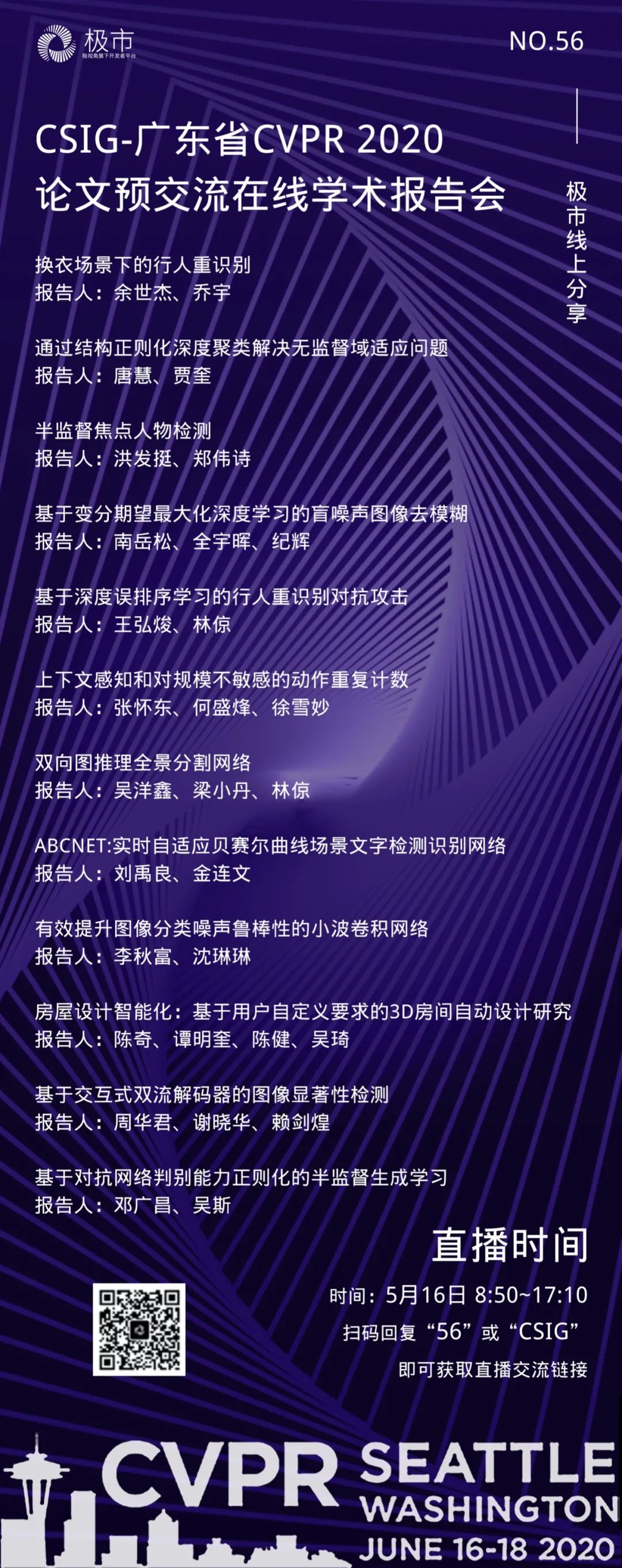

时间:2020年5月16日 (周六)08:50~17:10

主题

CSIG-广东省CVPR 2020论文预交流在线学术报告

参与提问及讨论:

请报名注册,报名方式见文末(非报名注册用户可参与观看,但无法参与提问交流)

02

会议流程

2020年5月16日上午 (会议主持人:金连文教授) |

||

08:30 – 08:50 |

腾讯会议系统登录开放 |

|

08:50 – 09:00 |

会议开幕致辞 (赖剑煌教授) |

|

09:00 – 09:25 |

COCAS: A Large-Scale Clothes Changing Person Dataset for Re-identification |

报告人:余世杰、乔宇 |

09:25 – 09:50 |

Unsupervised Domain Adaptation via Structurally Regularized Deep Clustering |

报告人:唐慧、贾奎 |

09:50 – 10:15 |

Learning to Detect Important People in Unlabelled Images for Semi-supervised Important People Detection |

报告人:洪发挺、郑伟诗 |

10:15 – 10:40 |

Variational-EM-Based Deep Learning for Noise-Blind Image Deblurring |

报告人:南岳松、全宇晖 |

10:40 – 11:05 |

Transferable, Controllable, and Inconspicuous Adversarial Attacks on Person Re-identification With Deep Mis-Ranking |

报告人:王弘焌、林倞 |

11:05 – 11:30 |

Context-aware and Scale-insensitive Temporal Repetition Counting |

报告人:张怀东、何盛烽、徐雪妙 |

2020年5月16日下午(会议主持人:郑伟诗教授) |

||

14:30 – 14:55 |

Bidirectional Graph Reasoning Network for Panoptic Segmentation |

报告人:吴洋鑫、梁小丹、林倞 |

14:55 – 15:20 |

ABCNet: Real-time Scene Text Spotting with Adaptive Bezier-Curve Network |

报告人:刘禹良、金连文 |

15:20 – 15:45 |

Wavelet Integrated CNNs for Noise-Robust Image Classification |

报告人:李秋富、沈琳琳 |

15:45 – 16:10 |

Intelligent Home 3D: Automatic 3D-House Design from Linguistic Descriptions Only |

报告人:陈奇、谭明奎、陈健、吴琦 |

16:10 – 16:35 |

Interactive Two-Stream Decoder for Accurate and Fast Saliency Detection |

报告人:周华君、谢晓华、赖剑煌 |

16:35 – 17:00 |

Regularizing Discriminative Capability of CGANs for Semi-Supervised Generative Learning |

报告人:邓广昌、吴斯 |

17:00 – 17:10 |

闭幕式致辞 (林宙辰教授) |

|

*注:每篇论文由排序第一的报告人进行演讲报告,其余报告人协助回答问题及参与讨论。

03

报告题目及中文摘要

➤报告1. COCAS: A Large-Scale Clothes Changing Person Dataset for Re-identification (换衣场景下的行人重识别)

摘要:近些年对行人重识别的研究已经取得了较大的进展。许多学术数据集,诸如Market1501、CUHK03、DukeMTMC等对该领域做出了巨大的贡献。但据我们所知,这些数据集中同一个人的图片所穿的衣服都是相同的。然而在真实世界中,人们更换衣服是很常见的事情。为了解决行人换衣的问题,我们首先构建了一个大规模的换衣数据集-COCAS,该数据集中同一个人的图片衣服具有一定差异性,一共有5266个人,包含62382张图片。然后我们提出了新的re-id方案,它的查询图片由衣服模板和行人图片共同构成。最后,我们使用双分支的网络来分别提取衣服模板和行人图片各自的特征并融合。实验表明我们的re-id方案能够很好解决换衣场景下的行人重识别问题。

报告人:余世杰(指导老师:乔宇)

➤报告2. Unsupervised Domain Adaptation via Structurally Regularized Deep Clustering (通过结构正则化深度聚类解决无监督域适应问题)

摘要:无监督域适应(UDA)是去对一目标域上的无标签数据做预测,已知一源域上的有标签数据且其分布异于目标数据。主流UDA方法学习两个域之间对齐的特征,使得一个在源特征上训练的分类器能够容易地应用到目标特征。然而,这种迁移策略存在潜在的风险:破坏目标数据的固有可区分性。为了降低这个风险,我们受结构域相似性假设激励,提出通过目标数据的可区分聚类去发现固有目标可区分性。基于我们假设的结构域相似性,我们用结构源正则化约束聚类解。技术上,我们使用一个灵活的基于深度网络的可区分聚类框架,它最小化网络预测的标签分布与一个引入的辅助分布之间的KL散度;用源数据的真值标签分布代替辅助分布以通过一个简单的联合网络训练策略实现结构源正则化。我们称我们提出的方法为结构正则化深度聚类(SRDC),其中我们也用中间网络特征的聚类提高目标可区分性,用更相似源样本的软选择改善结构正则化。仔细的消融研究显示了我们提出的SRDC的效力。值得注意的是,没有显式的域对齐,SRDC在三个UDA基准数据集上都胜过所有存在的方法。

报告人:唐慧(指导老师:贾奎)

➤报告3. Learning to Detect Important People in Unlabelled Images for Semi-supervised Important People Detection (半监督焦点人物检测)

摘要:焦点人物检测任务是检测在社交事件图片中扮演最重要角色的个人,这需要模型理解图片中的高层次语义。然而,现有方法严重依赖于大量带详细标注的图像样本,收集图片标签耗时耗力。为了减少人工成本,本文提出了基于少量有标签样本和大量无标签样本训练的半监督焦点人物检测方法。本文模型通过迭代式地学习将伪标签分配给无标签图像中的每个人,并利用具有真实标签和伪标签的数据来更新检测模型。为了缓解伪标签不平衡问题,本文入了一种用于伪标签估计的排名策略,并引入了两种权重:一种权重用于表征无标签图片中对应人物为焦点人物的先验置信度,以加强对焦点人物的学习;另一个权重用来衡量图片的有效程度,从而忽略噪声图片(即没有焦点人物的图像)。本文收集了两个大型数据集进行评估,大量的实验结果表明了通过引用无标签图像可以有效地提升模型的检测能力,同时也有利于提升模型的泛化能力。

报告人:洪发挺(指导老师:郑伟诗)

➤报告4. Variational-EM-Based Deep Learning for Noise-Blind Image Deblurring (基于变分期望最大化深度学习的盲噪声图像去模糊)

摘要:非盲图像去模糊是图像复原中的一个重要问题。其重点是如何抑制去模糊过程中的噪声放大现象。在实践中,输入图像的噪声强度往往是未知的,且随不同的输入图像而变化。现有的基于学习的非盲图像去模糊方法在特定噪声强度范围内进行模型训练,以此来学习如何处理噪声强度的不确定性。本文旨在提出一种能显式处理噪声强度不确定性的深度学习方法。基于变分期望最大化框架,本文提出了一个去模糊的迭代方案,该迭代方案整合了对噪声强度的估计和对图像先验不确定性的量化。该方案展开成一个深度模型用于去模糊,其中图像先验用神经网络建模。大量实验表明本文所提出的方法能大大超过现有的盲噪声强度去模糊方法,而且能击败假设在已知噪声强度下训练的深度模型。

报告人:南岳松 (指导老师:全宇晖、纪辉)

➤报告5. Transferable, Controllable, and Inconspicuous Adversarial Attacks on Person Re-identificationWith Deep Mis-Ranking (基于深度误排序学习的行人重识别对抗攻击)

摘要:深度神经网络 (DNN) 的成功促使行人重识别的实际应用进入了新阶段,然而深度神经网络的脆弱性使得当今行人重识别系统的鲁棒性亟待探索,否则将引起严重的后果:如犯罪分子通过对抗攻击的方法欺骗闭路监控。为此,我们提出一种学习误排序的模型来扰乱系统输出的排序,以此检验了当今性能最好的若干种行人重识别模型的不安全性。由于跨数据集的可迁移性在行人重识别中至关重要,因此我们构建了多级网络体系结构进行半黑盒式攻击,该结构将不同级别的特征金字塔化,以提取对抗性扰动的一般和可传递特征。为了保证攻击的不可感知,我们还提出了可微分的采样来控制待攻击像素的数量,并联合优化一种新的感知损失,以实现更好的视觉质量。在四个最大的Re-ID基准数据集(即Market1501,CUHK03,DukeMTMC和MSMT17)上进行的广泛实验不仅显示了方法的有效性,而且还为re-ID系统的鲁棒性提供了未来改进的方向。例如,性能最好的系统之一的精度在受到我们方法的攻击后从91.8%急剧下降到1.4%。

报告人:王弘焌(指导老师:林倞)

➤报告6. Context-aware and Scale-insensitive Temporal Repetition Counting(上下文感知和对规模不敏感的动作重复计数)

摘要:时空动作重复计数的目的是估计给定重复动作的循环数。现有的深度学习方法假定重复动作是在固定的时间范围内执行的,这对于现实生活中的复杂重复动作是无效的。在本文中,我们量身定制了一个上下文感知且对规模不敏感的框架,以应对未知和不同周期长度所引起的重复计数挑战。我们的方法结合了两个关键的见解:(1)来自不同动作的循环长度是不可预测的,需要大规模搜索,但是,一旦确定了粗略的循环长度,则可以通过回归克服重复之间的差异。(2)确定周期长度不仅取决于视频的一小部分,还取决于上下文的理解。第一点是通过从粗到精的循环细化方法实现的。它避免了穷举性地穷举搜索视频中所有周期长度的繁琐计算,而是以粗略的方式传播了粗略预测,以便进一步完善。其次,我们提出了一种用于上下文感知预测的双向周期长度估计方法。它是一个回归网络,需要两个连续的粗略循环作为输入,并预测上一个和下一个重复循环的位置。为了使时间重复计数区域的训练和评估受益,我们构建了一个新的,最大的基准,其中包含526个具有不同重复动作的视频。大量实验表明,在单个数据集上训练的拟议网络在几个基准上均优于最新方法,这表明拟议框架足够通用,可以捕获跨域的重复模式。代码和数据可在https://github.com/Xiaodomgdomg/Deep-Temporal-Repetition-Counting中获得。

报告人:张怀东 (指导老师:何盛烽、徐雪妙)

➤报告7. Bidirectional Graph Reasoning Network for Panoptic Segmentation(双向图推理全景分割网络)

摘要:近期关于全景分割的研究多数采用了单个端到端的网络将实例分割和全景分割进行结合。但这些模型仅通过简单的多分支范式在网络结构层面将两个任务联系起来,或者通过单向的特征融合去处理两者的潜在的关联,这些方法忽略了前景和背景显式的语义关联和共现关系。由于环境信息在物体的识别和定位起到十分重要的作用,且前景物体的细节可以帮助背景的分割,我们因此尝试对前景和背景的关系进行显式建模以达到对全景分割中的图片进行整体统一的理解。我们提出了双向图推理网络(BGNet)将图结构引入到全景分割网络中以挖掘前景/背景分支内及分支间的关系。特别地,BGRNet首先针对每张输入图片在实例/语义分割分支中构造了对应的图以进行候选框级别和类别级别的推理。为了建立分支间的关联并充分利用前景和背景的互补关系,我们提出了双向图连接模块通过可学习的方式在分支间进行信息传播。我们的实验结果验证了BGRNet的有效性:BGRNet在COCO和ADE20K全景分割数据集上体现了优越的性能。

报告人:吴洋鑫 (指导老师:梁小丹、林倞)

➤报告8. ABCNet: Real-time Scene Text Spotting with Adaptive Bezier-Curve Network(ABCNet:实时自适应贝赛尔曲线场景文字检测识别网络)

摘要:场景文本的检测与识别越来越受到人们的重视。现有的方法大致可以分为两类:基于字符的方法和基于分段的方法。这些方法或者字符标注代价高昂,或者需要十分复杂的框架,而这通常不适用于实时应用程序。在这里,我们通过提出自适应贝齐曲线网络(ABCNet)来解决这个问题。我们的贡献有三:1)我们第一次提出通过参数化的Bezier曲线自适应地拟合任意形状的文本。2)设计了一种新颖的BezierAlign层,用于提取任意形状的文本实例的精确卷积特征,与以前的方法相比,该方法显著提高了精度。3)与标准边界盒检测相比,我们的Bezier曲线检测引入的计算开销可以忽略不计,使得该方法在效率和准确度上都具有优势。在任意形状的基准数据集(Total-Text和CTW1500)上进行的实验表明,ABCNet能够达到目前最先进的精度,同时显著提高了速度。特别是在Total-text上,我们的实时版本比最新的最先进的方法快10倍以上,识别精度也极具竞争力。代码已开源:https://github.com/aim-uofa/AdelaiDet。

报告人:刘禹良 (指导老师:沈春华,金连文)

➤报告9. Wavelet Integrated CNNs for Noise-Robust Image Classification(有效提升图像分类噪声鲁棒性的小波卷积网络)

摘要:卷积神经网络(CNN)易受噪声干扰,小的图像噪声可能造成网络输出剧烈变化。为抑制噪声对图像分类的影响,论文使用离散小波变换代替卷积神经网络中常用的下采样操作,如最大池化、步长卷积、均匀池化等。首先,构建适用于多种小波的通用离散小波变换和离散小波逆变换层,然后基于小波变换层设计用于图像分类的小波卷积网络(WaveCNet)。在小波卷积网络中,图像数据在下采样时被离散小波变换层分解为低频和高频分量。低频分量存储包括图像目标基本结构在内的主要信息,小波卷积网络从中提取图像分类特征。高频分量由于包含大量噪声,在网络推理时被丢弃,以提升网络噪声鲁棒性。在数据集ImageNet和ImageNet-C上的实验结果表明,小波卷积网络比一般卷积神经网络具有更高的分类精度和更好的噪声鲁棒性。

报告人:李秋富(指导老师:沈琳琳)

➤报告10. Intelligent Home 3D: Automatic 3D-House Design from Linguistic Descriptions Only(房屋设计智能化:基于用户自定义要求的3D房间自动设计研究)

摘要:房屋设计通常需要建筑师运用专业知识与工具来完成,过程复杂且繁琐。为让用户能亲自设计自己的房屋,本文提出房屋自动化设计框架。该框架只需输入房屋需求描述,即可自动生成房屋布局与房间纹理。具体来说,本文将房屋设计定义成面向语言描述的视觉内容生成问题,并将该问题进一步拆解为平面图生成与房间内部纹理生成两个子问题。针对上述问题,本文提出房屋设计生成模型(HPGM)。该模型首先将房屋需求描述转换为图结构表示,然后利用图卷积布局预测网络(GC-LPN)构建房屋布局,并通过语言引导生成对抗网络(LCT-GAN)合成房间内部纹理,最后使用3D渲染技术合成3D房屋模型图。同时,本文提出一个新的数据集(Text–to–3D House Model dataset),该数据集包括用户需求描述文本、住宅平面图以及房间纹理图。数据集与代码见网址:https://github.com/chenqi008/HPGM。

报告人:陈奇(指导老师:谭明奎、陈健、吴琦)

➤报告11. Interactive Two-Stream Decoder for Accurate and Fast Saliency Detection(基于交互式双流解码器的图像显著性检测)

摘要:提出一种基于图像显著性和轮廓交互编解码的显著性检测方法。具体地,我们首先分析了图像显著性和轮廓之间的相关性,然后提出了一个交互式的双流解码器来同时实现显著性检测、轮廓检测及两者的相关性建模。解码器由两个分支组成,一个显著分支和一个轮廓分支。中间连接迫使每个分支通过交互地将特征从每个分支传递到另一个分支来学习相关性。此外,我们还提出一种自适应轮廓损失函数来自动识别学习过程中的难样本。在六个数据集上进行的大量实验表明,我们的网络以大约50FPS的速度实现了相当好的性能。此外,我们基于VGG的模型只包含1708万个参数,这比其他基于VGG的方法要小得多。相关代码已经公开发布在https://github.com/moothes/ITSD-pytorch。

报告人:周华君(指导老师:谢晓华、赖剑煌)

➤报告12. Regularizing Discriminative Capability of CGANs for Semi-Supervised Generative Learning(基于对抗网络判别能力正则化的半监督生成学习)

摘要:半监督生成式学习算法是在只有数据集的一部分标签数据的情况下,学习数据集潜在的条件概率分布。在其对抗学习过程中,仍然存在着真实标签数据和生成数据的不平衡对抗的问题,需要我们进一步地去探讨。为了解决这个问题,我们提出了基于随机区域替换(R3-regularization)的正则化训练方法来促进生成式训练过程的性能提升。具体来说,我们为此构建了两种类间样本:一种是跨类别样本,另一种是跨真伪样本。我们认为这些样本距离决策边界更近,所以在条件生成式对抗模型(R3-GAN)中能够约束分类器以及判别器。上述两个网络的性能提升能够更好地引导生成器学习,促使生成器生成类别信息丰富以及逼真的样本。我们在多个基准数据集上进行实验并发现提出的R3-regularization能够同时提升分类器的性能以及生成样本质量。

报告人:邓广昌 (指导老师:吴斯)

04

参与方式

1. 本次在线会议免费参加,参与讨论提问人数限报200人(组委会将通过email发送会议ID给成功报名者,凭会议ID可进入在线会议室参与提问及讨论)。参与观看人数不限制。

由于这次分享非常受开发者欢迎,参与讨论的200人名额已经报名完毕。为了让更多的小伙伴也能参与学习讨论,小极特地为大家争取到了极市专属的额外20个名额。

2. 关注“极市平台”公众号,回复“56”或“CSIG”可获取参与讨论的报名链接和免费直播链接。

05

往期回顾

极市平台专注分享计算机视觉前沿资讯和技术干货,特邀请行业内专业牛人嘉宾为大家分享视觉领域内的干货及经验,目前已成功举办55期线上分享。近期在线分享可点击以下标题查看:

赛事集训直播 | 技术大咖带你揭秘世界人工智能创新大赛

谢恩泽|CVPR2020-PolarMask,一阶段实例分割新思路

邓富城&邱丹| 极市平台在线训练&英特尔®OpenVINO™加速深度学习推理

徐晨丰|ICCV2019-人群密度分析与计数(CV101榜单双料冠军方案)

李夏|ICCV2019:语义分割中的自注意力机制和低秩重建

朱政|基于孪生网络结构的SiamRPN系列目标跟踪算法

邓健康|CVPR2019:ArcFace 构建高效的人脸识别系统

张志鹏|CVPR2019:基于siamese网络的单目标跟踪

诸宸辰|CVPR2019:基于Anchor-free特征选择模块的单阶目标检测

王鑫龙|CVPR2019:联合分割点云中的实例和语义

张钊宁|算力限制下的目标检测实战及思考

小美&张德兵|分布式人脸识别及工业运用经验

高继扬|时序动作检测

孙书洋|CVPR 2018论文详解:光流导向特征在视频动作识别中的应用

邬书哲|基于卷积神经网络的鲁棒人脸检测

王蒙蒙|基于计算机视觉的目标跟踪算法概览

……

更多往期分享请浏览:极市计算机视觉技术分享集锦

(http://bbs.cvmart.net/topics/149/cvshare),也可以点击阅读原文获取。

在"极市平台"公众号后台回复期数或者分享嘉宾名字,即可获取极市平台对应期在线分享资料。

06

关于极市平台

极市(Extreme Mart)是深圳极视角科技有限公司旗下AI开发者生态,面向计算机视觉算法工程师,为开发者提供算法开发环境、真实数据项目实战、自动测试、加速工具、算法封装等全方位平台技术与工程支持,同时提供技术干货、大咖分享、社区交流、竞赛活动等丰富的内容与服务。

官网:www.cvmart.net