ACL 2022 | KGTuner: 针对知识图谱学习的高效超参数搜索算法

论文标题:

KGTuner: Efficient Hyper-parameter Search for Knowledge Graph Learning

收录会议:

ACL 2022

论文地址:

https://aclanthology.org/2022.acl-long.194.pdf

代码链接:

https://github.com/AutoML-Research/KGTuner

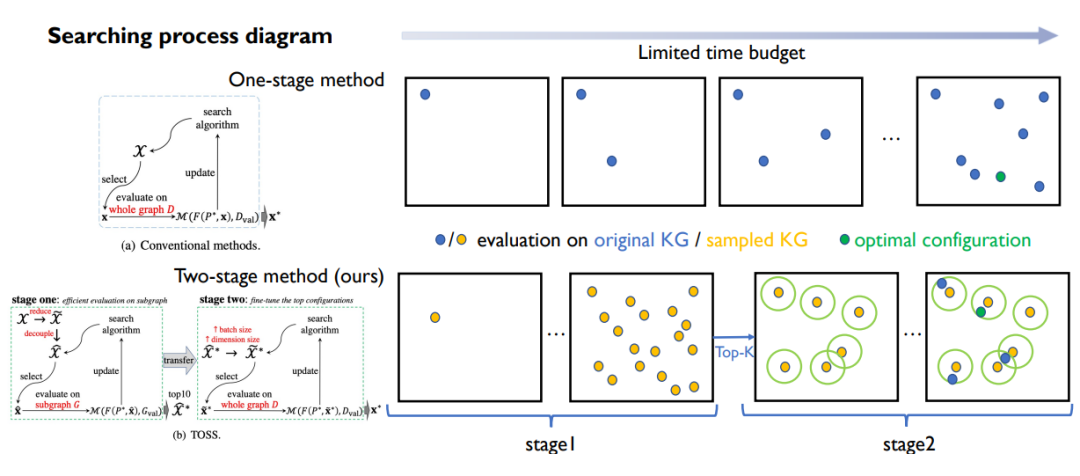

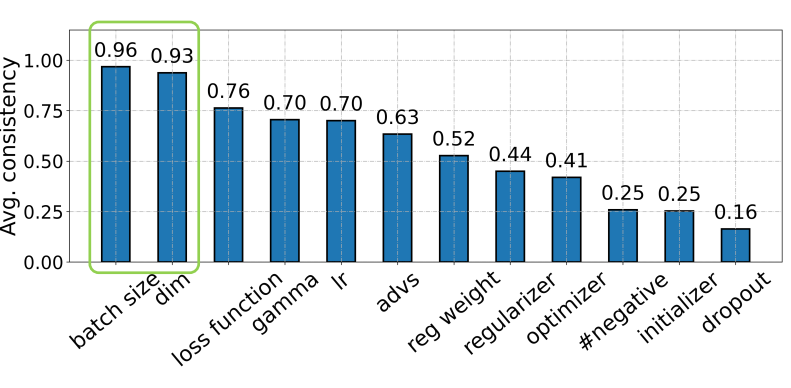

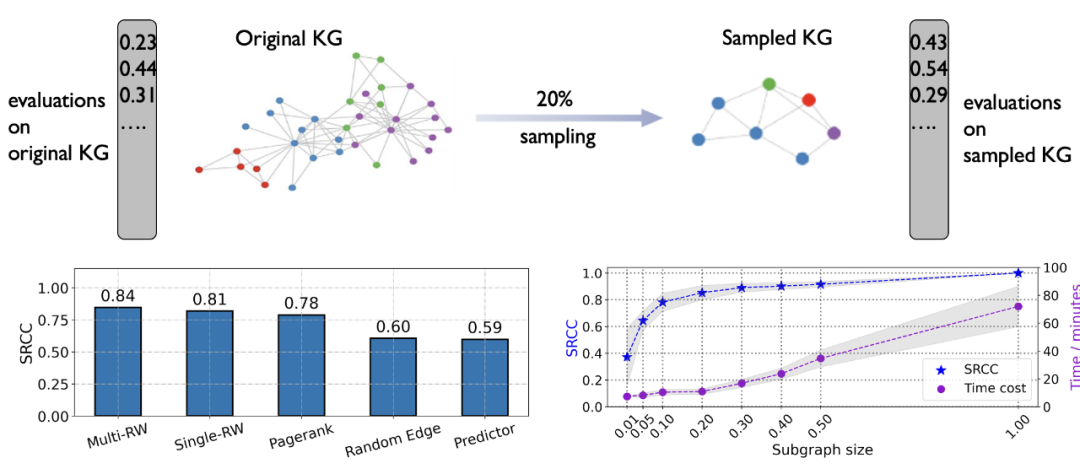

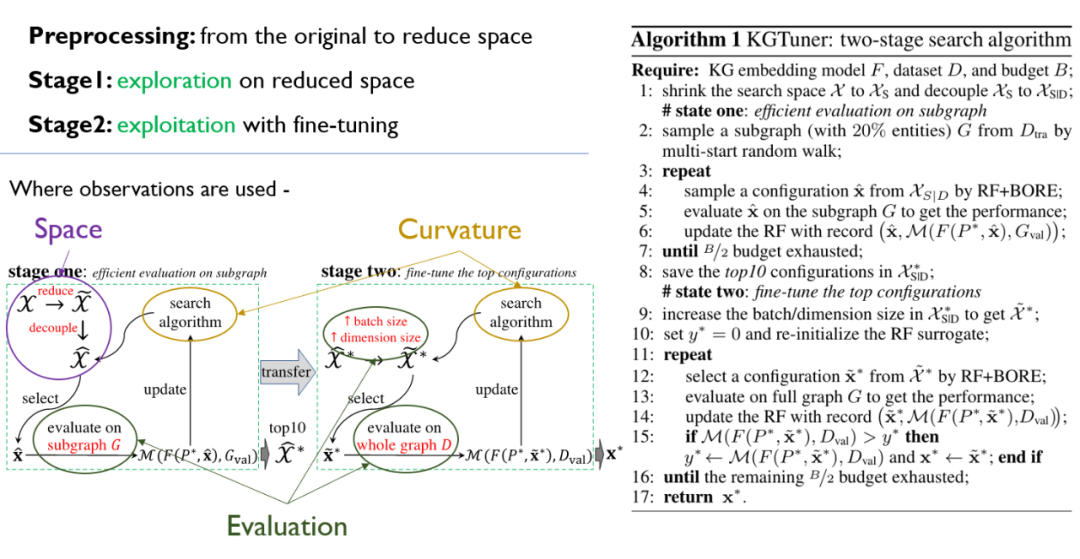

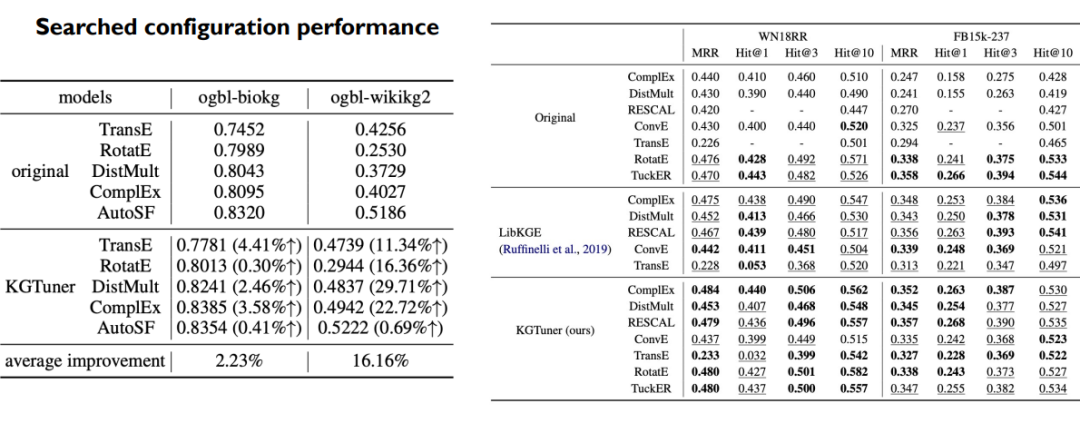

超参数搜索,是机器学习模型获得良好性能的关键。对于知识图谱的学习来说,同样是一个重要问题,一方面超参数的好坏会严重影响模型性能,另一方面模型训练时间长,现有的超参数搜索算法在这一问题上一个个尝试不同超参数配置,往往效率低下。为解决这一问题,我们详细地分析了知识图谱学习中不同超参数的性质,及子图到全图的迁移能力。

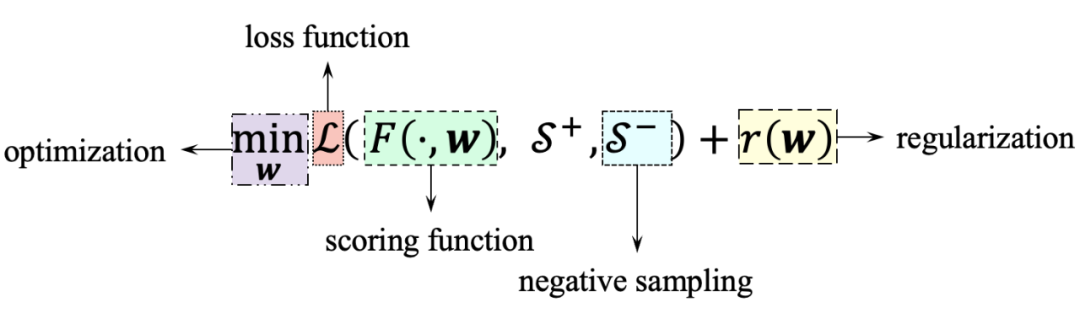

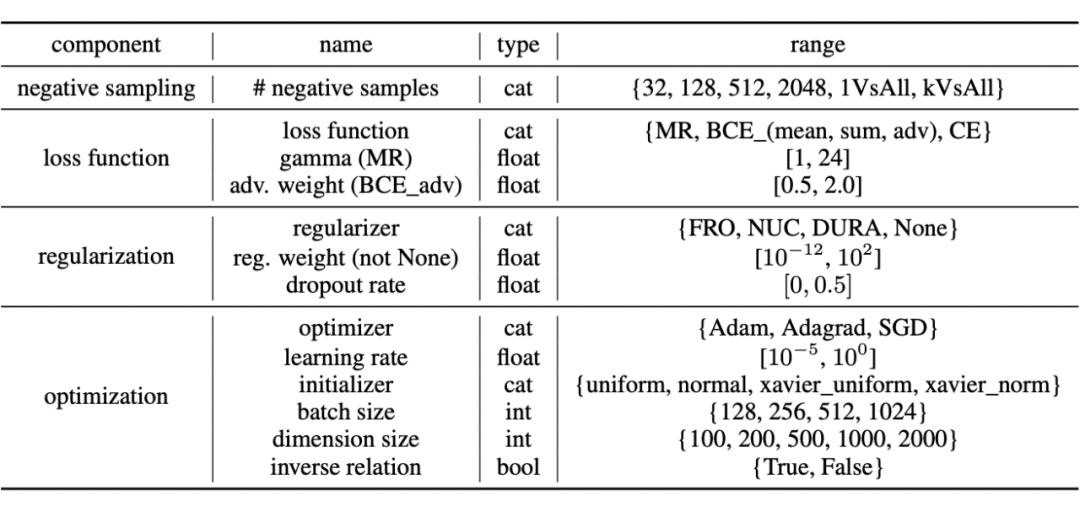

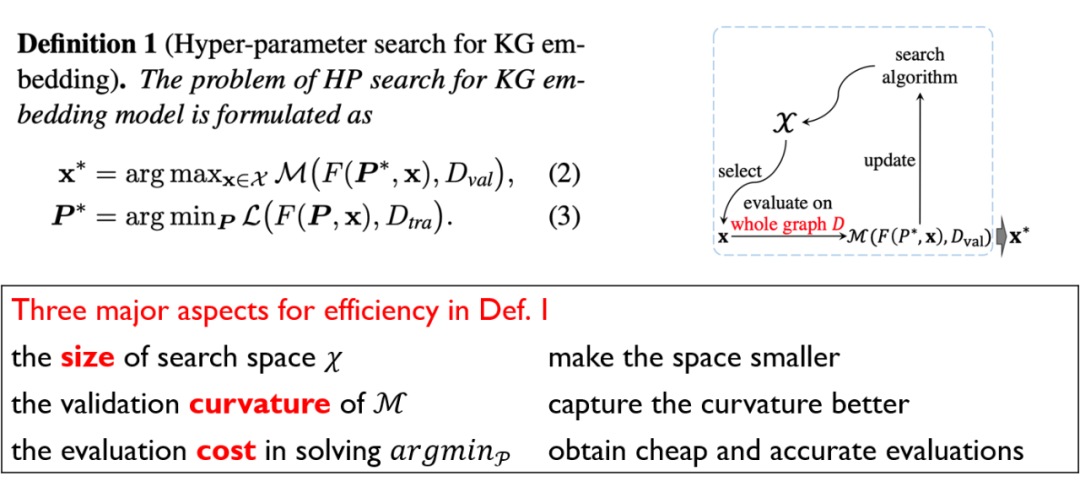

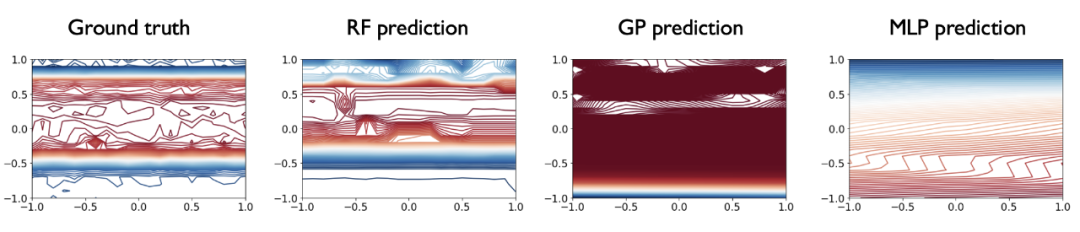

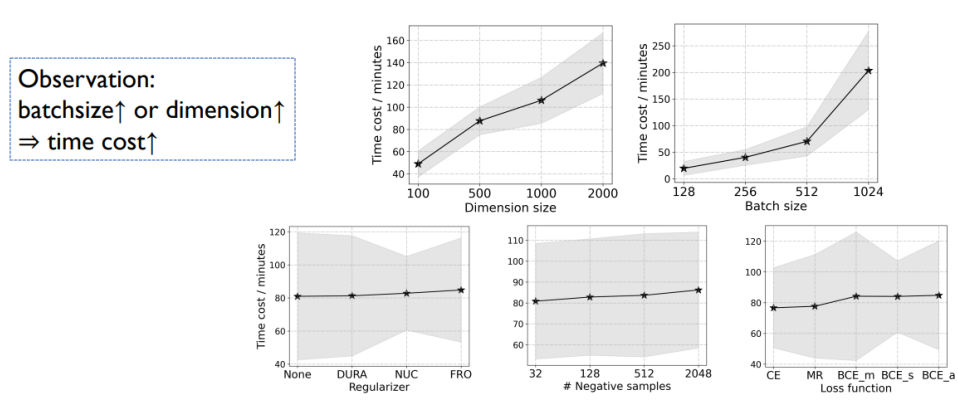

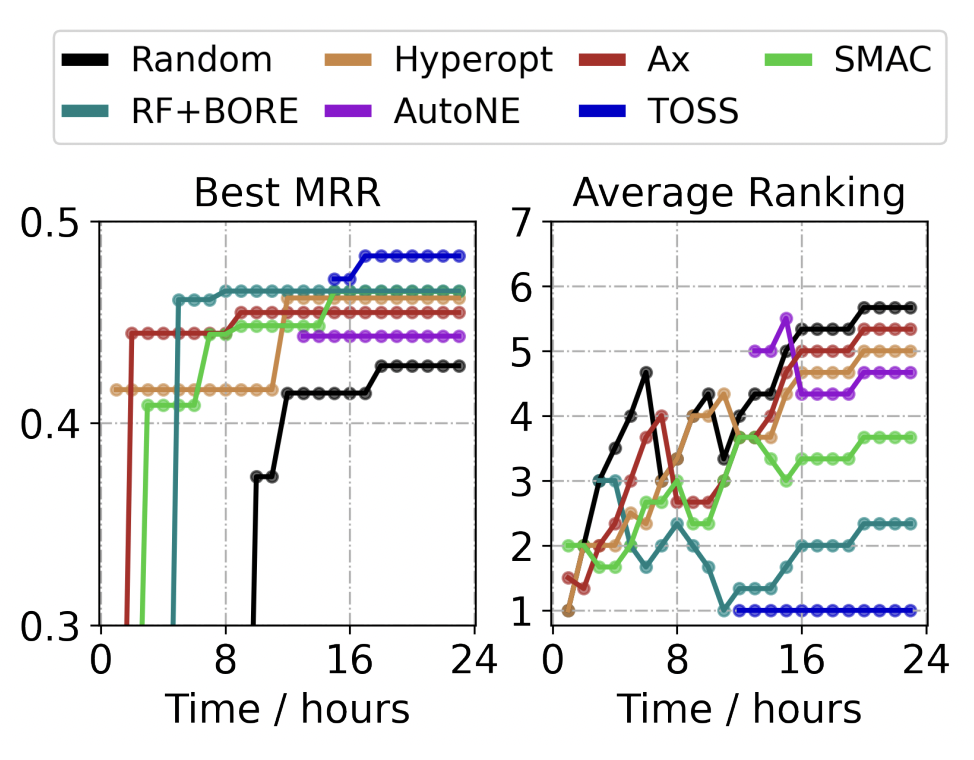

超参数搜索过程中,最关键的问题是效率,影响图4中搜索问题效率的主要有三个方面:(1)超参数搜索空间 的大小,决定了搜索范围;(2)反馈指标 的曲面分布,决定了哪种模型可以更好地模拟超参数空间;(3)模型训练 的开销,决定了评估单个超参数配置的效率。

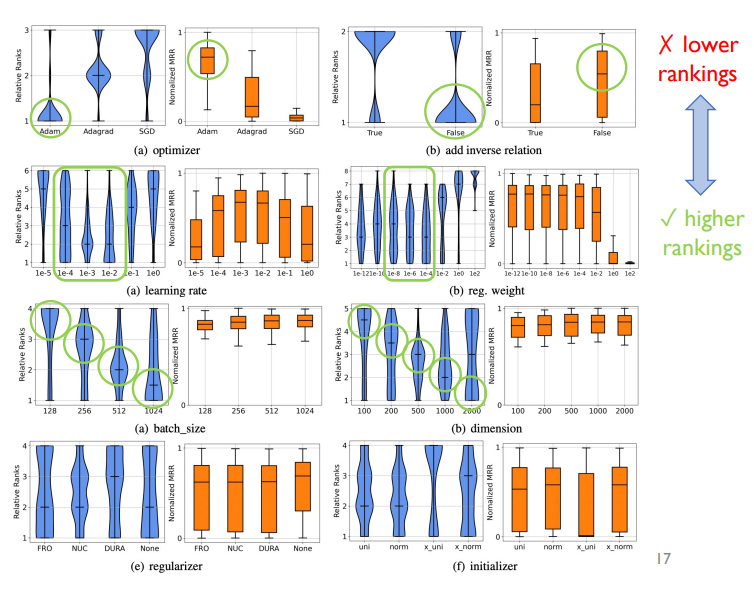

▲ 图5. 不同组超参数表现分布图。蓝色小提琴图度量排名分布,越低越好。橙色箱线图度量性能分布,越高越好

招聘启事

清华大学电子系机器学习课题组招聘博士后,合作导师为姚权铭助理教授。

课题组主页:

https://lars-group.github.io/

招聘详情:

相关文献

[1] A Survey on Knowledge Graphs: Representation, Acquisition and Applications. TNNLS 2022.

[2] You CAN Teach an Old Dog New Tricks! On Training Knowledge Graph Embeddings. ICLR 2020.

[3] Bilinear Scoring Function Search for Knowledge Graph Learning. TPAMI 2022

[4] Translating Embeddings for Modeling Multi-relational Data. NeurIPS 2013

[5] Convolutional 2D Knowledge Graph Embeddings. AAAI 2018

[6] Complex Embeddings for Simple Link Prediction. ICML 2017

[7] Algorithms for Hyper-Parameter Optimization. NeurIPS 2011

[8] BORE: Bayesian Optimization by Density-Ratio Estimation. ICML 2021

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧