自带迷幻剂技能的小贴纸:忽悠神经网络,让它将一切都当作烤面包机!

大数据文摘作品

编译:Katrine.Ren、元元

当下的图像识别技术看似愈发成熟了,但自带蠢萌属性的它实际上依然可以被轻易愚弄。

研究人员最近就成功忽悠了一把以智能著称的算法,让它们一脸懵逼地犯下了一系列错误:

比如把两个滑雪的人辨识为一只狗,把一个棒球看成是一杯意式咖啡,又例如把一只乌龟误认为是一把步枪。

最新的一个欺骗机器的方法操作更为简单,却有更深远的影响,所需要的道具也仅仅是一张简陋的贴纸而已。

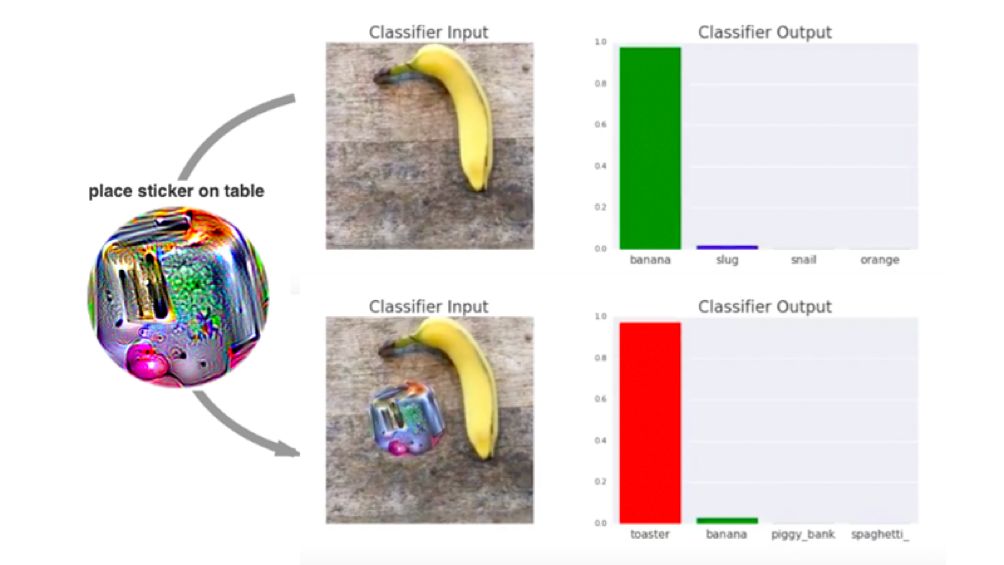

图注按顺序为:将贴纸放在桌上,输入分类器的图像,分类器输出结果

这款由谷歌的研究人员新近开发的自带迷幻剂属性的小贴纸可是相当厉害了。只要将它放在任何一张图片上,深度学习系统就会傻乎乎地把毫无关联的图像分辨为一部烤面包机。

据一篇最近提交的和这个神经网络攻击有关的研究论文所述,这块小小的“狗皮膏药”(对抗性补丁)是具有“场景无关性”的,这意味着任何一个“对光照条件、相机角度、被攻击的分类器类型或甚至场景中的其他事物没有事先了解”的人都可以利用这张贴纸,去实行对图像识别算法的攻击。

相关研究论文的arxiv链接:https://arxiv.org/abs/1712.09665

再加上贴纸本身可以在网络上被分享和打印出来,这个攻击方法简直是唾手可得。

一个由谷歌深度学习研究团队Google Brain的成员Tom Brown上传的油管视频,就展示了这块对抗性补丁是怎样作用于一张香蕉的图片上的。

点击查看相关视频👇

起先,一只香蕉放在桌上的图片是能够被VGG16这个神经网络正确识别为“香蕉”的,但把迷幻小贴纸放置于香蕉旁边后,神经网络随即把图片分类成了“烤面包机”。

正如研究人员在论文中所述,这个小把戏背后的原理,是深度学习模型其实每次只能探测到图像中最“显眼”的那个物品。

“对抗性补丁正是利用了这一特性,通过生成远远比真实物体显眼得多的图像输入(从而欺骗了模型)。”同时,研究人员在论文中写道,“因此,在攻击物体探测或是图像细分模型的时候,我们希望被定为识别目标的烤面包机贴纸一方面能被分辨为‘烤面包机’,另一方面也不会对图像本身的其他部分造成影响。”

即使现在研究人员已经有了许多种让机器学习算法产生视觉错误的方法,这个办法却因其简易操作且难以察觉的特点而显得尤为重要。

“即使人类能够注意到这些贴纸的存在,他们未必理解这些贴纸的真正意图,反而误认为这是某种艺术的表现形式。”研究人员如是说。

目前而言,让机器把一根香蕉看成是一部烤面包机的小恶作剧并不会对社会造成什么实际的危害。但随着我们这个世界的运行开始越来越依赖图像识别技术,这种操作简单的方法在将来很有可能会造成严重的破坏。

最重要的是随着无人驾驶技术的普及,这些智能汽车非常依赖于图像识别软件来理解它们周边的环境并与之互动。试想成千上万坨大型重磅的金属块在高速公路上飞驰时只看得见烤面包机,这将是一件多么危险的事情。

原文链接:https://gizmodo.com/this-simple-sticker-can-trick-neural-networks-into-thin-1821735479

【今日机器学习概念】

Have a Great Definition

志愿者介绍

回复“志愿者”加入我们