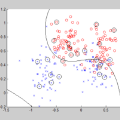

Our work aims to minimize interaction in secure computation due to the high cost and challenges associated with communication rounds, particularly in scenarios with many clients. In this work, we revisit the problem of secure aggregation in the single-server setting where a single evaluation server can securely aggregate client-held individual inputs. Our key contribution is the introduction of One-shot Private Aggregation ($\mathsf{OPA}$) where clients speak only once (or even choose not to speak) per aggregation evaluation. Since each client communicates only once per aggregation, this simplifies managing dropouts and dynamic participation, contrasting with multi-round protocols and aligning with plaintext secure aggregation, where clients interact only once. We construct $\mathsf{OPA}$ based on LWR, LWE, class groups, DCR and demonstrate applications to privacy-preserving Federated Learning (FL) where clients \emph{speak once}. This is a sharp departure from prior multi-round FL protocols whose study was initiated by Bonawitz et al. (CCS, 2017). Moreover, unlike the YOSO (You Only Speak Once) model for general secure computation, $\mathsf{OPA}$ eliminates complex committee selection protocols to achieve adaptive security. Beyond asymptotic improvements, $\mathsf{OPA}$ is practical, outperforming state-of-the-art solutions. We benchmark logistic regression classifiers for two datasets, while also building an MLP classifier to train on MNIST, CIFAR-10, and CIFAR-100 datasets. We build two flavors of $\caps$ (1) from (threshold) key homomorphic PRF and (2) from seed homomorphic PRG and secret sharing.

翻译:本研究旨在最小化安全计算中的交互,因为通信轮次成本高昂且面临诸多挑战,尤其是在多客户端场景中。我们重新审视了单服务器设置下的安全聚合问题,其中单个评估服务器能够安全地聚合客户端持有的个体输入。我们的核心贡献是提出了单次隐私聚合($\mathsf{OPA}$),在该方案中,每个客户端在每次聚合评估中仅需通信一次(甚至可选择不通信)。由于每个客户端每次聚合仅通信一次,这简化了处理客户端退出和动态参与的管理,与多轮协议形成对比,并与明文安全聚合(客户端仅交互一次)的理念一致。我们基于LWR、LWE、类群、DCR构建了$\mathsf{OPA}$,并展示了其在隐私保护联邦学习(FL)中的应用,其中客户端仅需通信一次。这与先前由Bonawitz等人(CCS,2017)开创的多轮FL协议研究形成显著区别。此外,与面向通用安全计算的YOSO(You Only Speak Once)模型不同,$\mathsf{OPA}$无需复杂的委员会选择协议即可实现自适应安全性。除了渐进性改进,$\mathsf{OPA}$具有实用性,性能优于现有最优解决方案。我们针对两个数据集对逻辑回归分类器进行了基准测试,同时构建了MLP分类器在MNIST、CIFAR-10和CIFAR-100数据集上进行训练。我们构建了两种$\mathsf{OPA}$变体:(1)基于(门限)密钥同态PRF;(2)基于种子同态PRG和秘密共享。