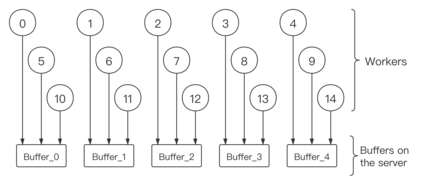

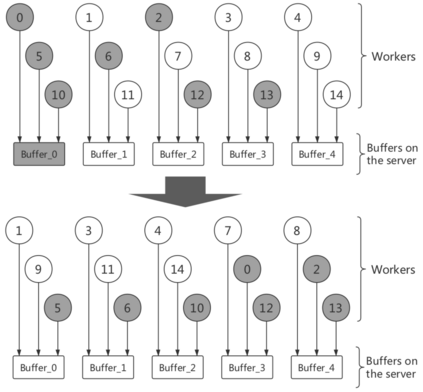

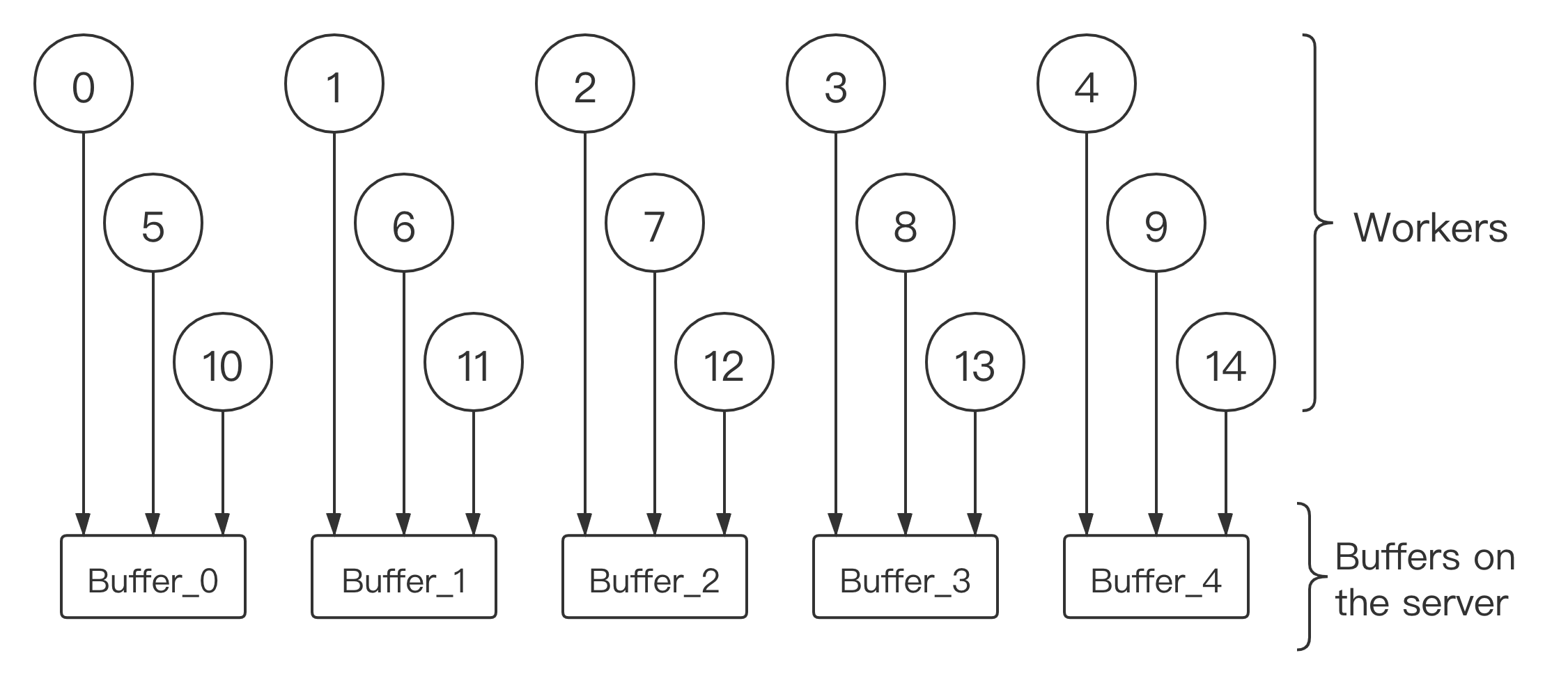

Distributed learning has become a hot research topic due to its wide application in clusterbased large-scale learning, federated learning, edge computing and so on. Most traditional distributed learning methods typically assume no failure or attack. However, many unexpected cases, such as communication failure and even malicious attack, may happen in real applications. Hence, Byzantine learning (BL), which refers to distributed learning with failure or attack, has recently attracted much attention. Most existing BL methods are synchronous, which are impractical in some applications due to heterogeneous or offline workers. In these cases, asynchronous BL (ABL) is usually preferred. In this paper, we propose a novel method, called buffered asynchronous stochastic gradient descent (BASGD), for ABL. To the best of our knowledge, BASGD is the first ABL method that can resist non-omniscient attacks without storing any instances on server. Furthermore, we also propose an improved variant of BASGD, called BASGD with momentum (BASGDm), by introducing momentum into BASGD. BASGDm can resist both non-omniscient and omniscient attacks. Compared with those methods which need to store instances on server, BASGD and BASGDm have a wider scope of application. Both BASGD and BASGDm are compatible with various aggregation rules. Moreover, both BASGD and BASGDm are proved to be convergent and be able to resist failure or attack. Empirical results show that our methods significantly outperform existing ABL baselines when there exists failure or attack on workers.

翻译:分散式学习由于在基于集束的大型学习、联合学习、边际计算等中广泛应用,已成为一个热门的研究课题。大多数传统的分散式学习方法通常不发生失败或攻击。然而,许多意外案例,如通信失败甚至恶意攻击,可能发生在实际应用中。因此,Byzantine学习(BL),指以失败或攻击的方式分散学习,最近引起了很大的注意。大多数现有的BL方法是同步的,由于混杂或离线工人在某些应用中是不切实际的。在这些情况下,通常倾向于采用非同步的 BL(ABL) (ABL) (ABL) (ABL) (ABL) (ABL) (ABL) 。在本文中,我们提出了一个新颖的方法,称为缓冲性不协调性梯梯梯(BSGD) (BG) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (B) (S) (的(B) (B) (B) (B) (B) (B) (S) (S (S) (S) (S) (S) (S(B) (S) (S) (S (S) (S) (S) (S) (S) (S) (S) (的(B) (B) (S) (B) (S) (S) (S(S) (S) (S) (S) (S) (S (S (操作性(B) (B) (B) (的(B) (B) (S) (S) (S(B) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (S) (B) (B) (S) (S) (S(B) (S(B) (B) (S(B) (B) (S)))) (S) (S) (S) (S) (B) (S) () (S) (S) (S) (S) (B) (S) (S) (S) (S) (S) (S) (