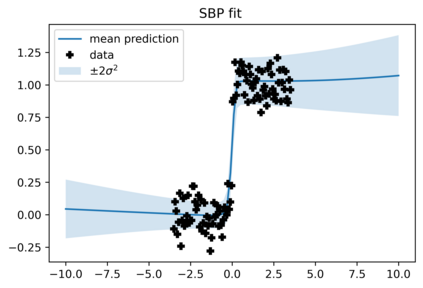

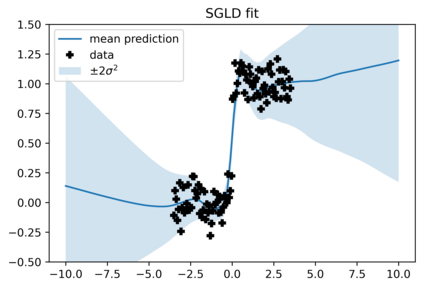

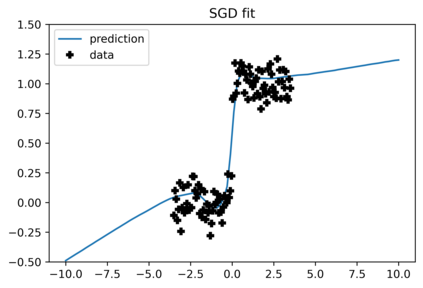

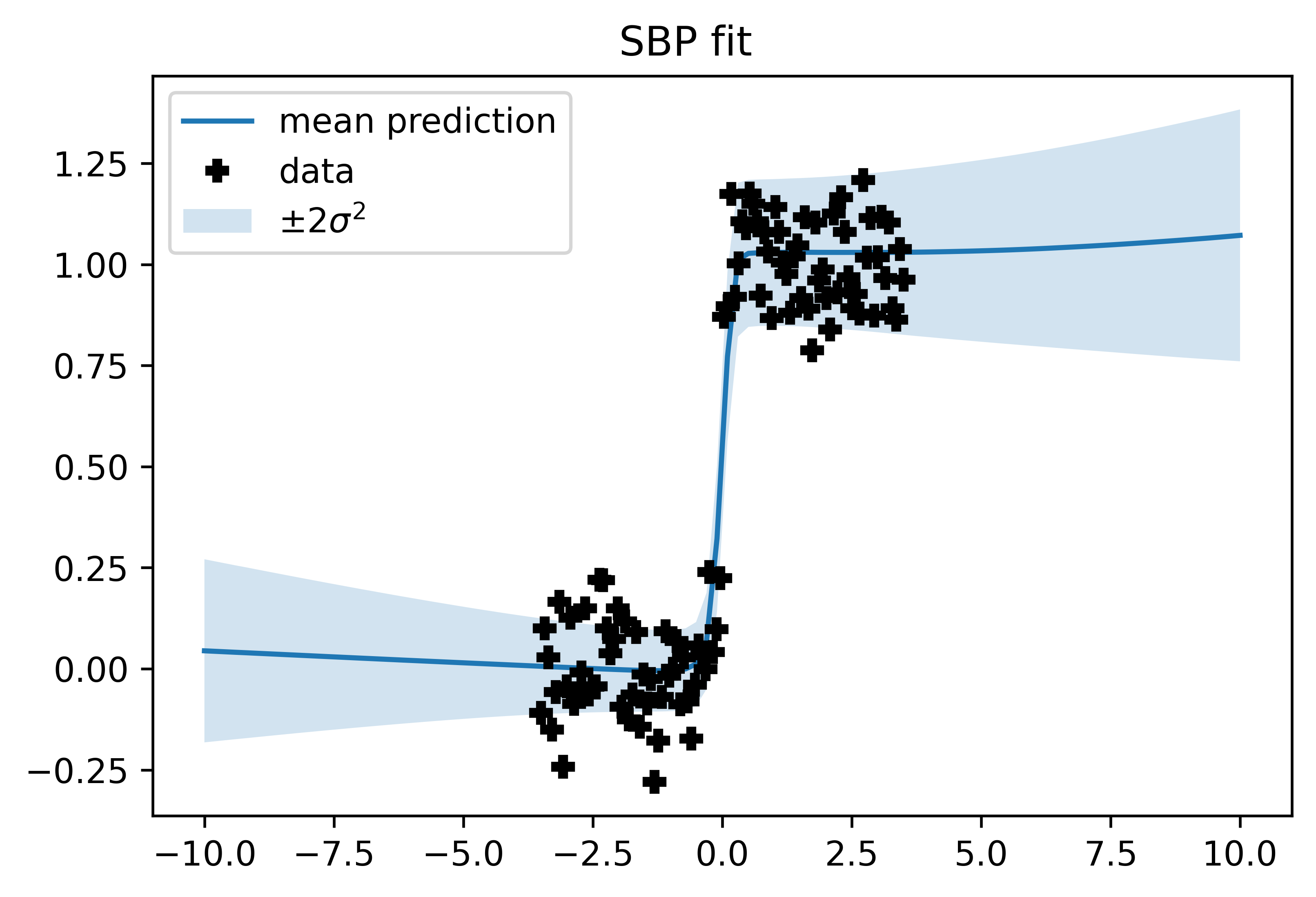

In this work we explore a new framework for approximate Bayesian inference in large datasets based on stochastic control. We advocate stochastic control as a finite time alternative to popular steady-state methods such as stochastic gradient Langevin dynamics (SGLD). Furthermore, we discuss and adapt the existing theoretical guarantees of this framework and establish connections to already existing VI routines in SDE-based models.

翻译:在这项工作中,我们探索了一种基于随机控制的大型数据集中近似贝叶斯式推论的新框架。 我们主张将随机控制作为流行的稳态方法(如悬浮梯度Langevin动态(SGLD))的有限替代时间。 此外,我们讨论并调整了这一框架的现有理论保障,并建立了与基于SDE模式的现有六种例行程序的联系。

相关内容

【变分推断课件】Lectures on Variational Inference: Approximate Bayesian Inference in Machine Learning(附带pdf)

专知会员服务

35+阅读 · 2019年11月30日

Arxiv

0+阅读 · 2022年1月28日