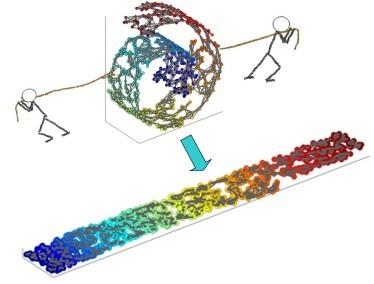

We provide a new interpretation of Hessian locally linear embedding (HLLE), revealing that it is essentially a variant way to implement the same idea of locally linear embedding (LLE). Based on the new interpretation, a substantial simplification can be made, in which the idea of "Hessian" is replaced by rather arbitrary weights. Moreover, we show by numerical examples that HLLE may produce projection-like results when the dimension of the target space is larger than that of the data manifold, and hence one further modification concerning the manifold dimension is suggested. Combining all the observations, we finally achieve a new LLE-type method, which is called tangential LLE (TLLE). It is simpler and more robust than HLLE.

翻译:我们对Hessian本地线性嵌入(HLLE)提供了一种新的解释,揭示了它基本上是执行同一本地线性嵌入(LLE)概念的一种变式方式。根据新的解释,可以大大简化,用相当任意的权重取代“Hessian”概念。此外,我们通过数字实例显示,当目标空间的尺寸大于数据方位时,HLE可能会产生类似投影的结果,因此建议对多维度作出进一步修改。结合所有观察,我们最终实现了一种新的LLLLE类型方法,即相近LLLE(TLE),它比HLLLE更简单、更有力。