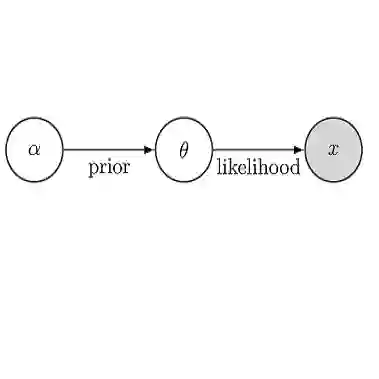

We consider Bayesian inference for large scale inverse problems, where computational challenges arise from the need for repeated evaluations of an expensive forward model. This renders most Markov chain Monte Carlo approaches infeasible, since they typically require $O(10^4)$ model runs, or more. Moreover, the forward model is often given as a black box or is impractical to differentiate. Therefore derivative-free algorithms are highly desirable. We propose a framework, which is built on Kalman methodology, to efficiently perform Bayesian inference in such inverse problems. The basic method is based on an approximation of the filtering distribution of a novel mean-field dynamical system into which the inverse problem is embedded as an observation operator. Theoretical properties of the mean-field model are established for linear inverse problems, demonstrating that the desired Bayesian posterior is given by the steady state of the law of the filtering distribution of the mean-field dynamical system, and proving exponential convergence to it. This suggests that, for nonlinear problems which are close to Gaussian, sequentially computing this law provides the basis for efficient iterative methods to approximate the Bayesian posterior. Ensemble methods are applied to obtain interacting particle system approximations of the filtering distribution of the mean-field model; and practical strategies to further reduce the computational and memory cost of the methodology are presented, including low-rank approximation and a bi-fidelity approach. The effectiveness of the framework is demonstrated in several numerical experiments, including proof-of-concept linear/nonlinear examples and two large-scale applications: learning of permeability parameters in subsurface flow; and learning subgrid-scale parameters in a global climate model from time-averaged statistics.

翻译:我们认为,对于大规模反向问题,巴耶斯的推论是大规模的反向问题,因为需要反复评估昂贵的远期模型,从而产生计算上的挑战。这使得大多数马尔科夫链的蒙特卡洛·蒙泰·卡洛(Markov 链路的Monte Carlo)的方法不可行,因为它们通常需要10美元或更多的模式运行。此外,远期模型往往被作为黑盒列出,或者不切实际区分。因此,无衍生的算法是非常可取的。我们提议了一个框架,它建立在卡尔曼方法上,以便有效地在这种反向问题中执行巴耶斯的推论。 基本方法基于对新颖的平均值动态参数的过滤分布的近似性分布,使反向的问题嵌入一个全新的中线性动态参数。 平均值模型的理论特性是直径直线化的直径直线性参数分布系统,包括直径直的近的基比对流法的精确度分析方法。