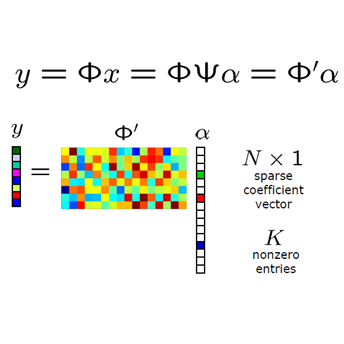

We study a deep linear network endowed with a structure. It takes the form of a matrix $X$ obtained by multiplying $K$ matrices (called factors and corresponding to the action of the layers). The action of each layer (i.e. a factor) is obtained by applying a fixed linear operator to a vector of parameters satisfying a constraint. The number of layers is not limited. Assuming that $X$ is given and factors have been estimated, the error between the product of the estimated factors and $X$ (i.e. the reconstruction error) is either the statistical or the empirical risk. In this paper, we provide necessary and sufficient conditions on the network topology under which a stability property holds. The stability property requires that the error on the parameters defining the factors (i.e. the stability of the recovered parameters) scales linearly with the reconstruction error (i.e. the risk). Therefore, under these conditions on the network topology, any successful learning task leads to stably defined features and therefore interpretable layers/network.In order to do so, we first evaluate how the Segre embedding and its inverse distort distances. Then, we show that any deep structured linear network can be cast as a generic multilinear problem (that uses the Segre embedding). This is the {\em tensorial lifting}. Using the tensorial lifting, we provide necessary and sufficient conditions for the identifiability of the factors (up to a scale rearrangement). We finally provide the necessary and sufficient condition called \NSPlong~(because of the analogy with the usual Null Space Property in the compressed sensing framework) which guarantees that the stability property holds. We illustrate the theory with a practical example where the deep structured linear network is a convolutional linear network. As expected, the conditions are rather strong but not empty. A simple test on the network topology can be implemented to test if the condition holds.

翻译:我们研究一个具有结构的深度线性网络。 它的形式是, 通过乘以 $K 矩阵( 所谓的因子和与层的动作相对应) 获得的矩阵 $X 。 每层( 因子) 的动作都是通过对满足限制的参数矢量应用固定线性操作器获得的 。 层数并不有限 。 假设给出了 $X, 并估算了各种因素, 估计因素的产品与 $X ( 重建错误) 之间的错误要么是统计或经验风险 。 在本文中, 我们在网络表情表情上提供了必要条件的矩阵( 重建错误) 。 我们首先评估了Segre 嵌入 和 必要的直线性距 。 然后, 稳定性属性要求参数上的错误( 恢复参数的稳定性) 与重建错误( 风险 ) 等。 因此, 在网络的这些条件下, 任何成功的学习任务都可能导致 直线性特征的波动, 因而可以解释 。 为了做到这一点, 我们首先评估 如何将Segreal 嵌嵌嵌入和必要的直线性距离 。 。 然后, 我们使用任何结构 的网络的系统 测试是用来显示 。