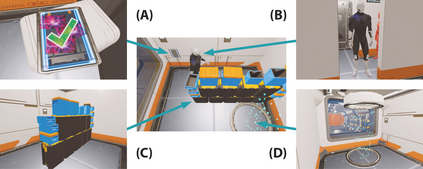

Using virtual reality setups, users can fade out of their surroundings and dive fully into a thrilling and appealing virtual environment. The success of such immersive experiences depends heavily on natural and engaging interactions with the virtual world. As developers tend to focus on intuitive hand controls, other aspects of the broad range of full-body capabilities are easily left vacant. One repeatedly overlooked input modality is the user's gait. Even though users may walk physically to explore the environment, it usually does not matter how they move. However, gait-based interactions, using the variety of information contained in human gait, could offer interesting benefits for immersive experiences. For instance, stealth VR-games could profit from this additional range of interaction fidelity in the form of a sneaking-based input modality. In our work, we explore the potential of sneaking as a playful input modality for virtual environments. Therefore, we discuss possible sneaking-based gameplay mechanisms and develop three technical approaches, including precise foot-tracking and two abstraction levels. Our evaluation reveals the potential of sneaking-based interactions in IVEs, offering unique challenges and thrilling gameplay. For these interactions, precise tracking of individual footsteps is unnecessary, as a more abstract approach focusing on the players' intention offers the same experience while providing better comprehensible feedback. Based on these findings, we discuss the broader potential and individual strengths of our gait-centered interactions.

翻译:使用虚拟现实设置,用户可以从周围的周围消失,并充分潜入刺激和吸引人的虚拟环境。这种沉浸式体验的成功在很大程度上取决于自然和与虚拟世界的互动。由于开发者往往侧重于直觉的手控,大量全体能力的其他方面很容易被空置。一个一再被忽略的投入模式是用户的动作。即使用户可以亲身步行探索环境,但通常并不重要。然而,借助人类行踪中包含的各种信息,以步态为基础的互动可以为沉浸式体验带来有趣的好处。例如,隐形VR游戏可以从更多一系列的互动忠诚中获益,其形式是潜入式的输入模式。在我们的工作中,我们探索潜入为虚拟环境的玩耍模式的可能性。因此,我们讨论可能的潜入式游戏机制,并开发三种技术方法,包括精确的脚跟踪和两个抽象层次。我们的评估显示,在IVES中偷偷潜入式互动的潜力,提供更深层次的视觉回馈,提供更深层次的视觉回馈,同时提供更精确的自我回溯性回馈方法。