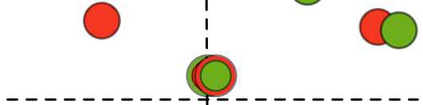

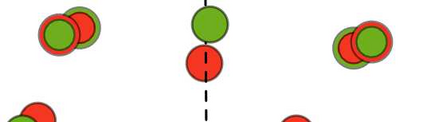

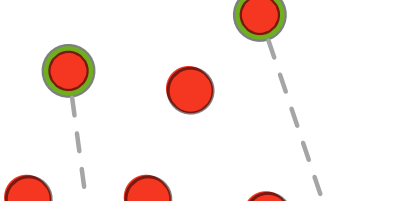

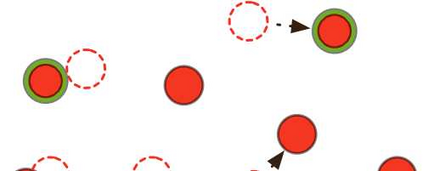

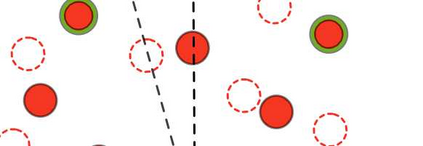

Bilingual lexicon induction induces the word translations by aligning independently trained word embeddings in two languages. Existing approaches generally focus on minimizing the distances between words in the aligned pairs, while suffering from low discriminative capability to distinguish the relative orders between positive and negative candidates. In addition, the mapping function is globally shared by all words, whose performance might be hindered by the deviations in the distributions of different languages. In this work, we propose a novel ranking-oriented induction model RAPO to learn personalized mapping function for each word. RAPO is capable of enjoying the merits from the unique characteristics of a single word and the cross-language isomorphism simultaneously. Extensive experimental results on public datasets including both rich-resource and low-resource languages demonstrate the superiority of our proposal. Our code is publicly available in \url{https://github.com/Jlfj345wf/RAPO}.

翻译:现有的方法一般侧重于尽可能缩短对等词中字词的距离,同时在区分正候选人和负候选人之间相对顺序方面缺乏歧视能力;此外,制图功能由所有字词在全球共享,其性能可能因不同语言分布的偏差而受到阻碍;在这项工作中,我们建议采用新的、注重等级的上岗模式RAPO,以学习每个字个性化绘图功能。RAPO能够同时享受单词和跨语言的异式特征的优点。关于公共数据集的广泛实验结果,包括丰富资源和低资源语言,显示了我们提案的优势。我们的代码可在以下网站公开查阅:https://github.com/Jlfj345wf/RAPO}。