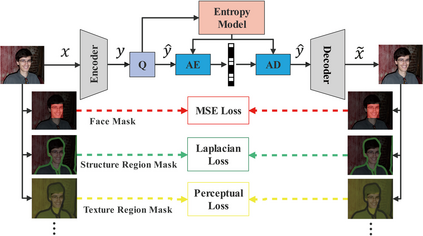

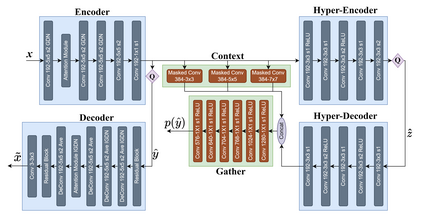

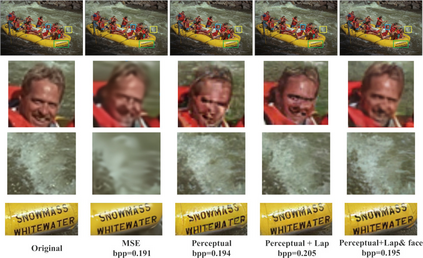

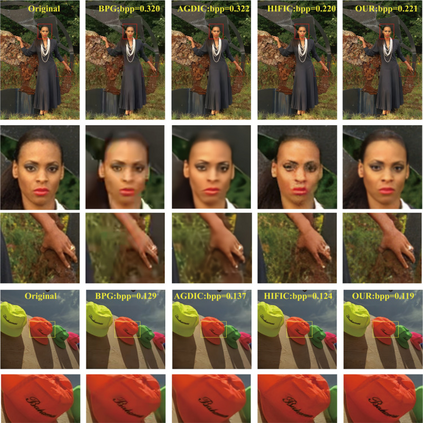

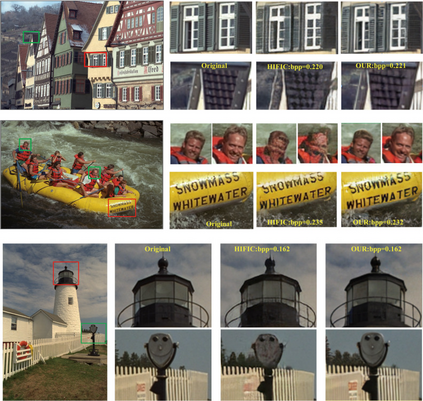

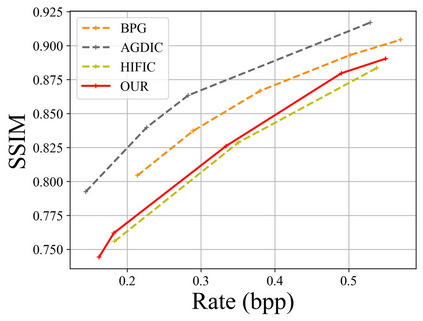

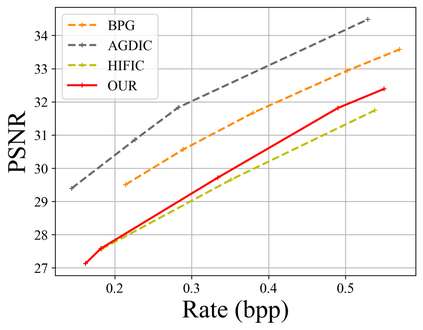

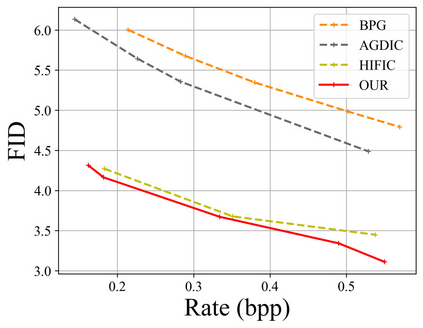

In recent years, with the development of deep neural networks, end-to-end optimized image compression has made significant progress and exceeded the classic methods in terms of rate-distortion performance. However, most learning-based image compression methods are unlabeled and do not consider image semantics or content when optimizing the model. In fact, human eyes have different sensitivities to different content, so the image content also needs to be considered. In this paper, we propose a content-oriented image compression method, which handles different kinds of image contents with different strategies. Extensive experiments show that the proposed method achieves competitive subjective results compared with state-of-the-art end-to-end learned image compression methods or classic methods.

翻译:近年来,随着深层神经网络的发展,端到端优化图像压缩取得了显著进展,超过了标准扭曲性能的经典方法,但是,大多数基于学习的图像压缩方法没有标签,在优化模型时不考虑图像语义或内容。事实上,人类的眼睛对不同内容有不同的敏感性,因此图像内容也需要考虑。在本文中,我们提出了一个面向内容的图像压缩方法,该方法处理不同类型的图像内容,采用不同的策略。广泛的实验表明,拟议方法与最先进的端到端端图像压缩方法或经典方法相比,具有竞争性的主观结果。