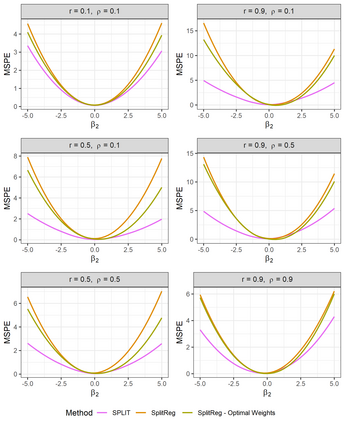

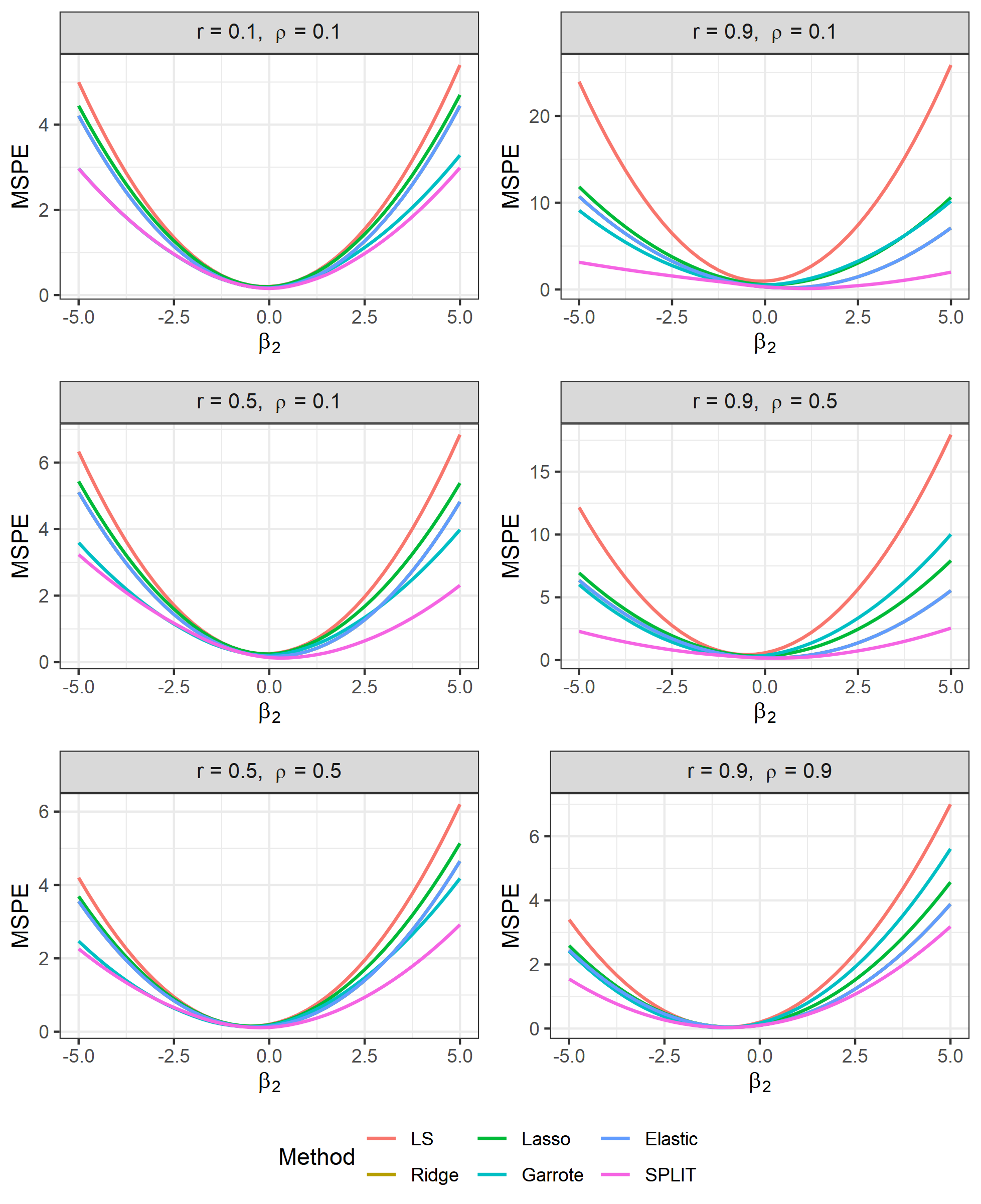

In this note we study the benefits of splitting variables variables for reducing the variance of linear functions of the regression coefficient estimate. We show that splitting combined with shrinkage can result in estimators with smaller mean squared error compared to popular shrinkage estimators such as Lasso, ridge regression and garrote.

翻译:在本说明中,我们研究了分解变量对减少回归系数估计线性功能差异的好处。 我们发现,分解与缩水相结合,与拉索、山脊回归和加罗特等流行的缩水估计值相比,可能导致误差较小的平均平方差估计值。

相关内容

专知会员服务

77+阅读 · 2020年2月8日

专知会员服务

36+阅读 · 2019年10月17日

Arxiv

5+阅读 · 2020年4月2日

Arxiv

9+阅读 · 2018年4月22日

Arxiv

4+阅读 · 2018年2月19日