EMNLP 2025(The 2025 Conference on Empirical Methods in Natural Language Processing)于北京时间2025年8月21日公布了论文录用结果。****EMNLP是计算语言学和自然语言处理领域的顶级国际会议,每年举办一次,被列入中国人工智能学会A类推荐国际学术会议、中国计算机学会B类推荐国际学术会议。EMNLP 2025于2025年11月5日至9日在中国苏州召开。

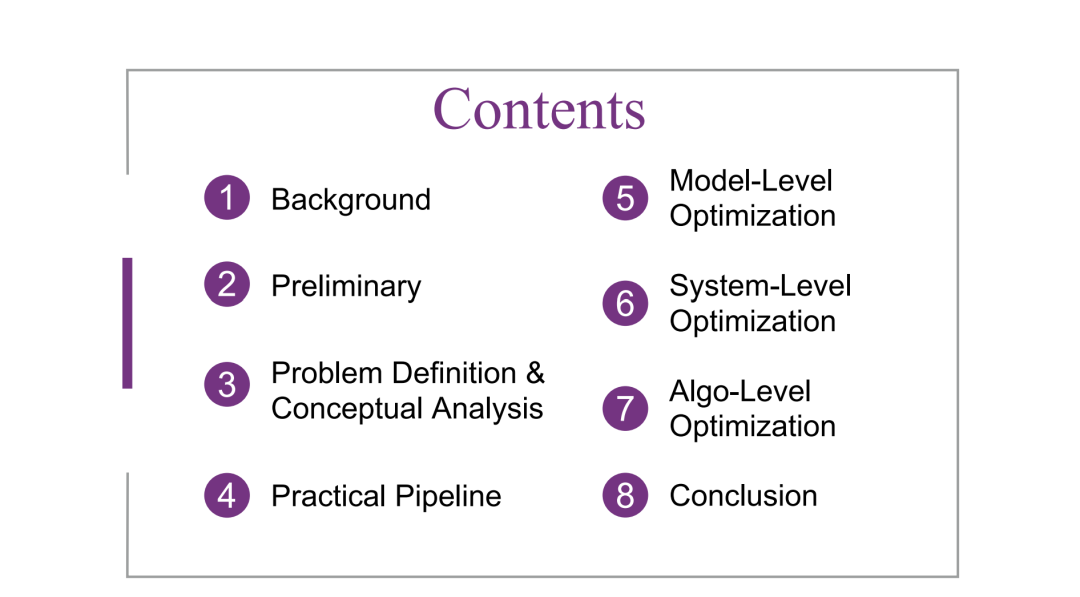

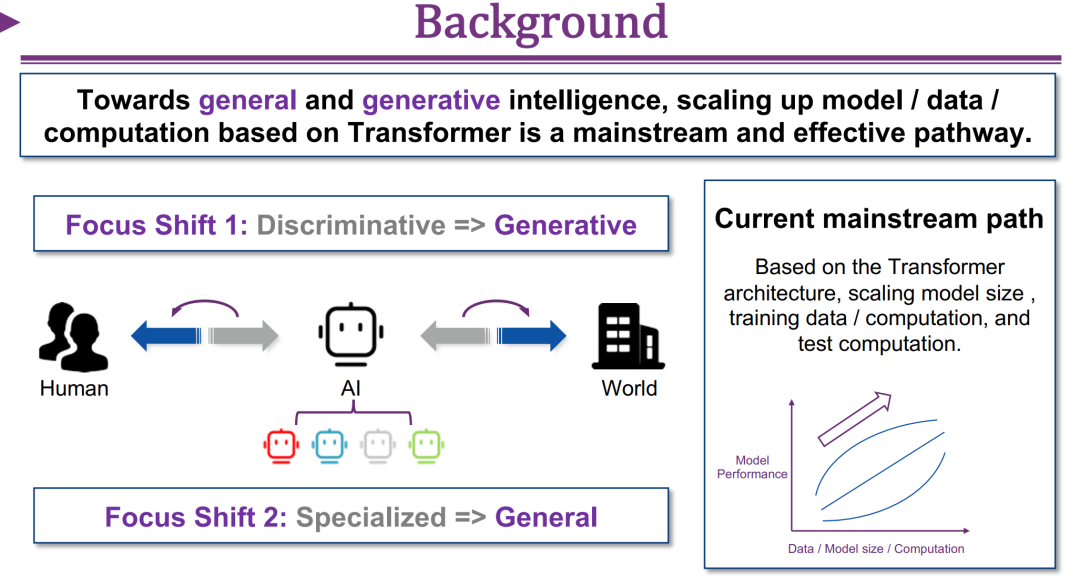

本教程聚焦于大语言模型(LLM)高效推理(Efficient Inference)这一日益重要的主题,旨在从设计者的视角出发,系统性地阐释其关键原理与方法论。我们首先介绍现代大语言模型的基本概念与核心机制,以及相关的软件与硬件背景。随后,将对效率优化问题(efficiency optimization problem)进行形式化定义。为帮助听众建立“系统设计者思维(designer’s mindset)”,我们将讲解如何针对特定硬件上的具体工作负载,诊断模型推理的效率瓶颈。特别地,我们将演示如何利用理论屋顶线模型(roofline model)以及 NVIDIA 工具链(toolchain)来识别这些瓶颈。 在掌握这些分析工具之后,我们将从概念层面解析导致推理效率低下的关键因素,包括:自回归采样机制(autoregressive sampling scheme)、模型规模(model size)以及核心注意力算子(core attention operator)。接着,我们将介绍一个面向大语言模型高效推理的全栈分类体系(full-stack taxonomy),将相关方法划分为算法级(algorithm-level)、**模型级(model-level)与系统级(system-level)**三大类: 1. 算法级优化:涵盖高效解码方法(efficient decoding methods)、输入压缩方法(input compression methods),以及超越自回归生成范式的替代生成机制(alternative generative paradigms beyond autoregression); 1. 模型级优化:通过高效模型结构设计(efficient architecture design),或静态/动态地减少模型层级冗余(redundancy reduction),以提升推理效率; 1. 系统级优化:在不改变模型计算图(computation graph)的前提下,优化推理引擎或部署系统(inference engine / serving system),以提升整体性能。

我们将依次讲解各类别的代表性方法,每个子类别选择一至三个典型方案作为实例,深入剖析其设计逻辑以及所针对的主要低效因素。最后,教程将以若干实机演示、核心要点总结以及未来研究方向展望作为收尾,为听众提供全面的理解与启发。 https://haolibai.github.io/emnlp-2025-tutorial-efficiency/