对人类动作进行建模是计算机视觉与机器人学中的一个基础课题。人类与三维物理世界以复杂的方式交互,既涉及位置的变化(全局动作),也包括身体的形变与关节活动(局部动作)。本论文探讨了人与他人、环境以及可操控物体之间的交互过程中的人体动作问题,重点关注人体动作的估计与生成,并强调整合多样化的知识源,如视频、动作捕捉数据和物理仿真。

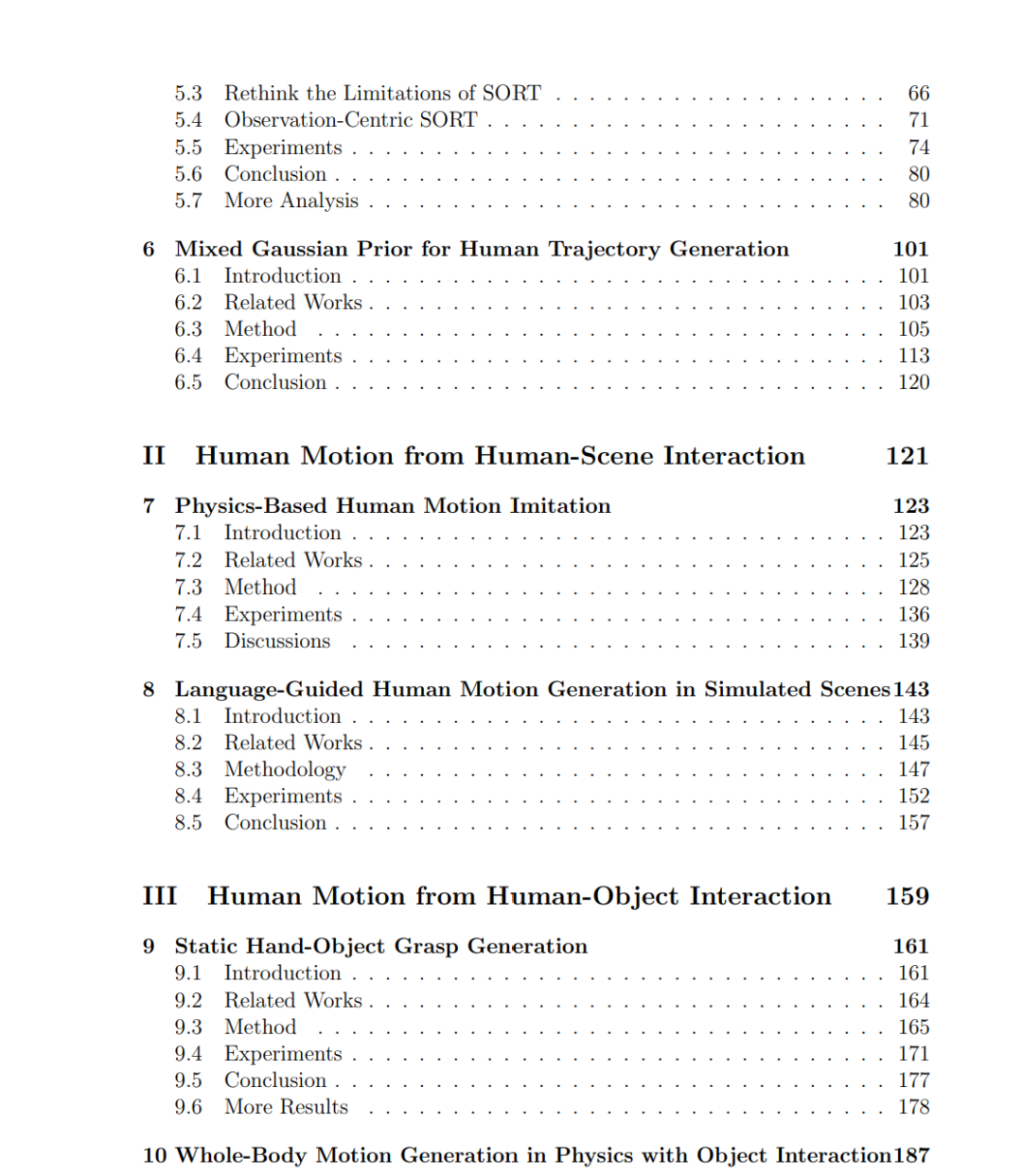

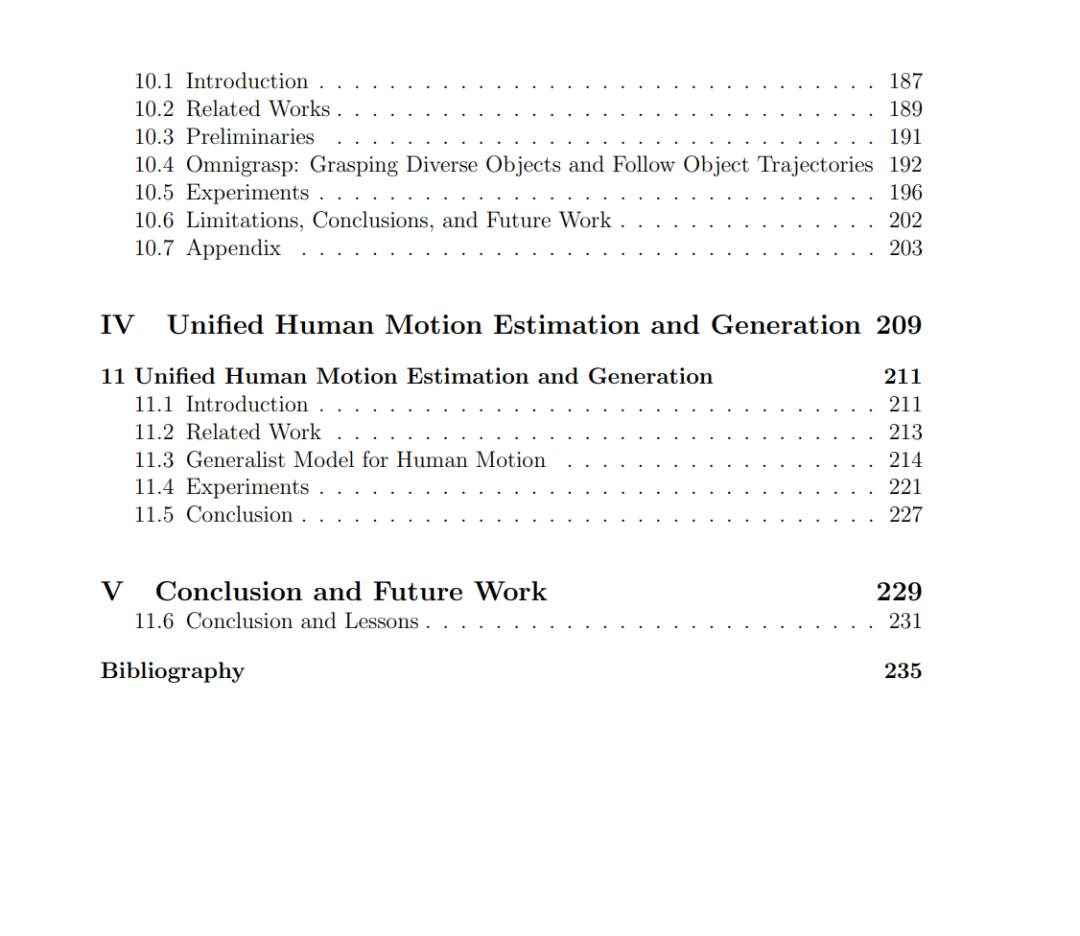

我们首先研究人-人交互。借助广泛可得的视频数据,我们关注个体在朝向目标移动的同时避免碰撞的隐式交互。最初,我们处理多目标跟踪任务,随后扩展至轨迹生成,从估计与生成两个视角进行探讨。在跟踪方面,我们从基于学习的方法入手,并重新审视经典的参数化滤波方法。为了生成具有社会感知的轨迹,我们将参数化先验与生成模型结合,从数据中引入归纳偏置。

论文的第二部分研究人-场景交互。由于人们在日常任务中常常弯曲或活动身体,我们考察了局部与全局的身体动作。我们利用动作捕捉数据来保证动作生成的视觉真实感,并采用物理仿真来确保物理真实感。首先,我们验证了基于物理的模仿器在多样动作上的适用性。随后,我们将一个人类智能体置于静态场景中,并开发强化学习策略,使其能够在语言指令的引导下生成具备物理约束的交互。

在第三部分中,我们将研究扩展至人-物体交互,即动态环境中的物体操控。由于人-物体动作捕捉数据有限,我们重点生成静态的手-物体抓取姿态,使其能够泛化到大规模物体形状数据集中的多样物体。这些抓取结果进一步用于引导强化学习策略,从而在仿真中实现携物体的全身动作生成。

基于前几章的研究成果,我们观察到生成模型在动作估计与生成两方面均展现出了有效性与灵活性。这启发我们探索一个统一模型。我们提出了一种人体动作扩散模型(diffusion model),其中通过对去噪过程进行条件化,模型不仅能够进行动作生成,还可以执行动作估计。当以视频作为条件时,该模型在动作估计上的性能已可与专门的估计模型相媲美。