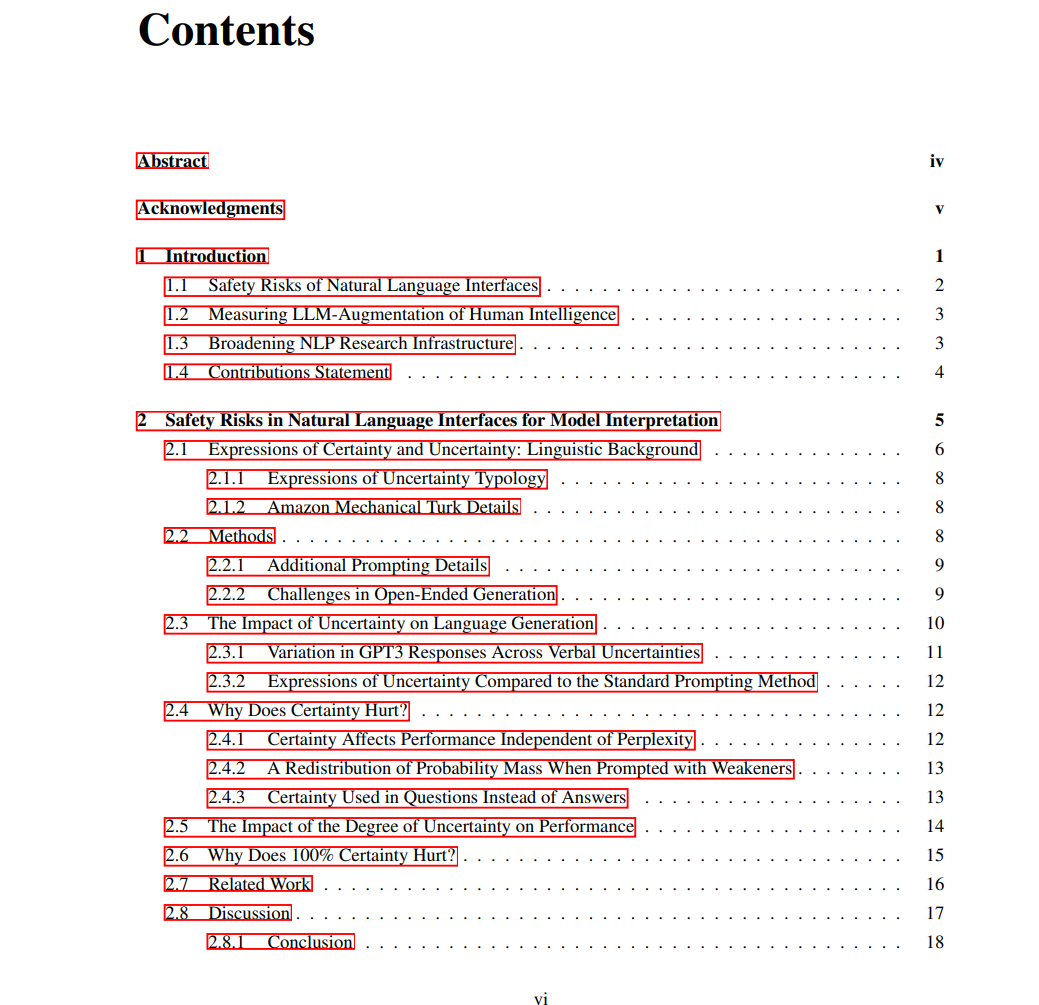

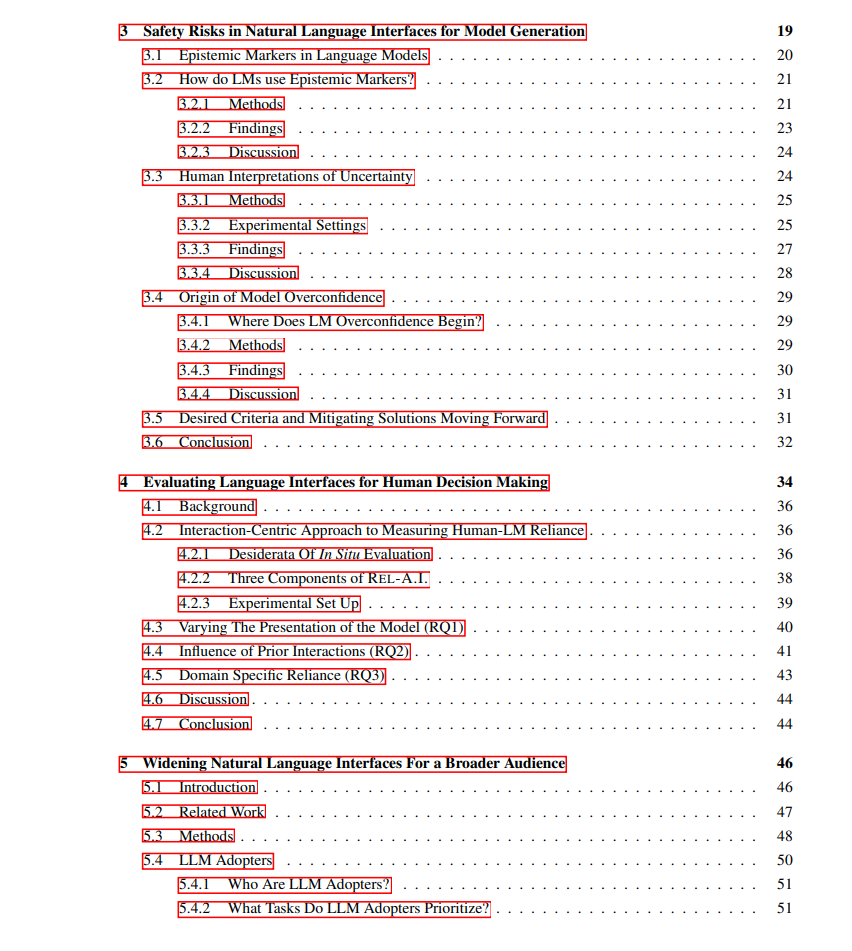

随着自然语言逐渐成为人机交互的默认界面,我们亟需思考:应如何设计大语言模型(LLMs),以安全地支持多样化的人类任务。在本篇论文中,我从自然语言界面的视角出发,提出三项研究工作,以推动我们对 LLMs 设计与理解的深入。这一过程不仅是技术挑战,更涉及对**人为因素(human factors)**的全面考量。

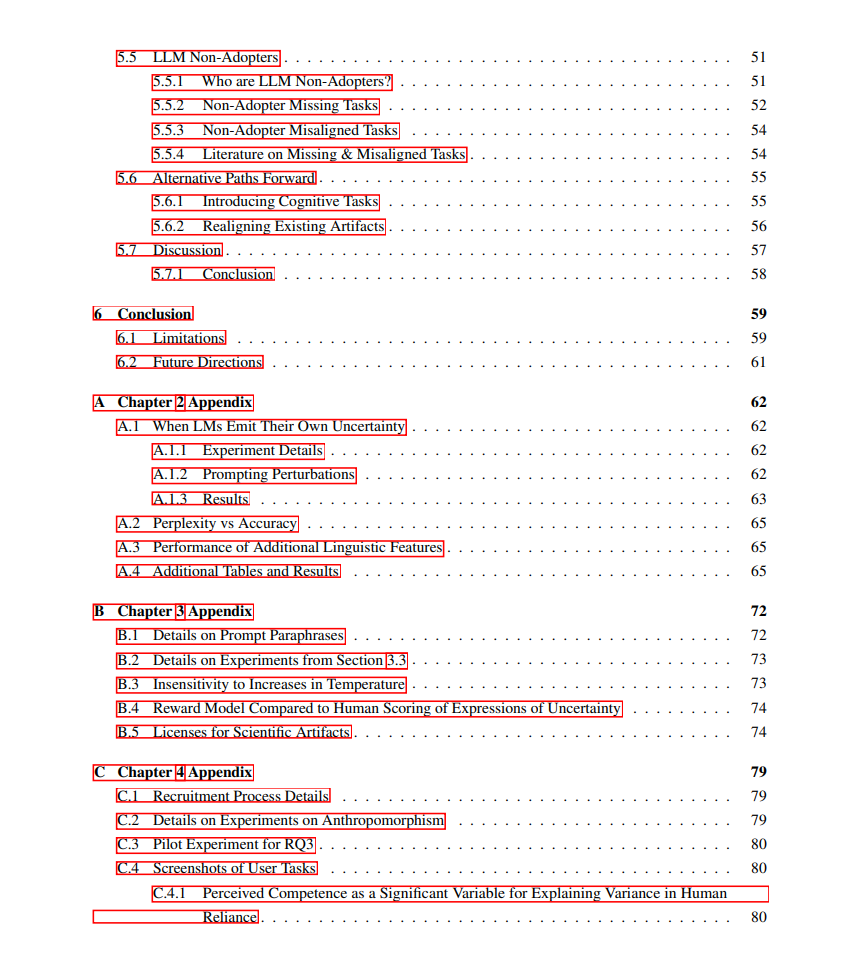

首先,我探讨了 LLMs 在传达风险与自身局限性方面所面临的关键安全隐患。研究发现,LLMs 在“理解”与“生成”关于确定性(certainty)的表达方面均存在困难。 其次,我提出了一个新的评估框架,用于识别人类与语言模型交互中可能产生的伤害,强调应将评估重点放在生成语言所触发的行为上,而非语言本身的质量。 最后,我探索了自然语言处理(NLP)研究如何更好地支持更广泛用户群体的需求,主张在研究议程中引入此前被忽视的任务与需求。 综上所述,我的工作识别了新的安全风险、提出了相应的缓解方案、构建了新的评估框架,并拓展了我们对 LLMs 如何安全地服务更广泛用户群体的理解。

成为VIP会员查看完整内容

相关内容

斯坦福大学(StanfordUniversity)位于加利福尼亚州,临近旧金山,占地35平方公里,是美国面积第二大的大学。它被公认为世界上最杰出的大学之一,相比美国东部的常春藤盟校,特别是哈佛大学、耶鲁大学,斯坦福大学虽然历史较短,但无论是学术水准还是其他方面都能与常春藤名校相抗衡。斯坦福大学企业管理研究所和法学院在美国是数一数二的,美国最高法院的9个大法官,有6个是从斯坦福大学的法学院毕业的。

Arxiv

79+阅读 · 2023年4月4日

Arxiv

144+阅读 · 2023年3月29日

Arxiv

83+阅读 · 2023年3月21日