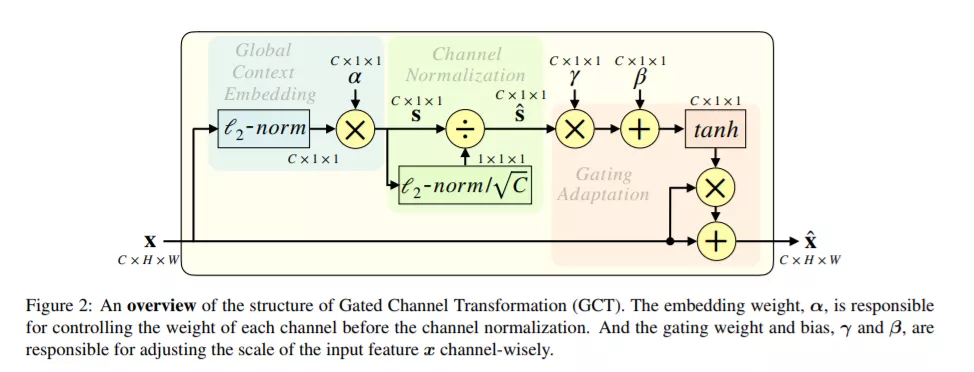

本文针对深度卷积神经网络提出了一种常规的、易应用的变换单元,即Gated Channel Transformation (GCT) 模块。GCT结合了归一化方法和注意力机制,并使用轻量级的、易于分析的变量来隐式地学习网络通道间的相互关系。这些通道量级的变量可以直接影响神经元间的竞争或者合作行为,且能方便地与卷积网络本身的权重参数一同参与训练。通过引入归一化方法,GCT模块要远比SE-Nets的SE模块轻量,这使得将GCT部署在每个卷积层上而不让网络变得过于臃肿成为了可能。本文在多个大型数据集上针对数种基础视觉任务进行了充分的实验,即ImageNet数据集上的图片分类,COCO上的目标检测与实例分割,还有Kinetics上的视频分类。在这些视觉任务上,引入GCT模块均能带来明显的性能提升。这些大量的实验充分证明了GCT模块的有效性。

成为VIP会员查看完整内容