图学习模型在从大规模图数据中学习表达性表示方面展现了强大的能力,并在各种真实世界的应用场景中取得了显著成效。作为一种训练强大图学习模型的常见策略,"预训练、适应"方案首先以自监督方式在未标注的图数据上预训练图学习模型,然后将其适应于特定的下游任务。在适应阶段,图提示作为一种有前景的方法应运而生,它在保持预训练图学习模型不变的情况下,学习可训练的提示。在本文中,我们对图提示的最新进展进行了系统综述。首先,我们介绍了作为图提示基础步骤的代表性图预训练方法。接下来,我们回顾了图提示中的主流技术,并详细阐述了它们如何为图提示设计可学习的提示。进一步地,我们总结了图提示在不同领域的实际应用。最后,我们讨论了现有研究中的若干开放性挑战,并展望了该领域未来的有前景的研究方向。

1 引言

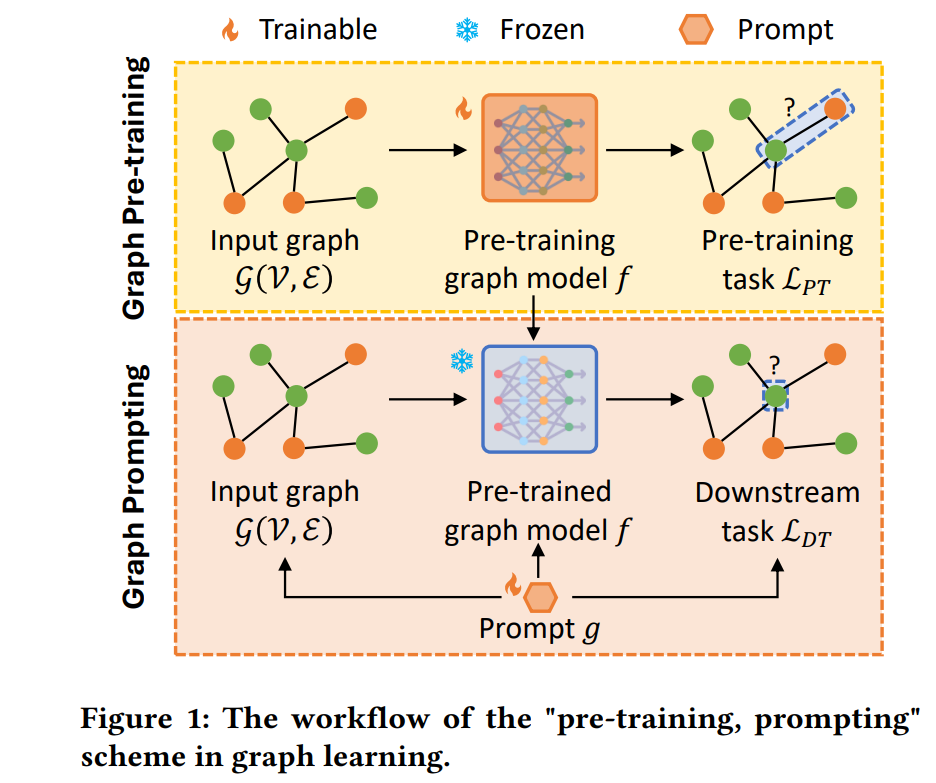

图在许多真实世界场景中非常常见,例如生物信息学[111]、交通网络[75]和医疗保健系统[11]。为了从海量的图数据中获得深刻的洞察,近年来开发了许多图学习模型,如图神经网络(GNNs)[19, 47, 80, 94, 103]和图变换器(Graph Transformers)[29, 77, 127],这些模型在不同的图相关下游任务中展现出了强大的能力,包括节点分类[62, 135]、链接预测[34, 141]和图分类[54, 149]。传统上,图学习模型是通过监督学习进行训练的。然而,监督学习方式严重依赖足够的标注图数据,而在实际应用中,标注数据可能并不可得。此外,即使在相同的图数据上,训练出的图学习模型也可能无法很好地泛化到其他下游任务。这两个关键限制因素阻碍了图学习模型在实际中的进一步应用。 为了克服上述限制,近年来许多研究致力于设计有效的预训练框架,用于在不依赖下游任务标注信息的情况下训练强大的图学习模型[23, 24, 30, 95, 106, 107, 109, 118]。图预训练的理念是通过自监督学习,先预训练图学习模型,学习到图数据的表达性图表示。通常,这些图表示能够嵌入图数据中的可迁移知识,并且可以用于下游任务。然而,预训练和下游任务之间存在不可避免的目标差距。例如,一个图学习模型可以通过链接预测进行预训练,之后将其适应于节点分类作为下游任务。在此示例中,预训练时我们更关注节点对之间的关系,用于链接预测,而作为下游任务的节点分类则更关注每个单独节点的表示。因此,预训练图学习模型学到的图表示可能会对下游任务产生不利影响。 为了弥合目标差距,“预训练、提示”方案已被许多图学习研究广泛采用[9, 12, 59, 84, 86, 124]。受到自然语言处理[44, 138]和计算机视觉[35, 116]中最近提示调优方法的启发,图提示通过学习额外的提示向量来适应预训练的图学习模型,同时保持预训练的图学习模型冻结。图1展示了“预训练、提示”方案的工作流程。与微调[31, 136]相比,图提示仅需更新更少的参数,使其更适合少样本设置。此外,图提示更具灵活性,因为可学习的图提示可以在不同层级为下游任务设计。这些优势使图提示成为图学习领域一个有前景的话题,鼓励学术界和工业界的研究人员和从业者进一步探索其技术。 在本综述中,我们提供了关于图提示现有文献的全面且最新的介绍。具体来说,首先我们介绍了作为图提示基础阶段的代表性图预训练方法。接下来,我们对现有的图提示技术进行了有条理的总结。与之前的综述论文[61, 87]相比,我们提出了一种从图数据、节点表示和下游任务三个角度出发的图提示方法的新分类法。我们进一步展示了图提示技术在各种实际领域中的重要应用。最后,我们讨论了现有研究中的挑战和未解之谜,旨在鼓励该领域的进一步发展。我们总结了本综述的主要贡献如下:

新分类法:本综述提供了一个新颖的现有图预训练和图提示方法的分类法,如图2所示。

最新技术:与之前的图提示综述论文相比,本综述包含并介绍了更为近期的图提示技术。

新方向:基于现有技术,我们从不同角度提供了图提示未来发展的见解。