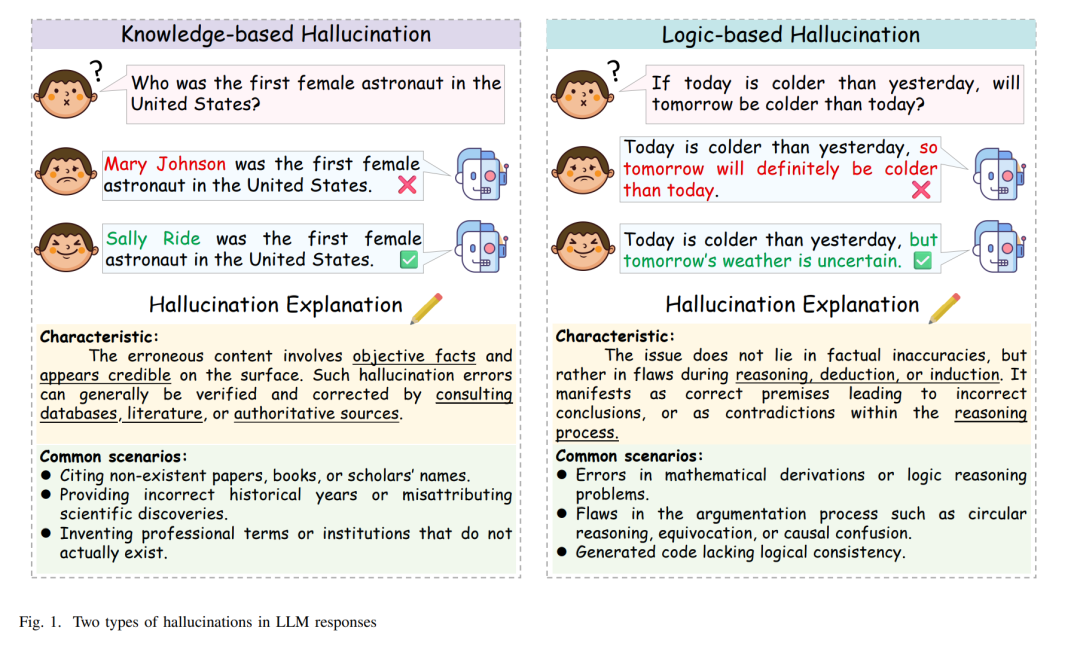

摘要—— 幻觉(Hallucination)仍然是阻碍大语言模型(Large Language Models, LLMs)在真实场景中可靠部署的关键障碍之一。在众多缓解策略中,检索增强生成(Retrieval-Augmented Generation, RAG) 与 推理增强(Reasoning Enhancement) 已成为当前最有效、应用最广的两大方向,标志着研究范式从单纯抑制幻觉转向在创造性与可靠性之间寻求平衡。然而,二者在幻觉缓解中的协同潜力与内在机制尚缺乏系统性探讨。 本综述从面向应用的能力增强视角出发,系统分析了 RAG、推理增强及其在智能体系统(Agentic Systems)中的融合如何共同缓解幻觉。我们提出了一个区分基于知识(knowledge-based)与基于逻辑(logic-based)幻觉的分类体系,系统考察了 RAG 与推理方法分别如何应对这两类幻觉,并进一步提出一个统一框架,结合实际应用、评测与基准数据进行支撑。 关键词—— 幻觉;大语言模型(LLM);检索增强生成(RAG);推理(Reasoning);思维链(Chain-of-Thought, CoT);智能体(Agents)

一、引言(Introduction)

将幻觉(Hallucination)定义为:生成的内容看似合理,但与真实世界事实或用户指令不一致的现象 [1], [2], [3]。它已成为大语言模型(Large Language Models, LLMs)部署中的关键挑战之一 [4]。在医疗诊断、法律分析与科学研究等高风险应用中,即便是轻微的事实或逻辑错误也可能导致严重后果 [5],包括虚假信息的传播以及公众对 AI 系统信任的侵蚀 [4]。现有研究表明,幻觉在各尺度模型中仍然普遍存在 [6]——从万亿参数级系统(如 ChatGPT-4 [7]、DeepSeek-R1 [8])到较小模型(如 LLaMA 7B [9]、Mistral [10])——这凸显了应对该问题的紧迫性与必要性。近年来,随着 LLM 的广泛落地,一个实际困境日益凸显:如何在抑制幻觉的同时保留生成能力与创造性,已成为性能优化与真实世界采纳的核心挑战 [11]。 现有的幻觉缓解方法 [1], [2] 覆盖 LLM 生命周期的多个阶段:包括预训练阶段的数据处理与对齐策略 [12],微调 [13] 以及基于人类反馈与偏好的强化学习方法;以及推理阶段的干预技术 [14],如检索增强生成(Retrieval-Augmented Generation, RAG) [15] 与思维链(Chain-of-Thought, CoT)推理 [16]。近期,RAG 与基于推理的方法 [17] 在学界与产业界均受到高度关注。RAG 通过引入外部知识源扩展模型的知识边界 [15],使模型在推理时能够获取最新、准确且特定领域的信息,从而减少因知识缺失或过时导致的事实性错误 [1]。推理技术 [17] 则侧重提升模型在多步任务、复杂逻辑推演与问题分解方面的能力,帮助避免由断裂或不一致的推理链引发的基于逻辑的幻觉。相较于其他缓解方法,这两类途径在保留开放域生成能力的同时抑制幻觉。此外,它们已作为核心模块集成进若干商用 LLM(如 Grok-4 [18]、ChatGPT-4 [7]、Gemini [19]),体现出适用性、可扩展性与可移植性。 多数现有综述 [2], [1], [3] 聚焦于幻觉的成因、分类与基于生命周期的缓解阶段,或分别从数据、模型、解码层面分析孤立策略。尽管覆盖面广,但较少从增强系统能力的角度探讨幻觉缓解——尤其是提升模型的知识获取、推理与规划能力如何降低幻觉发生率。 为弥补这一空白,本文调研三类具有代表性的面向能力的缓解范式:RAG、推理增强与智能体系统(Agentic Systems)。这些方法的共同原则是:不直接修改模型架构或施加额外正则,而是通过可验证的知识锚定与逻辑一致性约束(借助外部知识源、显式推理链与动态规划机制)来增强 LLM 的可靠性。这一视角将关注点从错误消除转向能力提升,与提高模型可靠性与可解释性的长期趋势相一致 [11]。本文采用面向能力的分析框架,系统梳理 RAG、推理增强与智能体系统的最新进展,并建立一套统一的幻觉缓解评估视角。 为更好刻画不同类型幻觉及其对应的缓解机制,本文在 RAG 与基于推理方法的实际应用背景下,提出以缓解为导向的分类法:基于知识(knowledge-based)的幻觉与基于逻辑(logic-based)的幻觉(见图 1)。 我们的贡献。 以幻觉缓解为中心目标、以能力增强为分析准绳: * 系统回顾代表性 RAG 流水线,并分析两类范式——精确检索(Precise Retrieval)与广域检索(Broad Retrieval)——如何在不同应用场景中缓解基于知识的幻觉。 * 首次从幻觉导向视角对三类推理增强方法进行对比:思维链(CoT) [64], [16]、工具增强推理(Tool-Augmented Reasoning) [42], [41] 与符号推理(Symbolic Reasoning) [40], [39],并考察其缓解基于逻辑的幻觉之机理与效果。 * 系统定义与概念化“智能体系统(Agentic System)”——这一融合 RAG 与推理的新兴范式——并将其定位为应对复合型幻觉问题的统一框架与标准路径。 * 针对每类幻觉缓解策略,提供代表性领域的应用案例,展示其现实价值与可泛化性。

论文的主要内容与结构如图 2 所示。通过结构化分析与全面综述,本文旨在为在真实应用中有效抑制幻觉的 LLM 开发提供统一的参考框架与方法论指引。 综述组织方式。 本文结构如下:第 II 节回顾并比较相关综述;第 III 节给出本文的背景与关键概念;第 IV–V 节分别讨论 RAG 与推理增强在缓解基于知识与基于逻辑幻觉中的机理与应用;第 VI 节进一步分析二者的融合并讨论新兴的智能体系统范式;第 VII 节按幻觉类型总结现有评测基准;第 VIII 节给出挑战与未来方向。