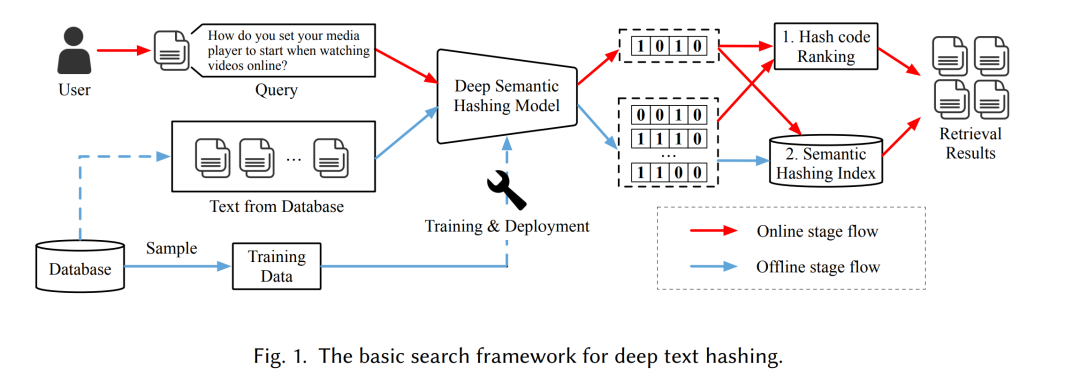

随着互联网上文本内容的迅速增长,高效的大规模语义文本检索受到了学术界与工业界的广泛关注。文本哈希(Text Hashing)通过将原始文本映射为紧凑的二进制哈希码,是实现这一任务的关键方法。利用二进制编码,可以通过快速的汉明距离(Hamming Distance)计算显著加速文本对之间的语义相似度计算,同时大幅降低存储成本。 随着深度学习的发展,深度文本哈希(Deep Text Hashing) 相较于传统的、数据无关的哈希技术展现出了显著优势。借助深度神经网络,这些方法能够直接从数据中学习紧凑且语义丰富的二进制表示,从而突破早期方法在性能上的限制。 本综述系统地研究了当前的深度文本哈希方法,并根据其核心组成部分进行分类,包括:语义特征提取、哈希码质量保持以及其他关键技术。随后,我们提出了一个详细的评估框架,并在多个常用数据集上报告了实验结果;同时还讨论了深度文本哈希的实际应用场景及其开源实现工具。最后,本文总结了该领域面临的关键挑战与未来研究方向,尤其是深度文本哈希与大语言模型(Large Language Models, LLMs)相结合以进一步推动语义检索性能提升的前景。 本综述的相关项目可访问:https://github.com/hly1998/DeepTextHashing。 1 引言

互联网上的内容正在以指数级速度增长。据估计,每年都会从网页、社交媒体、科学文献以及企业知识库等多种平台上产生 泽字节(zettabytes)级别的新文本数据 [82]。如何从这股海量数据洪流中高效检索出相关信息,是至关重要的任务。它支撑着诸如搜索引擎 [20, 168]、问答系统 [61, 97, 133, 165] 以及数字图书馆 [73, 87] 等关键应用。然而,传统的关键词检索方法往往无法捕捉文本中细微而复杂的语义差异。因此,语义文本检索(Semantic Text Retrieval) ——一种关注理解文本潜在意图与语义关系的检索范式——变得愈发重要 [39, 160]。 要同时满足语义理解与大规模检索效率这两方面的需求,研究者通常将两种核心技术结合使用: (1)表示学习(Representation Learning) [8, 31, 163],用于将语义信息编码为向量表示 [66, 92]; (2)近似最近邻搜索(Approximate Nearest Neighbor, ANN) [1, 74, 103],用于实现快速检索。 在 ANN 技术体系中,哈希技术(Hashing Techniques) [28, 36, 88, 108] 占据着重要地位。由于其在计算速度与存储效率上的显著优势,哈希方法尤为适合处理大规模数据集。 在文本数据哈希的早期代表性方法中,局部敏感哈希(Locality Sensitive Hashing, LSH) [12, 24, 63] 是最具影响力的技术之一。LSH 的核心思想是将原始数据映射到多个哈希桶中,使得原始空间中距离较近的对象更可能落入同一个哈希桶。然而,LSH 属于数据无关(data-independent)方法,这导致在处理复杂文本数据时,由于信息丢失,其召回性能显著下降。为了解决这一问题,研究者提出了数据相关(data-dependent)的“学习哈希(Learning-to-Hash)”方法 [62, 80, 81, 108, 125, 126, 129, 134, 152],旨在保持原始数据特征的结构相似性。这些方法受到谱聚类(Spectral Clustering) [96]、潜在语义索引(Latent Semantic Indexing, LSI) [25] 等技术的启发。 随着深度学习在多个领域取得巨大成功 [18, 67, 169],研究者开始考虑利用深度模型作为哈希函数,以获得更精确的数据表示。在此过程中,不同类型的数据促成了多种深度哈希分支的发展,例如: * 深度图像哈希(Deep Image Hashing),用于图像检索 [32, 49, 50, 127, 151]; * 深度文本哈希(Deep Text Hashing),用于文本检索 [10, 44, 45, 110, 147]; * 深度跨模态哈希(Deep Cross-modal Hashing),用于图文检索 [85, 115, 131, 145, 153]; * 深度多模态哈希(Deep Multi-modal Hashing),用于多模态检索 [83, 114, 161, 166] 等。

其中,深度文本哈希 由于文本数据的独特特征而面临特殊挑战。总体而言,图像数据的类别语义通常更易提取,而文本语义的捕获则更加困难,需要构建更加复杂的表示空间。然而,有限的汉明空间容量又进一步增加了将文本语义表示于其中的难度。尽管深度跨模态哈希与多模态哈希方法也涉及文本数据,但文本在这些任务中往往只是图像的简单补充或描述;相比之下,深度文本哈希所面对的文本内容通常更加复杂和抽象。 本综述聚焦于深度文本哈希(Deep Text Hashing),一方面是因为该任务的挑战性较高,另一方面则是由于目前缺乏全面的综述研究。以往的哈希综述多聚焦于通用学习哈希(General Learning-to-Hash) [19, 124, 126]、图像哈希 [84, 107] 或 跨模态哈希 [167],而专门针对深度文本哈希的系统性总结尚属首次。 此外,本研究的一项关键创新在于提出了一种基于组件(Component-based) 的新型分类框架。该框架突破了传统的“有监督/无监督”划分方式,从模型内部机制出发,围绕三大核心模块进行分析: 1. 语义提取(Semantic Extraction) ——模型如何从文本中捕捉语义信息,包括重建式学习、伪相似性构造、类别或相关性监督等策略; 1. 哈希码质量保持(Hash Code Quality Preservation) ——关注二进制输出的性质,如哈希码的紧凑性、分布均衡性及量化误差; 1. 其他增强技术(Other Technologies) ——涉及鲁棒性优化、索引适配、梯度传播改进等辅助机制。

我们认为,这一新的分类方式具有显著优势。通过聚焦底层机制而非监督方式,它能提供更深入的技术洞察,更贴合任务的核心挑战,并为未来研究提供模块化的设计框架。此外,本综述不仅关注哈希模型本身,也涵盖整个检索流程及其实际应用方法。 本文结构安排如下: 我们首先在第2节给出本文使用的符号与定义,并介绍深度文本哈希的背景知识; 第3至第5节分别从不同角度详细介绍代表性的深度文本哈希方法; 第6节介绍评估框架、数据集及性能结果; 第7节讨论深度文本哈希的应用场景与开源工具支持; 最后在第8节总结全文并展望未来研究方向。