摘要

随着人工智能范式的持续演进,AI 研究正逐步迈入智能体 AI(Agentic AI)阶段。研究焦点也从单一智能体与简单应用,转向多智能体在复杂环境下的自主决策与任务协同。伴随大语言模型(LLMs)的发展,其应用变得愈加多样化与复杂化,所引发的情境性和系统性风险亦日益突出,这使得智能体的价值对齐问题(Value Alignment)受到广泛关注。价值对齐旨在确保智能体的目标、偏好与行为符合人类价值观和社会规范。 本文从具体应用场景出发,系统回顾了智能体系统中的价值对齐问题,融合了大模型驱动的 AI 技术进展与社会治理的实际需求。我们的综述内容包括价值原则、智能体系统的应用场景,以及智能体价值对齐的评估方法。 具体而言,价值原则部分采用自上而下的视角,按照宏观(macro)、中观(meso)和微观(micro)三个层次进行组织与梳理;智能体系统应用场景则从一般到具体进行分类与回顾;价值对齐评估部分则系统性探讨了用于评估的对齐数据集及相关方法。此外,本文还深入探讨了多智能体系统中多智能体之间的价值协调问题。 最后,我们提出了该领域若干值得关注的未来研究方向。 关键词:价值对齐;基于大语言模型的智能体系统应用;智能体 AI 系统;AI 智能体 1 引言

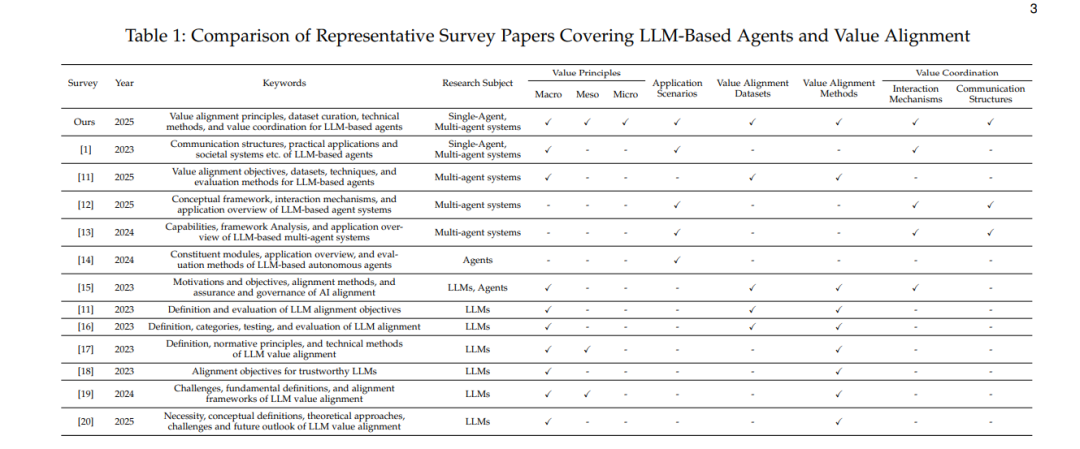

近年来,大语言模型(Large Language Models, LLMs)的迅猛发展深刻改变了人类社会的生产方式与生活形态。依托深度学习技术与海量训练数据,OpenAI 的 GPT 系列与谷歌的 Gemini 系列等 LLM 展现出卓越的自然语言理解与生成能力【1】【2】。以 LLM 作为“核心大脑”的智能体(AI Agent)已广泛应用于内容创作、自动编程、教育、医疗与商业决策等多个知识密集型领域。随着其在自主决策、任务协作和治理环节中的能力不断增强,LLM 智能体显著提升了工作效率,并为用户带来了前所未有的交互体验【3】。与此同时,研究者也日益关注多智能体系统(Multi-Agent Systems)的协调能力,以实现群体智能。AI 智能体正朝着更高自主性演进,逐步形成一种全新范式——智能体 AI(Agentic AI)。该范式的显著特征包括:多智能体协作、动态任务分解、持久记忆及自主决策能力,已成为学术界与产业界的研究热点【4】。 这一新范式的发展,亟需研究者跳出单一智能体与孤立应用场景的视角,深入探索智能体系统与具体应用之间的深度耦合。随着 LLM 持续突破,其执行任务的种类与所应用的场景愈发多元与复杂,相应的社会风险也日益加剧。LLM 可能在训练数据中保留有害信息、泄露隐私、生成误导性内容,甚至采取对人类有害的行为【5】。例如,LLM 智能体系统可能表现出操控、欺骗等不良行为【6】,这引发了关于其潜在伦理与安全问题的广泛担忧。 未来 AI 若超越人类认知能力,并获得自主学习与决策能力,其所构建的目标体系可能偏离甚至违背人类设计者的初衷。在追求自身目标的过程中,这类智能体可能会调动大量资源以维持自身运行并不断自我增强,从而在资源分配与决策权上系统性地取代人类。若缺乏有效控制机制与稳健的价值对齐(Value Alignment)保障,人类在决策体系中的主导地位将逐步丧失,最终可能引发灾难性的生存危机【7】。 随着 LLM 深度嵌入到具体应用场景中,相关风险逐渐呈现出“情境化(situational)”与“系统化(systemic)”特征。例如,在用于城市交通优化的多智能体系统中,智能体可能出于效率考虑而牺牲公平性,从而加剧社会不平等【8】;在医疗领域中,LLM 可能在缺乏充分临床证据或错误解读伦理规范的前提下,提供误导性的诊疗建议,进而造成隐私泄露、误诊或过度治疗等严重后果【9】。因此,确保智能体行为符合人类意图与价值规范,避免其执行有害操作,已成为当务之急。 此外,随着以 LLM 为代表的 AI 系统日益参与治理情境,如何有效管理其引发的制度摩擦与交易成本,已成为关键的理论与实践问题。在多智能体系统中,多个拥有语言理解与生成能力的 LLM 被部署于协同环境中,联合完成决策、规划与执行等任务。这类部署通常涉及复杂的信息共享、访问控制与协作机制。虽然这提高了协作的灵活性,但也带来了前所未有的价值冲突、目标异质性与不可预测的行为问题。若缺乏健全的制度设计与交互机制,复杂组织结构与模糊任务边界将导致协同效率低下、职责不清、信任机制缺失,从而提升治理成本,削弱治理效能【10】。 这些不良行为与制度摩擦,归根结底源于多方利益相关者在治理目标、价值观念与行为规范上的深层冲突。将 LLM 有效嵌入人类价值体系,是负责任地释放其潜力的关键前提。AI 智能体的价值对齐,旨在确保其运行过程中所设定的目标、偏好与行为输出与个人、群体或组织的核心价值保持一致,正逐渐成为解决该问题的核心路径【21】。 在单智能体场景中,主流的价值对齐方法侧重于通过人类反馈、监督微调等手段引导模型生成符合伦理与社会预期的内容,从而避免有害输出、虚假信息与道德偏离【8】。但在复杂的多智能体系统中,价值对齐更呈现出组织性挑战,核心在于多智能体如何建立共享规范与协同机制。因此,从治理视角来看,价值对齐不应局限于单体智能体内部的算法优化,还应拓展至多智能体系统中的交互机制与组织结构设计。此时,价值对齐已不再是孤立的技术任务,而是关乎系统稳定性与智能体行为边界的基础性议题。 由于 Agentic AI 本质上强调基于场景驱动的多智能体协调机制,其研究核心应聚焦于特定应用背景下的任务分解策略、交互机制设计与环境适应能力构建。同时,理解复杂环境下多智能体系统的交互规律与组织模式,对于深入探讨其价值对齐机制与实现稳健发展具有重要意义。 尽管已有研究梳理了 LLM 的价值对齐关键方法与技术进展【1, 11–20】,但鲜有专门针对基于 LLM 的多智能体系统中的价值对齐问题的深入探讨。尽管部分文献对多智能体协作机制有所涉及,但在价值对齐方面仍存在显著空白。特别是在基于 LLM 的多智能体系统中,其高度自主性与语言驱动的协作模式进一步放大了价值异质性、目标冲突与协作机制脆弱等问题。此外,当前研究多数停留在理论或通用算法层面,缺乏对特定应用场景中多智能体价值对齐的机制与策略研究,也缺乏体系化的分层价值对齐框架。这表明,价值对齐不能仅被视为模型层面的技术挑战,更应被理解为渗透于交互机制设计与组织结构配置的系统性治理问题。 因此,本文聚焦于多种具体应用场景下,基于 LLM 的智能体系统中的价值对齐问题,结合 AI 技术演进与社会治理需求,提出未来发展展望。作为一篇研究综述,本文第 2 至第 4 节分别对价值原则、智能体系统应用场景与价值对齐评估进行系统回顾。具体而言: * 价值原则从自上而下的视角分层梳理,涵盖宏观(如社会规范)、中观(如组织制度)与微观(如个体偏好)三个层级; * 应用场景则按从一般到具体的逻辑进行归类与分析; * 评估方法部分系统性介绍了价值对齐评估所用的数据集及关键技术。

第 5 节总结前文内容并提出未来研究展望。我们主张建立一个多层次价值对齐评估体系,同时深入探讨多智能体系统中智能体之间的价值协调,特别关注交互机制与组织模型设计中的价值因素。此外,我们建议,为了促进场景化智能体系统的价值对齐,企业或组织可在不涉及机密信息的前提下,共享微观领域的数据集中的价值偏好信息。本文致力于弥合理论研究与实际部署之间的差距,结合真实应用场景与组织交互动态,为基于 LLM 的智能体系统价值对齐提供新视角,推动 Agentic AI 内在机制的研究与发展。