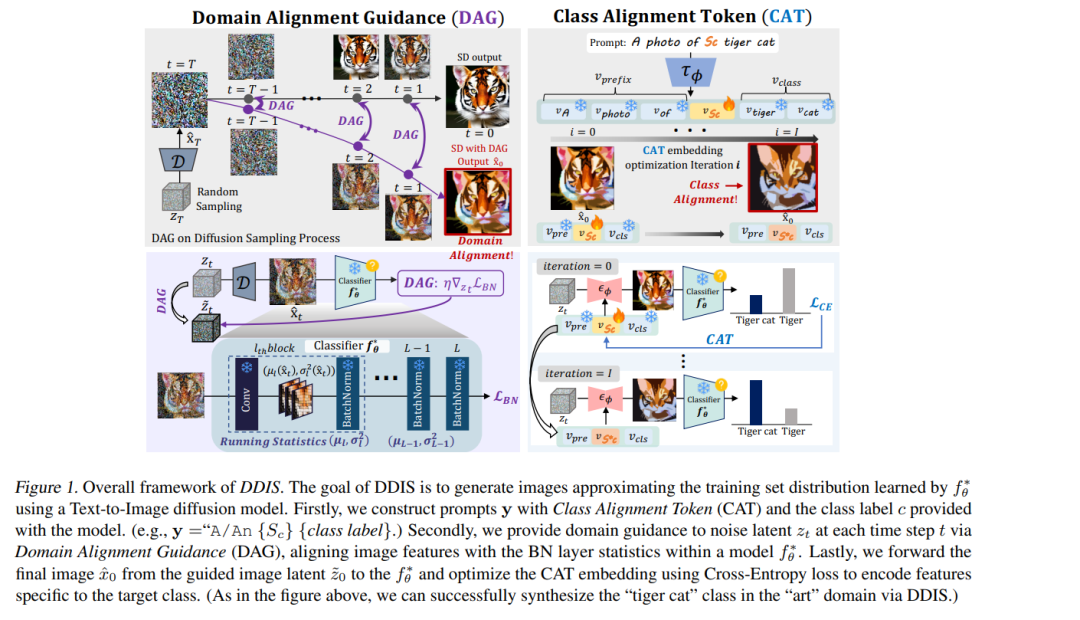

开源的预训练模型具有广泛的应用潜力,但当其训练数据不可获取时,模型效用会显著下降。无数据图像合成(Data-Free Image Synthesis,DFIS)旨在在不访问原始数据的前提下,生成逼近预训练模型所学习数据分布的图像。然而,现有 DFIS 方法因缺乏关于自然图像的先验,往往生成与真实训练数据分布偏离的样本。 为克服这一限制,我们提出 DDIS——首个扩散辅助的无数据图像合成方法。DDIS 利用文本-到-图像扩散模型作为强大的图像先验,显著提升合成图像质量。具体而言,DDIS 从给定模型中提取其学习到的数据分布知识,并用这些知识引导扩散模型,进而生成与训练数据分布高度对齐的图像。 为实现这一目标,我们提出: 1. 域对齐引导(Domain Alignment Guidance,DAG):在扩散采样过程中,使合成数据域与训练数据域保持一致。 1. 类别对齐标记(Class Alignment Token,CAT):通过优化单个 CAT 嵌入,有效捕捉训练数据集中各类别的特定属性。

在 PACS 与 ImageNet 数据集上的实验表明,DDIS 相较于现有 DFIS 方法能够生成更符合训练数据分布的样本,在无数据应用场景中取得了最新的 SOTA(State-of-the-Art)性能。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

211+阅读 · 2023年4月7日

Arxiv

20+阅读 · 2023年3月21日