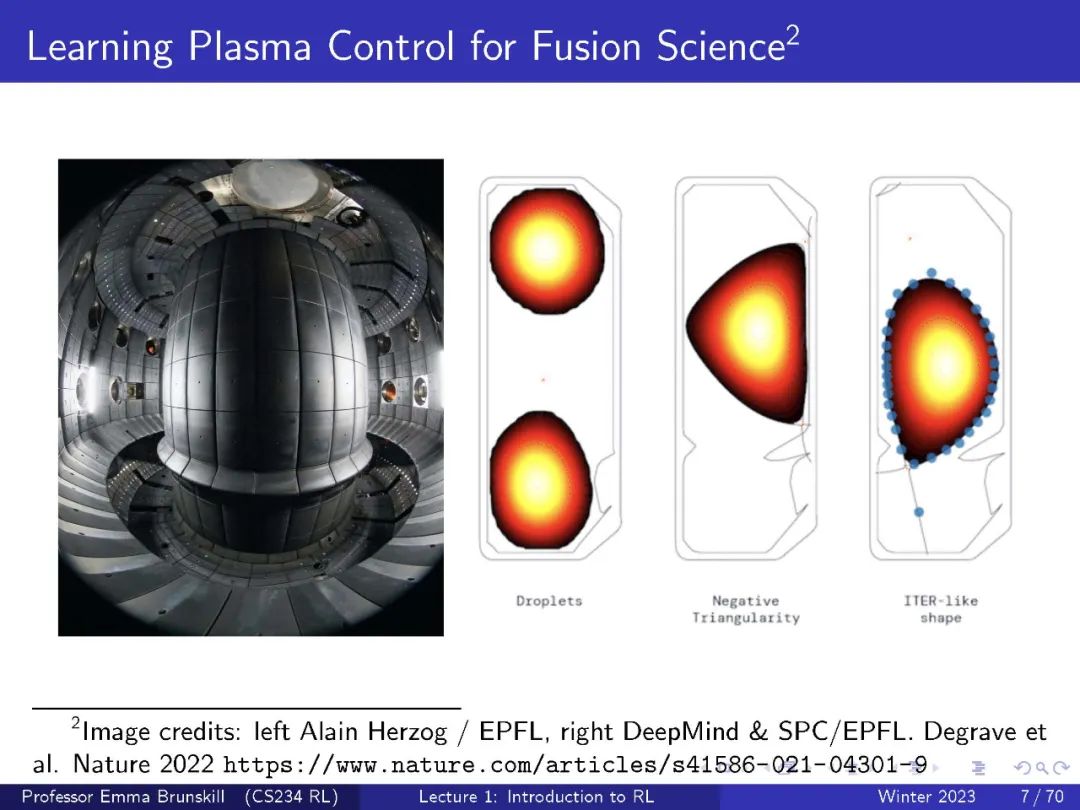

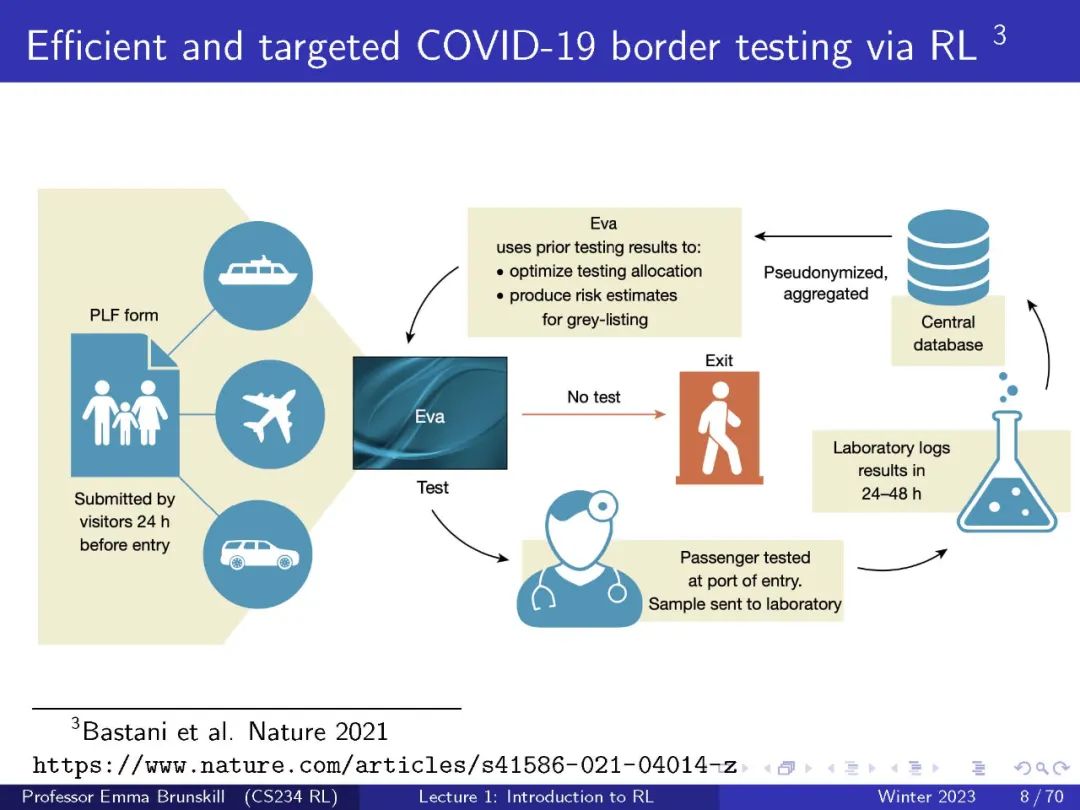

要实现人工智能的梦想,就需要学会做出正确决策的自主系统。**强化学习是这样做的一个强大范式,它与大量的任务相关,包括机器人、游戏、消费者建模和医疗保健。**本课程将提供强化学习领域的充实介绍,学生将学习强化学习的核心挑战和方法,包括推广和探索。通过讲课、书面作业和编码作业的结合,学生将学习RL的关键思想和技术。作业将包括强化学习的基础知识以及深度强化学习——一个结合了深度学习技术和强化学习的极具前景的新领域。

地址:

https://web.stanford.edu/class/cs234/

学生能够学习到:

定义强化学习与人工智能和非交互式机器学习的区别的关键特征。 * 给定一个应用问题(例如,计算机视觉,机器人等),决定它是否应该被表述为RL问题;如果是,可以正式定义它(根据状态空间,行动空间,动态和奖励模型),说明什么算法(从类)是最适合解决它,并证明你的答案。 * 在代码中实现通用的RL算法。 * 描述(列出和定义)分析RL算法的多种标准,并根据这些指标评估算法:例如遗憾度、样本复杂度、计算复杂度、经验性能、收敛性等。 * 描述探索与开发的挑战,并对至少两种解决这一挑战的方法进行比较和对比(从性能、可伸缩性、实现的复杂性和理论保证方面)。

内容目录:

Introduction to Reinforcement Learning * Tabular MDP planning * Tabular RL policy evaluation * Q-learning * RL with function approximation * Policy search * Exploration * Exploration / Exploitation * Batch Reinforcement Learning * Monte Carlo Tree Search