现代军事决策辅助工具必须在通常超出其开发者测试方案的对抗条件下保持可靠。本文提出一个在Atlatl六角格兵棋推演平台之上构建的可重复实验框架,该框架通过概率性想定生成、全局敏感性分析和局部对抗搜索来探究人工智能(AI)的脆弱性。为测试该框架,在一个小型想定中评估了三个参考智能体:NAMaiV5和NAMaiV9(脚本AI)以及Pascal(一个在该测试想定上训练过的神经网络)。拉丁超立方采样生成了20,000个不同的想定,每个想定通过蓝方对红方(Blue-vs-Red)和红方对红方(Red-vs-Red)比赛的得分差进行评估,并利用索博尔指数从中分离出有影响力的参数。随后,一种邻域搜索启发式程序将模型性能降低了高达65%,在效率上优于差分进化算法,同时实现了更好的得分差降低。行为热图揭示了一致的空间偏差,尤其是在扰动地图中心附近地形时。结果表明,脚本AI在力量失衡和对手变化情况下失败最多,而神经网络对想定时长和未见过的地形集群更为敏感。该测试平台为军事AI系统的对抗性验证提供了一个可扩展且可解释的过程和工具,为作战鲁棒性提供了可操作的见解。

背景与动机

机器学习算法在从娱乐系统到军事仿真和兵棋推演中的决策框架等应用中已变得越来越普遍。然而,它们的开发带来了挑战,尤其是在模型设计或训练过程中嵌入无意偏差的风险。此类偏差可能源于训练环境或启发式假设,这些假设无意中偏爱某些行为,可能掩盖模型弱点或高估其鲁棒性(Royset, 2024)。在军事行动等高风险背景下,这些脆弱性可能转化为重大的作战风险。

对抗性实验提供了一种原则性方法来发现这些缺陷,方法是将受控扰动引入仿真输入,并观察由此产生的模型性能变化。早期关于对抗样本的研究(Goodfellow等人,2015)为此类扰动奠定了概念基础,而最近关于风险感知优化和最坏情况泛化的研究(Norton & Royset, 2023; Tong等人,2025)则形式化了在对抗性或重尾(heavy-tailed)条件下约束模型行为的方法。通过输入掩码或删除(input masking or deletion)来揭示决策边界的技术(Ivanovs等人,2021)进一步支持了进行局部想定探测的必要性。

为支持此分析,本论文采用了Atlatl,一个用Python开发的基于回合制的六角格兵棋推演平台。Atlatl提供了一个透明的、仿真驱动的环境,其中地形、单位编成和对抗行为等想定参数可以系统地变化。这种灵活性使其成为一个非常适合对抗性评估的测试平台,允许精确操纵实验条件,同时保留战术决策空间的复杂性。在此环境中,红方(Red forces)旨在通过守住战略目标和保持战斗力来最小化仿真得分,而蓝方(Blue forces)则追求最大化同一指标。该框架能够在结构化压力测试条件下评估脚本AI和强化学习(RL)AI智能体。

研究目标

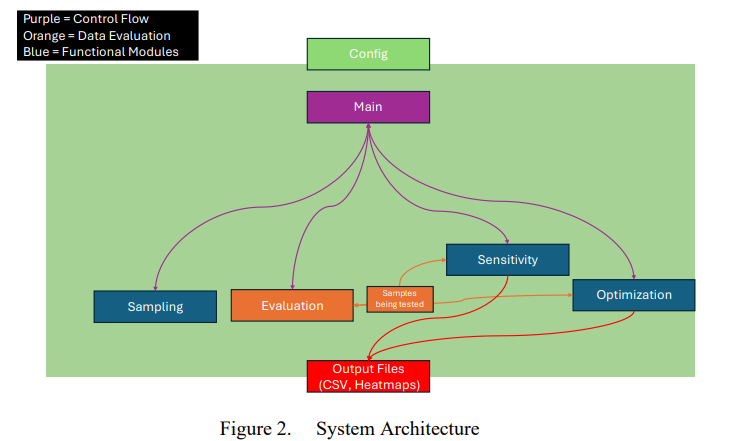

本研究的总目标是设计一个全面的对抗性实验测试平台,能够揭示脚本AI和神经网络AI中隐藏的缺陷。该系统将利用概率性想定生成、敏感性分析和邻域搜索启发式算法来创建超出常规测试条件的、对AI策略施加压力的想定。

具体目标包括:

• 开发一个概率性想定生成器,以产生各种各样的作战环境。

• 实施敏感性分析技术,以量化想定参数对AI在Atlatl环境中达成得分的影响。

• 评估邻域搜索启发式算法在识别对抗性想定方面的效用和局限性。

• 为在军事仿真背景下提高AI模型的韧性提供可操作的见解。

研究意义

本研究旨在通过引入对抗性实验作为一种结构化方法来识别隐藏的脆弱性,从而弥补AI模型评估中的一个关键空白。在军事仿真和决策背景下,模型故障可能产生严重后果。通过系统地将AI模型暴露于优化的对抗性想定中,本研究有助于开发更具韧性和可信赖的AI系统。研究结果旨在帮助军事利益相关者和AI开发者理解模型可能在何处失效,以及如何加强它们以抵御对抗压力。

论文结构

其余部分组织如下:

第二章:文献综述。本章探讨了对抗性机器学习、AI评估方法以及敏感性分析和邻域搜索启发式算法等相关技术的现有工作。

第三章:方法论。本章介绍了对抗性实验系统的概念框架,并概述了其设计的理论依据。

第四章:结果。本章展示了多次仿真运行的结果,重点介绍了对抗条件下AI性能的关键模式。

第五章:讨论。本章结合现有理论对结果进行解读,评估测试平台的有效性,并讨论对未来发展的启示。

第六章:结论。总结了关键见解和贡献,指出了局限性,并提出了未来研究的方向。