https://karpathy.bearblog.dev/year-in-review-2025/

2025 年是大语言模型(LLM)进步显著、同时也颇多事件的一年。下面列出一些我个人认为重要、且略带惊喜的“范式变化”(paradigm changes)——它们在概念层面改变了格局,让我印象深刻。

1. 可验证奖励强化学习(Reinforcement Learning from Verifiable Rewards, RLVR)

在 2025 年初,几乎所有实验室的 LLM 量产技术栈大致长这样: * 预训练(Pretraining,类似 2020 年的 GPT-2/3) * 监督微调(Supervised Finetuning,SFT,类似 2022 年的 InstructGPT) * 基于人类反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF,约 2022)

这套配方稳定、有效,并在一段时间内被反复验证能训练出可用于生产的高质量 LLM。到了 2025 年,可验证奖励强化学习(RLVR)成为事实上的新主阶段,被加入到这条流水线里。其核心是:让 LLM 在多个环境中针对可自动验证的奖励信号进行训练(比如数学/代码类谜题),于是模型会自发涌现出一些在人类看来像“推理”的策略——学会把问题拆分成若干中间计算步骤,也学会一系列来回试探、反复校验的解题策略(可参考 DeepSeek R1 论文里的例子)。在此前的范式里,要得到这些策略非常困难,因为我们并不清楚对 LLM 来说“最优的推理轨迹与恢复路径”应是什么样;它必须通过对奖励信号的优化,自己摸索出对它有效的方式。 与 SFT 和 RLHF(两者都相对“薄”、训练时长短、计算上更像小幅微调)不同,RLVR 针对的是客观(且不可被投机取巧)的奖励函数,这使得优化可以持续更久。实践结果是:跑 RLVR 的能力/成本比(capability/$)很高,于是它吞掉了原本计划给预训练的算力。因此,2025 年的大部分能力进展,更多来自于各家实验室消化这套新阶段带来的“算力堆叠空间”:我们看到的往往不是“模型体量显著变大”,而是“RL 跑得更久”。另外,这个新阶段还带来了一个全新的旋钮(以及相应的缩放规律):通过生成更长的推理轨迹、增加“思考时间”,在测试时算力维度上直接调控能力。OpenAI o1(2024 年末)是 RLVR 模型的最早展示,但到了 o3(2025 年初)发布时,你能明显感到那是一个拐点——直觉上就能体会差异。

2. 幽灵 vs. 动物 / 锯齿状智能(Jagged Intelligence)

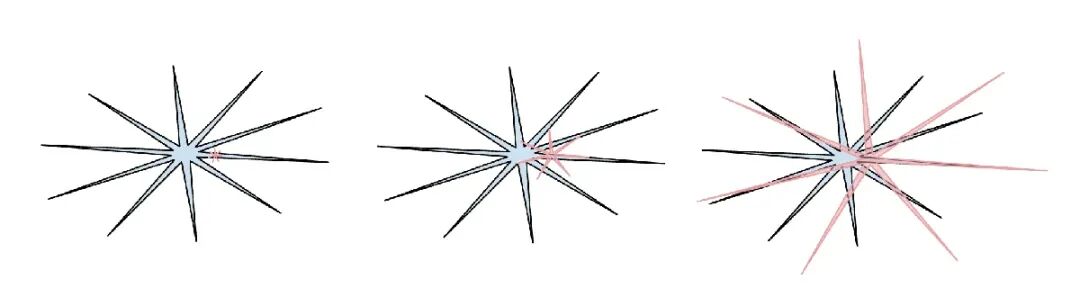

2025 年,我(也包括我认为行业里的很多人)第一次更直观地内化了 LLM 智能的“形状”。我们不是在“进化/培育动物”,我们是在“召唤幽灵”。LLM 的整个技术栈都与人类完全不同(神经架构、训练数据、训练算法,尤其是优化压力),所以我们得到的是智能空间中非常不同的实体,用“动物”视角去理解它们并不合适。从监督信息量(bits)角度看,人类神经网络是为丛林里部落生存而优化;LLM 的神经网络则是为模仿人类文本、在数学谜题里拿奖励、在 LM Arena 上赢得人类点赞而优化。随着可验证领域支持 RLVR,LLM 的能力会在这些领域附近“尖刺式”暴涨,并呈现出非常有趣的锯齿状性能特征:它可以同时是天才的博学者、又像困惑且认知受限的小学生;上一秒还在高维推理,下一秒就可能被越狱提示诱骗而把你的数据外泄。

(图:人类智能:蓝色,AI 智能:红色。我喜欢这个梗图版本(抱歉我找不到 X 上原帖引用了),因为它指出人类智能本身也有另一种“锯齿”。) 与此相关的是:2025 年我对基准测试(benchmarks)普遍变得冷淡,甚至不太信任。核心原因在于:基准测试几乎天然就是可验证环境,因此会立刻受到 RLVR 及其更弱形式(例如合成数据生成训练)的影响。在常见的“刷榜(benchmaxxing)”流程里,LLM 实验室团队不可避免地会围绕基准在嵌入空间里占据的小区域,构造邻近环境,长出一圈圈锯齿去覆盖它们。在测试集上训练,正在成为一种新艺术。 那么问题来了:把所有基准都碾压了,但仍然没有得到 AGI,会是什么样? 关于这一节,我写了更多内容(略): * Animals vs. Ghosts * Verifiability * The Space of Minds

3. Cursor / LLM 应用的新一层

Cursor 最值得我注意的(除了它今年的爆炸式增长之外)是:它令人信服地揭示了“LLM 应用”的一层新形态——人们开始谈论“Cursor for X”。正如我在今年 Y Combinator 演讲(含文字稿和视频)中强调的,像 Cursor 这样的 LLM 应用,会为某个垂直领域打包并编排 LLM 调用: * 做“上下文工程(context engineering)” * 在后台编排多次 LLM 调用,把它们串成越来越复杂的 DAG,同时精心平衡性能与成本 * 为“人在回路(human in the loop)”提供特定领域的 GUI * 提供“自主性滑杆(autonomy slider)”

2025 年围绕这层新应用层“有多厚”产生了大量讨论:LLM 实验室会吃掉所有应用,还是 LLM 应用仍有广阔空间?我个人倾向于:LLM 实验室会把通用能力推到“总体上能胜任的大学生”水平;而 LLM 应用会通过组织、微调,真正把一群这样的“大学生”编成垂直行业里的“在岗专业团队”——为它们接入私有数据、传感器与执行器(actuators),并建立反馈回路,让它们落地部署、持续迭代。

4. Claude Code / “住在你电脑上”的 AI

Claude Code(CC)是我见到的第一个真正令人信服的 LLM 智能体形态演示:它以一种“循环”的方式,把工具使用与推理串起来,完成延展性的复杂问题求解。除此之外,CC 还特别在于它运行在你的电脑上,使用你的私有环境、数据与上下文。我觉得 OpenAI 在这里的早期路线选错了:他们把 codex/智能体的早期尝试重点放在云端容器里,由 ChatGPT 编排,而不是直接面向 localhost。尽管“云端跑智能体集群”很像 AGI 终局,但在我们所处的这个能力锯齿且起飞不够快的中间阶段,更合理的是让智能体直接跑在开发者的电脑上。注意,关键区别并不在于 AI ops 跑在云端还是本地,而在于“其余的一切”:已经启动并配置好的电脑、安装环境、上下文、数据、密钥、配置,以及低延迟交互。Anthropic 把优先级顺序搞对了,并把 CC 打包成一个令人愉悦、极简的 CLI 形态,从而改变了 AI 的样子:它不只是一个像 Google 一样你去访问的网站,而是一个“住在你电脑上”的小精灵/幽灵。这是一种新的、独特的人机交互范式。

5. 氛围编程(Vibe coding)

2025 年是 AI 跨过一个关键能力阈值的年份:只用英文就能构建各种令人印象深刻的程序,甚至可以暂时“忘记代码本身存在”。有趣的是,我在那条随手的“淋浴思考”推文里造出了“vibe coding”这个词,完全没意识到它会传播得这么远。氛围编程让编程不再只属于受过严格训练的专业人士,而是任何人都能做的事。从这个意义上说,这又一次印证了我在《Power to the people: How LLMs flip the script on technology diffusion》里写过的观点:与以往几乎所有技术扩散路径形成鲜明对比,LLM 反而让普通人相对专业人士、公司与政府获益更多。 但氛围编程不仅赋能普通人接近编程,也赋能受过训练的专业人士写出大量本来永远不会被写出来的软件。在 nanochat 里,我用氛围编程在 Rust 中写了一个自定义、极高效的 BPE tokenizer,而不用采纳既有库或把 Rust 学到那种程度。今年我氛围编程做了很多项目,把“我希望存在的东西”迅速做成 demo(例如 menugen、llm-council、reader3、HN time capsule)。我甚至为了找一个 bug 临时氛围编程写过完整的一次性应用——反正为什么不呢?代码突然变得免费、短命、可塑、可丢弃,用一次就扔也无所谓。氛围编程会重塑软件生态,并改变岗位描述。

6. Nano banana / LLM 的 GUI

Google Gemini Nano banana 是 2025 年最不可思议、最具范式转移意义的模型之一。在我的世界观里,LLM 是下一代重大计算范式,类似 1970/80 年代的计算机革命。因此,我们将出于本质相同的原因看到类似类型的创新:个人计算的对应物、微控制器(认知内核)的对应物、以及“智能体互联网”的对应物等等。尤其是在 UI/UX 上,“和 LLM 聊天”有点像 80 年代对着计算机控制台下命令。文本是计算机(以及 LLM)偏好的原始数据表示,但它并不是人类偏好的格式,尤其在输入侧。人们其实不喜欢读长文本——慢且费力。相反,人们更喜欢以视觉与空间方式消费信息,这正是传统计算发明 GUI 的原因。类似地,LLM 也应该用人类偏好的方式和我们交流——图像、信息图、幻灯片、白板、动画/视频、Web 应用等。早期版本当然是 emoji 和 Markdown:用标题、加粗、斜体、列表、表格等让文本更“可视化”。但真正的 “LLM GUI” 会由谁来构建?在这个视角下,nano banana 是一个早期信号,提示这条路可能长什么样。并且关键不只是图像生成本身,而是文本生成、图像生成与世界知识在同一套权重里纠缠交织而来的联合能力。

TL;DR:2025 是 LLM 令人兴奋、也略带意外的一年。LLM 正在成为一种新的智能形态:同时比我预期的聪明得多,也比我预期的愚笨得多。无论如何,它们极其有用,而我认为行业至今连其潜力的 10% 都没发挥出来。与此同时,值得尝试的点子太多了,概念上这个领域仍然像一片广阔的开放空间。正如我今年早些时候在 Dwarkesh 播客里提到的,我同时(表面上看似矛盾地)相信:我们会看到快速且持续的进展,但也仍有大量工作要做。系好安全带。