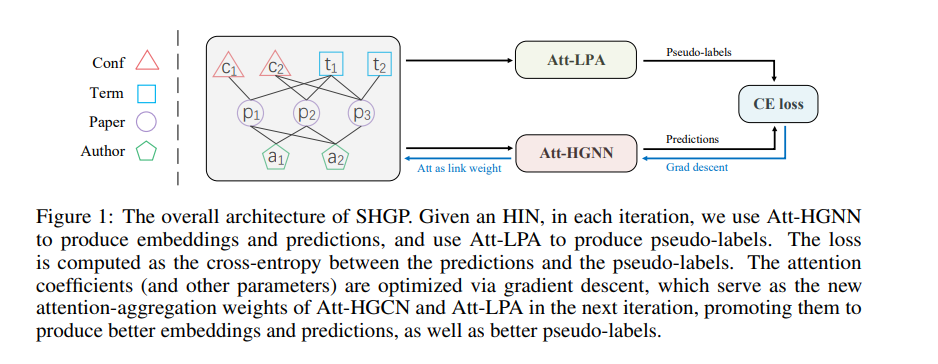

近年来,基于异构信息网络(HINs)的自监督预训练方法与传统的半监督异构图神经网络(HGNNs)相比显示出了良好的竞争力。不幸的是,它们的性能严重依赖于精心定制各种策略,以生成高质量的正例和反例,这明显限制了它们的灵活性和泛化能力。在这项工作中,我们提出了一种新的自监督异构图预训练方法SHGP,它不需要生成任何正例或负例。它由两个共享相同注意力聚合方案的模块组成。在每次迭代中,Att-LPA模块通过结构聚类产生伪标签,这些伪标签作为自我监督信号,指导Att-HGNN模块学习对象嵌入和注意系数。这两个模块可以有效地相互利用和增强,促进模型学习判别嵌入。在四个真实数据集上的大量实验证明了SHGP对最先进的无监督基线甚至半监督基线的优越有效性。我们在https://github.com/kepsail/SHGP发布源代码。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年12月2日

Arxiv

0+阅读 · 2022年12月2日