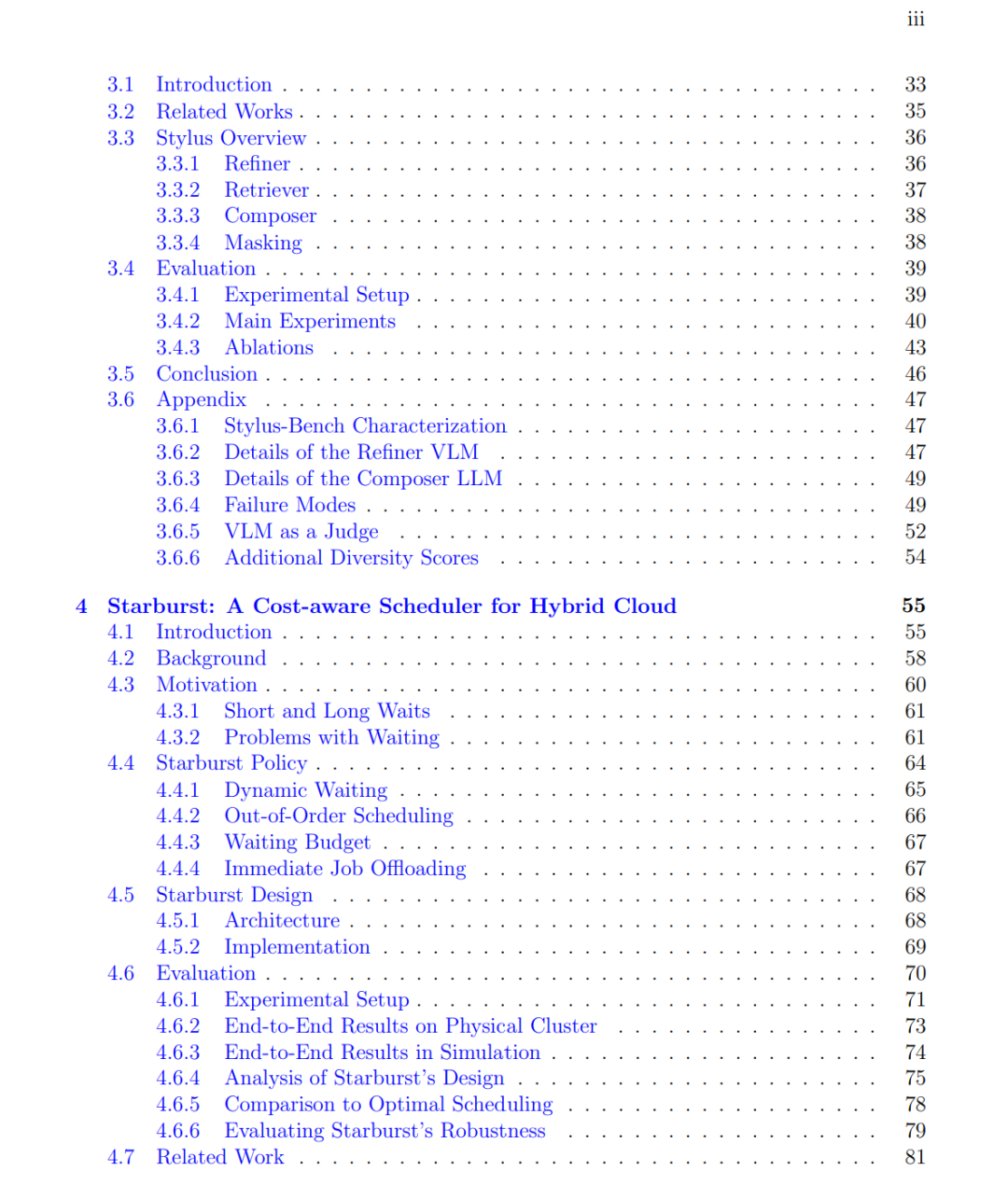

大型语言模型(Large Language Models,LLMs)在多样且复杂的任务上展现出了卓越能力,但前沿模型与成千上万具有领域特定需求的下游 AI 应用之间,仍然存在着一种根本性的解耦。这种割裂同时限制了性能与效率:模型的训练与服务过程并未考虑下游应用的具体需求。 在本论文中,我们设计了一系列系统与算法,将模型层与应用层进行紧密耦合,从而推动应用感知(application-aware)的基础设施与模型发展。首先,我们提出了三种面向应用感知基础设施的系统,用以优化成本与性能。Agentix 是一种推理服务引擎,它为 AI 智能体引入了应用感知的调度机制。通过跟踪 LLM 调用之间的依赖关系并利用应用层统计信息,Agentix 相较于 vLLM 等最先进系统,在端到端响应时间上实现了 4–15 倍的提升,从而显著降低了成本。接下来,Stylus 是一种可扩展的模型路由器,能够从超过 10 万个 LoRA 适配器中检索并组合最优适配器,从而在性能上超越基础版 Stable Diffusion。最后,Starburst 是一种面向混合云机器学习基础设施的成本感知调度器,它根据作业特性动态分配等待时间,在保持极低作业完成时间的同时,将云端成本最高降低 91%。 随后,我们进一步表明,通过强化学习(Reinforcement Learning,RL)将模型与应用进行耦合,能够同时实现更高性能与更低成本。借助 Agentica Project,我们展示了经由应用特定强化学习训练的小模型,能够以远低于前沿模型的成本达到相当的性能水平。DeepScaleR 是一个 15 亿参数的模型,仅使用 3,800 GPU 小时便在数学推理任务上超越了 o1-preview,相较以往方法实现了 18 倍的成本降低。DeepCoder 使用一个 140 亿参数模型,在竞技编程任务上达到了 o3-mini 级别的性能。最后,DeepSWE 训练了一个 320 亿参数的最先进自主编程智能体,其性能相比所有先前的开源智能体提升了超过 12 个百分点。 总体而言,这些工作为应用开发者与各类组织民主化了对前沿级 AI 能力的获取,使高性能、低成本的 AI 系统构建成为可能。