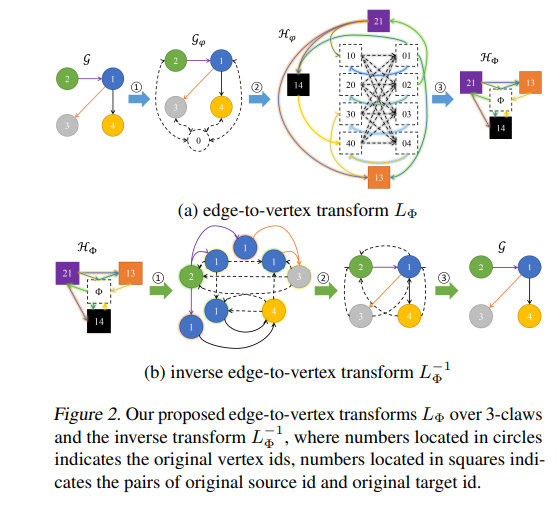

随着图核和图表示学习的发展,人们提出了许多更好的方法来处理图结构学习中的可伸缩性和过平滑问题。然而,这些策略大多是基于实践经验而不是理论分析而设计的。在本文中,我们使用一个特定的虚拟节点连接到所有现有的顶点,而不影响原始顶点和边的属性。我们进一步证明了这种虚拟节点可以帮助建立有效的单态边顶点变换和表态逆来恢复原始图。同时表明添加虚拟节点可以保持局部和全局结构,从而获得更好的图表示学习。我们利用虚拟节点扩展图核和图神经网络,并对图分类和子图同构匹配任务进行实验。实验结果表明,以虚拟节点作为输入的图显著提高了图结构学习,使用它们的边到顶点图也可以获得类似的结果。我们还讨论了在神经网络中从假点获得的表达能力。

成为VIP会员查看完整内容