论文题目

神经序列模型的合成语义解释:EXPLAINING COMPOSITIONAL SEMANTICS FOR NEURAL SEQUENCE MODELS

论文摘要

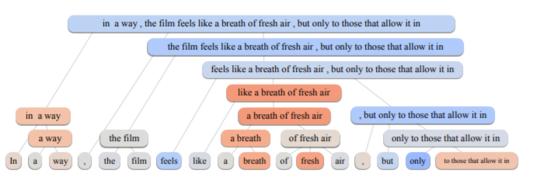

深层神经网络在处理自然语言中复杂的语义方面取得了令人印象深刻的性能,但大多被当作黑盒处理。为了说明该模型如何处理词和短语的组合语义,我们研究了层次解释问题。我们强调的关键挑战是计算单个单词和短语的非加性和上下文无关的重要性。我们发现,在层次解释方面的一些前期工作,例如上下文分解,在数学上不满足期望的性质,导致不同模型中的解释质量不一致。在本文中,我们提出了一种形式化的方法来量化每个单词或短语对生成分层解释的重要性。我们根据我们的公式修改了上下文分解算法,并提出了一种具有竞争性能的模型无关解释算法。在LSTM模型和微调的BERT变换器模型上进行的人工评估和自动度量评估都表明,我们的算法在层次扩展上的性能大大优于以前的工作。我们展示了我们的算法有助于解释语义的组成性,提取分类规则,提高模型的可信度。

成为VIP会员查看完整内容

相关内容

ICLR,全称为「International Conference on Learning Representations」(国际学习表征会议),2013 年才刚刚成立了第一届。这个一年一度的会议虽然今年才办到第五届,但已经被学术研究者们广泛认可,被认为「深度学习的顶级会议」。

ICLR由位列深度学习三大巨头之二的 Yoshua Bengio 和 Yann LeCun 牵头创办。

ICLR 希望能为深度学习提供一个专业化的交流平台。但实际上 ICLR 不同于其它国际会议,得到好评的真正原因,并不只是他们二位所自带的名人光环,而在于它推行的 Open Review 评审制度。

专知会员服务

15+阅读 · 2019年12月3日