近年来,大型推理模型(Large Reasoning Models,简称 LRM)因其在处理复杂任务方面的出色表现,逐渐成为研究热点。其中,DeepSeek R1 凭借其卓越的性能与开源特性,受到了广泛关注,推动了 R1 风格 LRM 的研究进展。与传统的大型语言模型(Large Language Models,LLM)不同,此类模型通过引入诸如长链式思维(long chain-of-thought)和基于强化学习的自我反思(self-reflection)等机制,在推理过程中进一步增强了逻辑演绎与决策能力。 然而,随着这类模型的广泛应用,“过度思考”(overthinking)问题也逐渐显现。具体而言,在生成答案时,模型往往构建过长的推理链条,其中包含冗余或重复的步骤,导致推理效率下降,甚至影响最终答案的准确性。为此,研究者提出了多种高效推理方法,旨在在不损害模型性能与推理能力的前提下,缩短推理路径的长度。 本文系统回顾了高效推理方法领域的最新研究进展,并从“单模型优化”与“模型协同”两个视角对现有工作进行分类: (1) 单模型高效推理(Efficient Reasoning with Single Model),关注于提升单个模型的推理效率; (2) 模型协同下的高效推理(Efficient Reasoning with Model Collaboration),探索通过多个模型协同优化推理路径的方法。 此外,我们还维护了一个公共的 GitHub 仓库,用于追踪高效推理方法的最新进展。我们希望本综述不仅能够整合近期的研究成果,也能提出一种全新的组织框架,通过“单模型优化”与“模型协同”这两个维度来理解高效推理这一主题。

1 引言

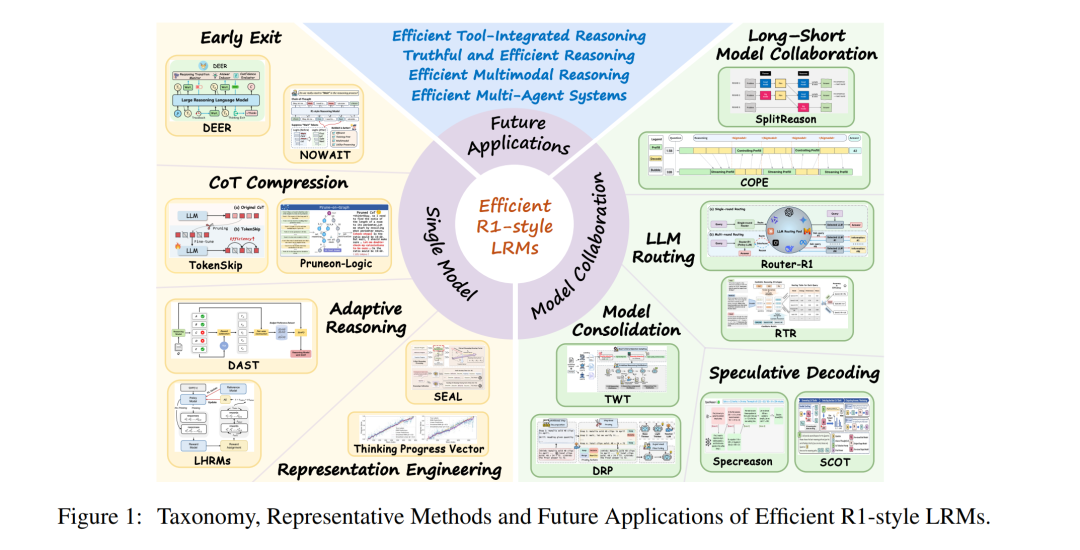

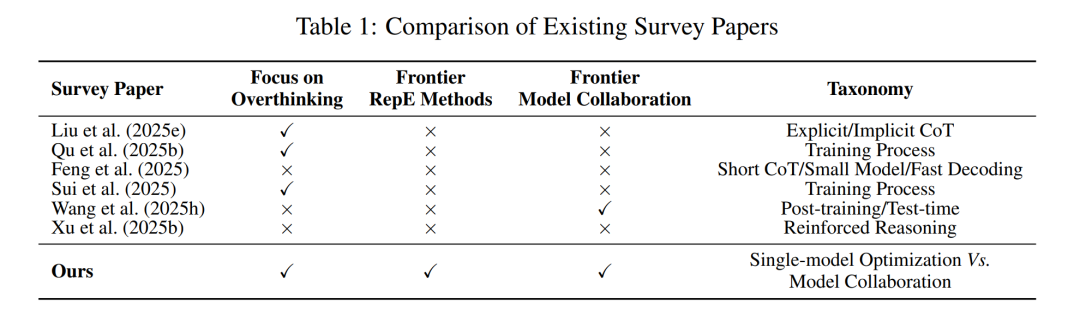

近年来,大型语言模型(Large Language Models,LLMs)在自然语言处理任务中取得了突破性进展。然而,在处理数学推理、多跳问答、程序验证等复杂任务时,LLMs 的推理能力仍然存在不足。因此,大型推理模型(Large Reasoning Models,LRMs)逐渐受到关注(Xu 等,2025b;Li 等,2025e;Chen 等,2025c)。这些模型通过引入**长链式思维(Long Chain-of-Thought,Long CoT)和自我反思(self-reflection)等方法,增强了结构化推理与高级认知能力,使其能够更有效地应对复杂问题。具有代表性的工作包括 OpenAI o1(Jaech 等,2024)、DeepSeek R1(Guo 等,2025)、Kimi 1.5(Team 等,2025)和 QwQ(Team,2024)。其中,DeepSeek R1 凭借其出色的推理精度与开源特性,成为 R1 风格 LRM 的标杆,其推理路径通常以 <think> 和 </think> 标签进行标注。 随着 R1 风格 LRM 在实际应用中的广泛部署,“过度思考”(overthinking)问题逐渐显现(Chen 等,2024b;Team 等,2025)。具体而言,在生成答案时,模型往往构建冗长的 CoT,包含冗余或低效的中间推理步骤。这不仅显著降低了推理效率、增加了计算成本,额外的推理过程还可能引入不确定性和输出的波动性,从而影响最终结果的准确性(Suvra Ghosal 等,2025)。例如,对于一个可在三步内解决的数学问题,模型可能会生成超过二十步的冗余推理过程,反而导致整体性能下降。 更进一步地,过度思考还可能引入安全风险,增加模型遭受恶意攻击的可能性(Kuo 等,2025;Fang 等,2025b)。因此,让模型“少想但更准”**已成为当前推理模型研究中的关键挑战。 为应对这一挑战,近期研究从多个维度出发,探索提升推理效率的方法,并已出现一些初步的综述性研究。如表 1 所示,这些工作(Liu 等,2025e;Qu 等,2025b;Feng 等,2025;Sui 等,2025;Wang 等,2025h;Xu 等,2025b)多聚焦于训练过程中的推理优化,以及显式与隐式 CoT 的有效推理机制。 然而,有别于以往的工作,本综述提出了一个新的分类视角,即从“单模型优化”与“模型协同”的双重视角出发,系统性地回顾自 2025 年以来的前沿研究。如图 1 和图 2 所示,我们将现有高效推理方法划分为两个主要方向: 1. 单模型高效推理(Efficient Reasoning with Single Model):聚焦于在单个模型内部优化推理路径,以提升计算效率。具体策略包括:提前退出(Early Exit)、CoT 压缩(CoT Compression)、**自适应推理(Adaptive Reasoning)**以及基于表示工程(Representation Engineering, RepE)的高效推理。 1. 模型协同下的高效推理(Efficient Reasoning with Model Collaboration):通过多个模型之间的协同机制提升推理效率。相关方法包括:长短模型协同(Long–Short Model Collaboration)、LLM 路由(LLM Routing)、模型整合(Model Consolidation)和投机解码(Speculative Decoding)。

本综述的结构如下所示: * 第 2 节介绍 LRM 及其在推理过程中面临的“过度思考”问题,以及高效推理的研究目标; * 第 3 节介绍单模型高效推理方法,探索如何优化单个模型的推理过程以提升效率; * 第 4 节探讨模型协同下的高效推理方法,聚焦于多个模型之间的协作机制如何提升推理效率; * 第 5 节展望未来发展方向,涵盖多模态高效推理、工具集成推理、多智能体系统与真实可信推理等前沿领域。