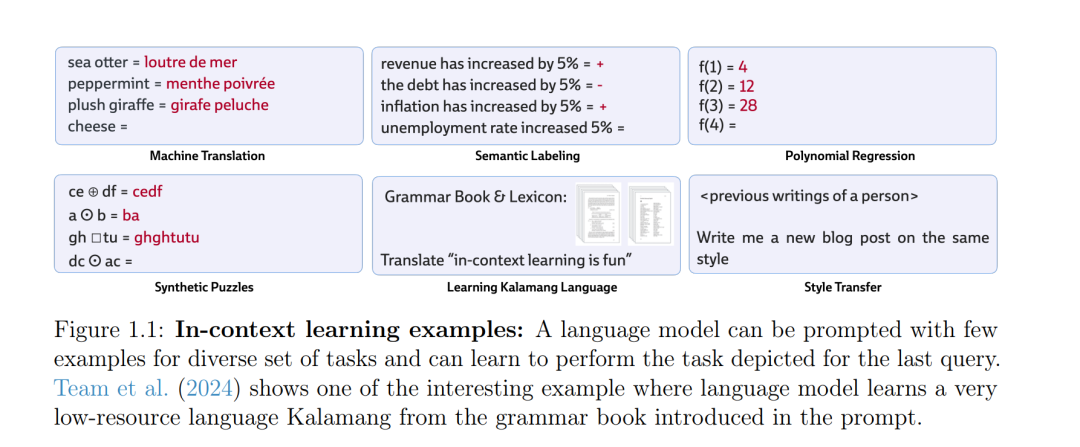

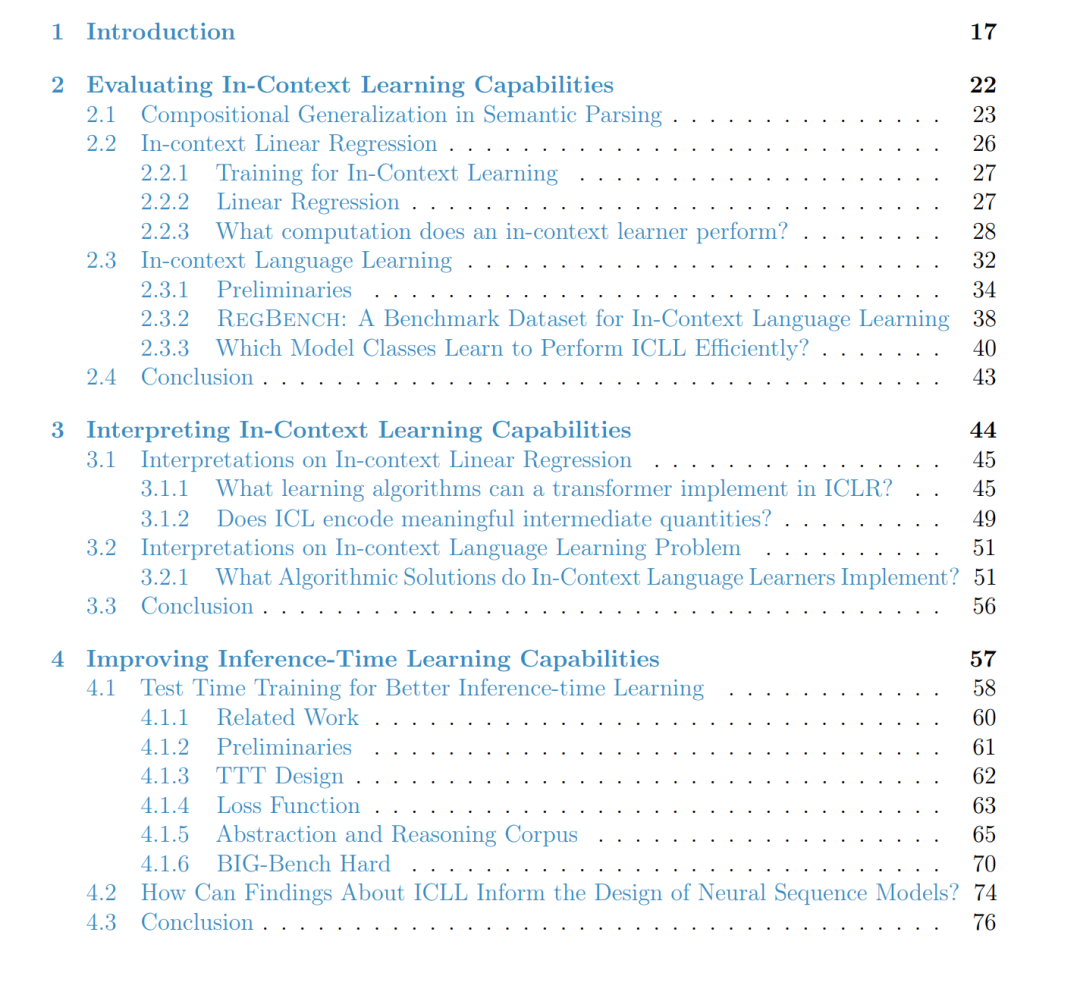

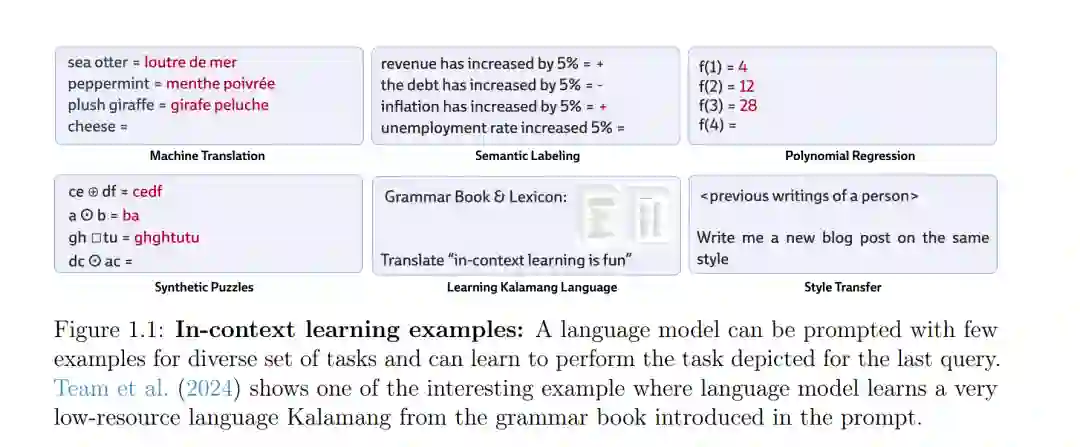

现代语言模型(Language Models,LMs)能够通过上下文学习(In-Context Learning,ICL)完成复杂任务——即在不进行任何参数更新的情况下,仅通过输入中提供的示例即可适应新任务。然而,关于这种适应机制何时有效、其背后的算法基础是什么,以及如何进一步提升其效果,仍然存在诸多根本性问题。本文系统研究了上下文学习的作用机制与局限性,并在语言建模与推理等多样化基准任务上,提出了更有效的推理时自适应方法。 本文首先评估了预训练语言模型的上下文学习能力。实验表明,在提供少量示例的情况下,语言模型能够实现较强的组合泛化能力。然而,在另一项分析中,我们发现,当模型面对其原本表现良好的任务的反事实变体时,其性能会显著下降。随后,本文构建了一系列用于研究 ICL 的“模型问题”,用于测试语言模型在上下文中学习全新数学结构的能力,例如线性函数和概率形式语言。 在此基础上,本文深入分析了上下文学习的算法层面基础。首先,我们证明了具有足够容量的 Transformer 模型可以执行线性回归问题的迭代式解法和闭式解法,并进一步表明,这些理论解在模型内部体现为可解释的中间变量。其次,我们揭示了语言模型如何形成专门化的计算回路,用以实现针对概率语言的近似 n-gram 学习算法。 基于上述洞见,本文提出了两种提升语言模型能力的方法。其一,通过在模型架构中显式引入 n-gram 计算机制,可以在多个任务领域中显著提升模型性能。其二,本文提出了一种推理时训练(test-time training)方法,该方法通过对输入数据进行梯度更新,实现快速自适应,在抽象推理任务上相较于标准的小样本学习取得了显著性能提升。 总体而言,本文的研究加深了我们对语言模型如何适应新任务的理解,并为提升其推理时学习能力提供了切实可行的技术路径。