原创作者:宋晨旭 王世泽 肖良望 孙楚芮

指导老师:张伟男

原创指导:刘元兴 转载须标注出处:哈工大SCIR

1. 物理AI介绍

1.1 背景

随着人工智能技术的火热发展,最新的GPT-5.1和Gemini 3等模型展示出了强大的自然语言对话和推理能力,也可以胜任数学、编程等领域的任务。视觉-语言-动作模型(VLA)则进一步利用了多模态大模型的能力,来控制机器人执行动作。 然而,当下普通的大模型仍然缺乏对现实世界的高层次感知与理解能力,VLA驱动的机器人可以完成简单的指令,但面对复杂的环境与任务时却显得乏力。举例来说,人类通过对于运动、惯性等物理知识的掌握,可以轻松预测一个运动中物体的行进轨迹;凭借对于空间的感知能力,人类可以轻松判断物体之间的距离远近、遮挡关系、方位朝向。类似的问题对于人类来说十分简单,但对于当下的人工智能模型来说却非常困难 [1]。我们期望机器人有朝一日可以像各种科幻题材的影视文学作品中那样,轻松完成从日常家务到专业生产的一系列任务,这种程度的人工智能也被称之为“通用人工智能”(Artificial General Intelligence)[2]。但是,人工智能目前的表现水平还远远不够。这一局限性的本质原因在于目前主流的大模型缺乏对于现实世界底层物理规则的理解,不能准确预测自身行为的物理后果,也就无法做到基于与其自身与现实世界的互动来持续调整策略。为此,人工智能领域的学者们提出了“物理人工智能(AI)”这一概念。

1.2 物理AI定义

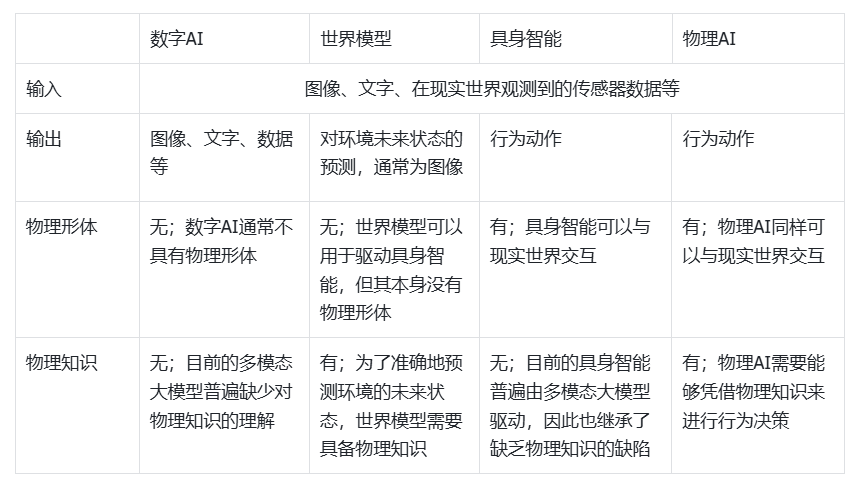

物理AI的定义可以总结为具备物理形体、掌握物理知识的人工智能。 物理AI****给予人工智能物理形体,让其能与现实世界直接交互。传统的人工智能指通过计算机程序来模拟人类智能,但普遍只存在于虚拟的数字空间中,无法与现实世界产生直接交互,可以被称之为“数字AI” [3] [4]。而物理AI则在传统数字AI的基础上,让人工智能通过物理形体获得与现实世界交互的能力,并具有行为驱动的学习能力,可以从互动中总结经验、学习知识。 另一方面,与同样拥有物理形体的“具身智能”相比,物理AI更加侧重对于现实世界物理规律的掌握,要求AI做到可以凭借对物理规律的理解来指导决策过程,在执行任务时充分考虑现实条件以及事物的因果规律。物理AI需要掌握对时间、空间的理解,以及动力学、热力学、电磁学等基础物理学知识,以此在现实任务场景中达到人类水平的推理与决策能力。 Salehi [3] 进一步解释了物理AI应具备的能力:物理AI是传统数字AI的进一步发展,不仅能够在数字空间中处理信息,也能主动地与现实物理世界进行交互,通过传感器来感知现实环境,并能够动态预测环境未来状态,根据掌握的知识自主决策行动。目的是可以做到自主适应,持续学习,在执行任务时充分考虑环境的不确定性、信息的不完全性,以及事物的物理规律。物理AI,是实现通用人工智能(AGI)路上的一步。 物理AI是一种高层面的人工智能设计与研发理念,注重“行动-反馈-学习-改变”的循环。物理AI也代表着对智能的一种新的思考方式:智能是无法从数据计算和功能的堆叠中产生出来的,而是从行动中涌现出来,行动应该被看作学习与思考的一种方式。对于物理AI来说,思考不仅仅是对知识的抽象理解、对数据的处理和计算,而是发掘动作与规律之间对应关系的过程。人工智能需要做到从行动和经验中学习,理解自身行为的内在意义,才能实现真正的自主性。

表1:物理AI与相关概念的比较(数字AI,世界模型,具身智能)。 物理AI定义中所包含的“行为驱动的学习能力”这一思想可以追溯至上个世纪90年代人工智能学界的观点,当时的部分学者认为思考离不开物理形体 [3]。Aslan Miriyev和Mirko Kovac两位学者在2020年Skills for Physical Artifical Intelligence一文中正式提出了物理AI的概念,将物理AI作为传统数字AI的对应,号召科研人员在人工智能及机器人的设计过程中充分考虑AI的物理形体,给予AI在现实世界的互动能力 [4]。英伟达公司CEO黄仁勋在2025年1月举办的美国消费类电子产品展览会(CES)上发表演讲时,重点提到物理AI,并认为物理AI将引领人工智能领域的新一波浪潮、将其称之为人工智能的新前沿。

图1:英伟达总裁黄仁勋在CES 2025的演讲中,预测物理AI会是人工智能领域的新前沿。图片来自网络。

2. 物理AI的代表性工作

2.1 Cosmos系列模型

英伟达公司在CES 2025期间公布了他们在物理AI领域的成果:Cosmos系列模型。其中,Cosmos-Predict1,也被称之为“世界基础模型”World Foundation Model,可以准确地预测系统的未来状态,生成符合物理规律的高质量视频 [5];Cosmos-Transfer1则允许用户控制视频生成的过程,针对不同的任务需要,调整生成视频中的物体材质、形状、结构,或者生成深度图等特殊形式的视频,满足无人驾驶、机器人控制等不同领域对于视频数据的不同需求 [6]。这两个模型生成的视频可以为物理AI的训练提供大量高质量、符合物理规律的训练数据,助力物理AI的研发。除此之外,Cosmos-Reason1模型作为特化的推理模型,采用了传统Transformer的自注意力与Mamba的混合架构,使得模型的上下文窗口更长、计算过程更高效;在经过大量的微调和强化学习训练后,拥有了相比于一般多模态大模型更强大的物理推理能力 [7]。

图2:英伟达Cosmos-Reason1推理模型 [7],采用了Transformer和Mamba的混合架构,在接受视频和文字输入后,可以针对现实场景问题输出带有思维链的推理过程与答案。

2.2 Gemini Robotics系列模型

谷歌DeepMind团队Gemini机器人搭载的Gemini Robotics系列模型也是物理AI领域的代表性工作之一 [8]。VLM模型GR-ER-1.5在谷歌Gemini模型的基础上针对具身推理进行了优化,可以将复杂的任务分解为一系列步骤,并在分步骤执行的过程中不断优化策略;GR-ER-1.5也拥有优秀的物理知识掌握能力,可以进行空间、时间推理,并理解一系列基础物理规律、因果关系,能准确判断物体的可供性(affordance)。而VLA模型GR-1.5则进一步将具身推理能力应用到机器人控制上,让机器人在执行动作前先针对任务目标进行思考,将任务分解后再逐步执行;这种分步骤行动的方法要优于一次性计划所有动作。除此之外,GR-1.5在训练中使用了名为Motion Transfer的新颖方法,使得GR-1.5可以学习多种具身形态机器人的数据,并可以将自身的能力以zero-shot的方式迁移至不同形态的具身机器人上,极大地提高了GR-1.5模型的泛用性。

图3:谷歌Gemini Robotics 1.5系列模型 [8],包括GR-1.5 VLA模型和GR-ER-1.5 VLM模型。二者搭配后可以高效地控制不同形体的机器人完成复杂的现实场景任务。

2.3 当前人工智能面临的挑战

物理AI这一领域目前仍处于起步阶段。为了尽可能地提升人工智能的学习与推理能力,让其达到或超过人类水准,需要先了解目前人工智能模型在数据、架构、训练方法等方面的缺陷,并加以解决。经过近些年来的研究积累,科学界对于目前人工智能的不足之处有了更深入的了解,这些缺陷可以归结为以下三个主要问题:**训练数据缺乏物理属性,对物理空间感知能力不足,以及缺乏物理知识。**如何解决这三个问题也成为了目前物理AI领域的三个主流研究方向:符合物理规律的数据生成,旨在解决数据拓展问题;增强物理空间感知能力,弥补传统AI在视觉感知上的缺陷;提升物理推理能力,让AI能够更好地基于物理知识进行行为决策,以应对复杂的现实场景任务。本文将分别介绍每个研究方向的背景与发展现状。

3. 符合物理规律的数据生成

3.1 问题背景:训练数据缺乏物理属性

多模态大模型的能力很大程度上取决于训练数据的质量。目前常用的训练数据集普遍取材于互联网上的文字、图像、视频,但这些数据中对空间结构、物理规律等方面的描述不足够、不准确,导致训练出来的模型无法掌握这些知识。以Kamath et.al. [31] 的工作为例,该文章发现LAION数据集中图片对应的文字描述经常包含模糊不清或错误的空间信息。然而,如果从头搭建数据集,则需要过滤海量的互联网数据、挑选合格的样本,或者需要在现实环境中收集真实数据,这两种做法都面临效率低、成本高的问题。仿真环境模拟出来的数据也很难准确地还原现实中的物理现象,存在sim-to-real鸿沟,不能直接迁移到机器人训练上。因此,想要实现物理AI,就要先解决训练数据缺乏物理属性的问题。

图4:Kamath et.al. [31] 对LAION数据集进行分析,发现很多图片的文字描述中包含模糊不清或者错误的空间介词,如above,below,behind等,部分图片并非与物体的空间关系有关。

3.2 研究内容

生成式AI的内容生成能力有潜力解决数据拓展问题。生成式AI可以低成本、高效率地生产图像、视频,甚至3D模型等各种形式内容,并以此作为人工智能模型的训练数据。但这一方法的前提是提升AI生成内容中物理现象的准确性。符合物理规律的数据生成旨在提升AI在生成内容的过程中对于物理现象的描述的准确性,生成各种场景下的高拟真度内容,为物理AI的训练提供高质量数据。目前,提升生成模型的物理准确性的工作主要可以分为以下两方面:(1)提升训练数据对物理现象的描述:已有的训练数据中缺乏对物理现象的具体性、准确性描述,导致模型的训练效果差,缺乏对物理现象的识别能力,因此一部分工作选择从头搭建高质量数据集,或者研发高效的数据生成、标注管道;(2)如何将物理规律融入生成过程中:物理现象可以用语言描述或者用数学公式表示,但将物理规律融入到模型的生成过程中并不容易,生成式模型需要具备将物理规律作为限制来控制生成过程,或者学会精确预测系统与环境在物理影响下的变化。

3.2.1 提升训练数据对物理现象的描述

生成式模型训练数据的主要形式是2D图像与文字描述组成的数据对,但常见的训练数据集中,2D图像通常并不会明显地展示某一物理现象的完整过程,文字描述也倾向于陈述图像的直观内容而往往省略具体的物理现象或者空间关系等信息 [9]。这使得基于这些数据训练得到的生成式模型缺乏对物理规律的理解,当用户提供文字指令或参考图片时,模型也不能准确预测出要生成的事物该如何依照物理规律进行变化发展。 为此,一部分工作从头搭建了高质量数据集,或者设计新颖的流程来改进已有的数据集。WISA [9] 从头构造了一个新的数据集WISA-80K,该数据集包含80000条视频,覆盖了力学、热力学以及光学3个核心物理领域内17个基础物理现象。WISA-80K的每一个样本简洁、直接地展示了具体的物理现象,避免数据对模型的训练产生干扰。另一方面,SpatialCLIP [10] 注意到数据集中图像配对的描述信息缺乏对于空间关系的解释,于是设计了一套利用MLLM重新为数据集编写图像描述的流程,并通过随机修改空间关系介词来生成负样本,让VLM可以在训练中学会分辨不同的空间关系。此外,PhysX: Physical-Grounded 3D Asset Generation [11] 这篇工作提出现有的3D数据的局限于几何结构和外观纹理,于是从头构造了一个拥有绝对尺度、材料属性、可供性、运动学以及功能描述5个方面的标注的数据集,并设计了一个可扩展的人工辅助的标注流水线,为目前的3D数据集进行物理标注。PhysX文章中提出的PhysXGen模型,在实现图片生成3D资产的同时,也能够为生成的3D资产标注其可能具有的物理属性。

图5:WISA [9] 工作中提出的WISA-32K数据集,包含3个类别17种不同物理现象的视频样本。

3.2.2 将物理规律融入生成过程

物理规律可以通过视觉图像、文字描述、数学公式等方法表示出来,但对于生成式AI来说,最关键的问题在于如何将这些对于物理规律的表示与模型的生成过程有效地结合起来。生成模型往往不能很好地理解视觉与文字中蕴含的物理规律,无法本能地在生成过程中识别到不符合物理规律的细节并进行干预;数学公式可以被引入到损失函数中,但现实世界的物理现象十分复杂,还经常涉及到多种物理规律之间的相互影响,让生成模型同时考虑大量的物理规律并不现实。为了让模型学会理解物理规律,并在生成内容的过程中将这些知识加以运营,科研界正在尝试各种训练方法与模型架构。 一部分工作从用户输入的提示(prompt)出发,加强物理信息对模型生成过程的约束。例如Hao et.al. [12] 的工作中提出,可以先让模型进行“反事实”推理,生成不符合物理规律的负提示(physics-aware negatives),再利用无分类器引导的方法,利用负提示来控制扩散模型在生成视频时远离那些会违反物理规律的特征。这种方法无需重新训练模型,可以直接应用在基座模型上。实验证明,在针对生成内容物理准确度的测试基准VideoPhy和PhyGenBench上,这种“负提示”控制的生成方式可以有效提高CogVideoX和Wan2.1等基座模型的表现。同时,WorldGPT [13] 中作者提出可以基于用户的输入图片,首先生成视频首部和尾部的关键帧,通过对prompt进行增强来引导视频生成模型在关键帧之间扩散出其他帧,保证生成视频中物体的空间一致性和动作一致性。

图6:Hao et.al. [12] 通过反事实推理生成负提示,让正提示与负提示相结合,共同引导模型生成符合物理规律的视频。 另外,以VideoREPA为代表的工作将物理规律融入进模型的损失函数中,让模型在学习优化损失函数的过程中学会物理规律 [14]。VideoREPA引入了Token Relation Distillation (TRD) 损失函数,该损失函数通过对空间和时间特征的关系进行对齐,将VFM中的物理理解能力蒸馏到T2V模型中,从而提高了生成视频的物理合理性。VideoREPA不依赖专门的物理数据集,具有更强的通用性,能够有效生成符合物理规律的视频。 与此同时,Ji et.al. 的PhysMaster [15] 和 Lin et.al. 的Phys-AR [16] 工作则利用强化学习的方式来训练生成模型最大程度上符合物理规律。PhysMaster提出了一个名为 PhysEncoder 的模块,专门用于从输入图像中提取物理信息,比如物体的相对位置、材质以及潜在的物理交互等;PhysEncoder将这些信息作为物理表示输入到生成模型中,从而利用增强prompt的方式来提升视频生成的物理一致性。在此基础上,为了优化物理表示并有效引导生成模型的训练,PhysMaster 采用了强化学习与人类反馈(RLHF)的策略,使用直接偏好优化(DPO) 框架来进一步提高生成视频的物理合理性。通过这种方法,模型能够根据人类反馈优化生成的视频,最大化物理一致性。Phys-AR也使用了监督微调(SFT)和强化学习相结合的方式,通过奖励函数优化模型的物理推理能力,确保生成的视频遵循物理法则。

4. 增强物理空间感知能力

4.1 问题背景:对物理空间的感知能力不足

物理AI要求人工智能做到与现实世界进行交互,这也就要求大模型需要具备更高水平的物理空间感知能力,能够理解并掌握物体与环境的三维空间关系。然而,目前的大模型普遍使用的编码器以CLIP为代表,但这些编码器在训练中主要依赖于2D图像,导致它们只能识别2D空间的信息而缺乏对于现实3D世界的理解。Tong et.al.的工作中即对CLIP模型视觉能力的缺陷进行了深入分析,发现基于CLIP编码器的多模态大模型在识别空间关系、物体细节上有很大不足 [32]。2D形式的输入难以准确提现3D世界的空间信息,但深度图、点云、3D建模等3D数据则可以帮助人工智能获得对现实环境更深入的理解。然而,深度图等数据虽然包含3D信息,但对模型的编码能力有很高要求,同时这些3D数据也普遍需要特定的感应设备来获取,如光学雷达等。因此,物理AI需要进一步提升人工智能模型的物理空间感知能力。

图7:SpatialBot [17] 一文中通过实验发现,以GPT-4o为代表的大模型单纯2D RGB图像输入,难以准确判断物体的空间关系,但通过深度图则可以针对问题做出正确回答。

4.2 研究内容

为了克服类CLIP编码器的局限性以及大模型无法掌握3D信息等问题,物理AI需要提升模型的物理空间感知能力,在2D图像与文字等常见的输入模态之外增加对深度图、点云、3D建模等数据格式的编码与学习能力,充分利用这些能够更准确体现现实世界3D特征的输入模式。另一方面,很多学者也在探索人工智能模型该如何更高效地从2D图像输入中感知3D信息,避免模型过度依赖于光学雷达等特化的感知设备。感知能力的提升将极大程度上促进物理AI对于现实世界的理解能力。增强物理空间感知能力的相关工作按照数据类型和对数据的处理方法可以分为两种:(1)3D模态输入,让模型在2D RGB图像以外也能够理解深度图、点云、3D模型等形式的数据;(2)从2D输入提取3D信息,通过架构上的改进或者数据处理方式,将3D信息从2D输入中还原出来。

4.2.1 3D模态输入

目前多数的大模型都使用类似CLIP架构的编码器来处理输入数据,将图像编码为token后与语言进行对齐。这些CLIP架构编码器普遍由2D图像和文字描述组成的数据对训练而来;然而,由于维度的压缩,2D图像普遍无法反应现实3D世界中的空间关系和动态变化的物理现象,这导致CLIP架构编码器缺乏对于空间关系和物理规律的理解。为了能让大模型更好地理解现实世界中复杂的空间、时间以及物理规律,一个自然而然的解决方法就是让模型接收3D格式的输入数据,例如深度图、点云,或者3D建模等。这些3D数据相比2D图像可以更好地还原现实世界,帮助大模型从输入中获得更多信息。 以SpatialBot [17] 模型为代表的工作,在普通的2D RGB图像之外也可以接收深度图作为额外输入,以此增强模型对于空间的理解能力。SpatialBot也考虑到室内场景和室外场景中物体深度信息的尺度不统一,例如室内场景中物体的深度普遍较小、但任务对于距离判断需要很高的精度,而室外环境下物体深度的数量级要远远大于室内物体,因此使用了ZoeDepth模型,使用单目深度估测算法来准确预测不同场景下2D RGB图像的深度信息,达到更优的效果。除了直接接受深度图输入外,SpatialBot也可以通过调用API的方式自主地获取RGB输入图像中目标物体的深度信息。

图8:SpatialBot架构图 [17]。SpatialBot可以在2D RGB图像以外接受深度图作为额外输入,或者通过调用API来估测物体的深度信息,以此辅助模型进行更准确的空间推理。 使用点云的大模型则以PointLLM为代表。PointLLM-v2 [18] 在模型中使用了点云编码器,能够将点云输入编码为特征,再经过MLP将这些3D特征映射到文字token的空间中,让语言模型基于文字与3D信息的混合token来生成回答。

图9:PointLLM-v2架构图 [18]。PointLLM-v2利用点云编码器来处理点云格式的输入,提取3D特征并融合至基座语言模型的token空间中,让语言模型基于文字与3D信息的混合token来生成回答。

4.2.2 从2D输入提取3D信息

虽然3D数据可以帮助大模型更好地从输入中获得更多3D信息,但在现实中,并不一定每一个任务场景都有3D数据可以作为输入。另外,通常只有在具有光学雷达等专业传感器的前提下,模型才能从环境中直接观察到深度图、点云等3D数据,这种硬件需求也限制了模型的应用性。出于这些原因,业界也在探索如何直接利用2D图像来获得更多3D信息。这类工作按实现方法可以大致分为两类:(1)架构上改进已有的大模型,使用空间编码器等方式从2D输入中提取3D特征;(2)数据上对2D输入进行处理,通过prompting或者构建3D坐标系等方式来增强模型对于3D关系的感知。

**4.2.2.1 架构改进

为了尽可能地从2D输入中提取3D信息,大模型可以在架构上进行改进,使用针对3D感知能力进行特化的编码器,来增强模型的感知能力。随着计算机视觉领域的技术发展,目前已有很多方法可以直接通过多张2D图像来精确地还原3D场景,比如最新的VGGT模型可以凭借2D图像输入直接推断出场景中的多种关键3D信息,比如相机的位姿、深度图、3D点跟踪等,这使得VGGT有潜力成为非常高效的空间编码器 [19]。 Spatial-MLLM [20] 使用VGGT模型作为额外的空间编码器,从2D视频输入中提取3D特征,再经由连接层与普通2D编码器得到的2D特征融合在一起。基于Qwen2.5VL-3B搭建的Spatial-MLLM凭借对3D信息更深入的理解,在针对视觉空间智能的VQA基准测试VSI-Bench上表现优秀,超过了Qwen2.5-VL-72B和LLaVA-Video-72B等开源大模型以及GPT-4o和Gemini-1.5-Pro等闭源大模型。Evo-0 [21] 则更进一步,将VGGT融入了VLA模型,可以在RLBench的仿真环境中高成功率地完成叠叠乐积木、拿雨伞、挂晾衣架等任务,表现优于和OpenVLA-OFT;在现实世界中也可以出色完成对普通物体以及透明材质物体的拾取、放置。

图10:SpatialMLLM架构 [20]。该模型包括2D编码器与空间编码器(基于VGGT模型)的双编码器架构,可以有效地从2D输入中提取3D信息,辅助模型对于空间任务的推理。 Chen et.al. [22] 的工作则从注意力机制视角系统分析了 VLM 空间推理失败的原因,通过实验发现模型在进行视觉推理时,注意力往往落在与问题无关的区域,且模型中间层的视觉注意力与答案正确性高度相关;基于实验结果,作者认为,真正关键的是注意力在图像上的几何分布是否与目标物体对齐。为此,作者选择改进模型的注意力解码阶段的过程,提出了ADAPTVIS方法:根据当前生成答案的置信度,对注意力进行缩放——置信度高时强化现有关注区域;置信度低时促使模型重新探索其他空间关系。在不改动视觉编码器和语言模型参数的前提下,该方法通过解码阶段的注意力调控显著缓解 VLM 的空间推理缺陷。

**4.2.2.2 数据处理

除了使用空间编码器等方法来改进模型架构上,模型也可以直接对输入进行处理,来辅助模型对于3D信息的感知,例如直接采用3D重建算法从2D图像输入中还原物体的三维坐标、位置等,帮助模型建立内在的三维坐标系;也可以在图像中为物体标注包围盒(bounding box),或在prompt中注入物体的包围盒信息,引导模型基于这些信息来进行空间推理。 以SpatialReasoner为代表的工作利用2D图像输入来还原3D场景信息,辅助模型在统一的3D坐标系下进行空间视觉推理。SpatialReasoner [23] 作为VLM,旨在提升模型对于3D VQA任务的几何感知能力,从单张2D图像预测物体的三维位置,将图像中的关键物体的坐标统一在三维坐标系下,并将其作为贯穿 “3D感知—几何计算—空间推理”的统一结构化接口,摆脱仅依赖自然语言进行隐式空间推断的局限。GPT4Scene [24] 针对VLM 在VQA任务中缺乏全局布局与跨帧对应的问题,提出了一种新的视觉提示范式,通过对纯2D视频输入进行结构化预处理来显式补充缺失的三维信息。其核心思路是先从视频输入中进行3D重建,生成Bird’s Eye View(BEV)俯视图,提供整体场景布局;再为所有帧与BEV引入一致的时空物体标记(STO-markers),构建局部观察与全局空间结构之间的对应关系。在无需修改模型架构的前提下,该范式为VLM提供可对齐的 3D 结构信号,使其具备跨帧一致的物体跟踪与场景定位能力,从而显著提升3D QA和视觉指代等任务表现。

图11:SpatialReasoner模型与其它模型在空间视觉推理任务上的对比 [23]。通过构建统一的三维坐标系,SpatialReasoner在推理过程中可以准确地判断出物体之间的空间关系,得到正确答案。 在VLA领域,Being-H0 [25] 通过恢复输入视频的三维一致性来增强模型的行动理解与机器人可迁移性。其利用MANO参数和弱透视投影,将来自不同视角、不同相机参数、不同分辨率视频的手部动作统一到共享的三维参考系,从而消除尺度、坐标系与成像几何的差异,为模型提供一致的3D空间语义。完成对齐后,Being-H0在此空间中学习手部运动的时间结构并执行视觉–语言–动作的统一建模。通过这一机制,Being-H0显式恢复输入视频的三维一致性,使其能够在后续阶段完成动作建模与机器人迁移。 另一方面,以Muturi et.al. [26] 为代表的工作则从prompt出发,通过在prompt中注入任务目标物体的包围盒,来辅助模型进行空间推理,提升推理结果的准确性。SpatialVLM [27] 也训练模型从2D输入中预估物体包围盒信息,并辅以思维链推理的方式,来让模型进行更深入的空间推理。

5. 提升物理推理能力

5.1 问题背景:缺乏物理知识

物理AI需要掌握现实世界中的物理规律,然而现实场景普遍十分复杂,多种物理现象经常交织在一起,涉及不同的原理。推理思维链CoT或者微调等方式虽然可以提升模型的通用推理能力,但却很难提升模型对于物理规律的理解和应用。此外,目前的VLA模型缺乏主动学习、持续学习的能力,无法做到从行动中总结规律、提取经验,并以此主动调整行为模式;在目前的信息不足以完成任务时,大模型普遍做不到主动地去调整策略、获得更多信息,或者回看输入、深入观察细节。为此,物理AI需要探索人工智能思考与推理的新范式,提升人工智能的物理推理能力。

5.2 研究内容

为了解决普通的大模型对于物理知识的缺乏,物理AI需要针对性地训练模型在推理与决策过程中考虑物理知识,训练模型掌握事物的因果关系,在决策和行动过程中将自身、周边物体与环境的物理特性当做决策因素与限制条件,这样才能进一步提升机器人在现实世界中的活动能力与任务成功率。物理AI还需要提升人工智能模型的主动适应与持续学习能力,不再依赖于提前设定好的行动规则,而是在通过与现实世界进行的交互中直接学习规律、总结经验,并能够主动地收集更多信息、智能识别到输入中与任务相关的细节,这样才能最大程度上提升物理AI的泛用性、通用性、自主性。然而,让人工智能学会这些能力并非容易之举,目前的大模型在提升物理推理能力方面主要面临以下三个方面的挑战:

5.2.1 探索更有效的推理增强技术

当前物理推理、空间关系建模与时间顺序理解等子领域普遍依赖通用的大语言模型推理范式。研究者倾向于采用微调、思维链、反思、提示工程等“性能增强型”捷径策略。例如英伟达的Cosmos-Reason1模型通过微调和强化学习的方式,一定程度上提升了模型对于汽车行驶、判断视频时间顺序等方面的推理能力 [7] 。然而,这些方法虽然有可能在特定任务上提升基准性能,却往往无法从根本上消除逻辑不一致或违反领域常识等问题,且缺失了对于领域下资源的广泛利用。这种“以通用能力覆盖专业需求”的路径虽在短期内见效快,但长期来看,制约了真正具备领域专家级推理能力的人工智能系统的发展。举例来说,PhysBench [28] 这篇工作通过实验证明,思维链方法并未能有效地提升大模型的物理理解能力,用语言来详细描述视觉信息中的物理图像并不能让模型更好地理解、遵循物理规律。关于空间智能的实验也证明,思维链方法同样不能提升大模型对于空间关系的理解 [1]。这些实验结果意味着模型需要更复杂的机制来真正做到“理解”视觉输入,而不能只是依靠简单的语言描述。为了能够最大化未来人工智能模型对于物理规律的理解能力,实现通用自主的物理AI,我们需要不断探索新的、更加有效的推理范式。Yang et al.在实验中发现思维链对于提升空间推理能力的局限性后,发现大模型可以通过构建认知地图(cognitive map)来显式地表示模型对于场景布局和空间关系的理解,并以此辅助推理过程 [1]。另一方面,以CoT-VLA [33] 为代表的工作开始探索“视觉思维链”(Visual CoT)这一新颖的推理增强方法,将视觉图像作为推理的中间步。相比于以往的VLA模型直接生成动作指令,CoT-VLA在思考过程中先生成图像,将任务分解为一系列中间状态,循序渐进地生成动作指令来逼近这些中间状态的任务目标,最后完成完整的任务。视觉思维链让人工智能能够像人类一样,直接用图像融入思考过程,弥补了传统的只依赖于文本信息的思维链方法无法捕捉现实环境视觉细节的缺点。 图12:CoT-VLA [33] 与普通VLA模型的对比:CoT-VLA没有直接生成动作指令,而是先生成预测图像作为中间状态,以此指引模型将任务分解为一系列步骤,逐步完成任务。

5.2.2 考察物理推理能力的测试基准

当前主流的考察人工智能推理能力的benchmark及其配套的基线模型往往流域表面,过多地聚焦于单选题形式的最终答案正确率,而忽视对推理过程本身的评估。这种“只看结果、不问过程”的评价方式,既无法判断模型是否通过合理的逻辑链条得出结论,也难以识别其是否依赖数据偏差或表面相关性进行猜测。更关键的是,它无法反映模型在面对复杂、多步、需整合多种约束条件的推理场景时的真实能力。因此,现有评测体系难以有效引导模型向可解释、鲁棒、符合人类认知逻辑的方向演进,科研界需要针对模型的物理推理能力,提出更加有针对性、考核更全面的测试基准,在问题设计上考察模型对于物理知识的全方面理解与运用,在评判标准上不仅要考虑答案准确性,更要观察模型的推理过程是否合理,避免模型通过统计学相关性“猜”到答案而非真正理解问题。Shen et.al. [29] 的工作认为,目前虽然已有很多物理知识相关的测试基准,如PHYBench,UG-Physics,OlympiadBench等,但这些基准的评测使用的是用文字描述的物理问题,缺乏对模型视觉理解能力的考察;为此,他们提出了PhyX测试基准,包含3000道基于视觉输入的物理推理问题,覆盖力学、电磁学、热力学、光学、声学、现代物理六个领域。PhyX相比PHYBench等以往的物理知识测试基准,更加注重模型对于视觉输入的理解能力,需要模型理解图画、函数图像等信息才能准确作答。这样的测试基准有助于科学界更加深入地研究人工智能的物理知识水平。Dong et.al. [30] 也同样注意到了目前常见的基准测试忽视了模型对于视觉输入的理解与运用能力,并提出在测试基准中应该增强对于模型推理过程的考察,确保模型不仅能够给出正确的最终答案,还能提供基于视觉线索的连贯、逐步推理路径。他们提出的MVPBench包含物理实验、物理问题、空间关系、动态预测四个门类,并在评判标准中加入了对于模型CoT推理过程的考察,包括CoT的发散性(生成不同推理路径的能力)以及CoT的效率(避免过于冗长的推理过程,让模型的推理更加简洁高效)。通过对CoT过程的深入评判,MVPBench发现过长的CoT确实会干扰模型的推理能力,让模型生成过多重复性、与任务不相关的思考内容。

5.2.3 增强跨模态推理能力

现有推理范式高度依赖文本模态,对视觉等其他感知模态的支持明显不足。一方面,多数模型在处理包含图像的任务时,仅将视觉信息作为辅助输入,未能将其深度融入推理过程;另一方面,训练数据中缺乏高质量的、图文对齐的多模态推理样本,导致模型难以从图像中提取结构化语义,进而限制了其在真实世界场景中的综合推理能力。这种模态割裂不仅削弱了模型对物理世界的整体理解,也阻碍了具身智能和多模态认知系统的发展,因此,人工智能需要提升跨模态推理能力,弥补过往模型的不足之处。首先,在视觉模态上,Chen et.al. [22] 在对大模型内在注意力的分布进行实验调查后发现,代表视觉图像输入的token占到所有token序列的90%,但最终只得到约10%的模型注意力。这意味着大模型在推理过程中,并没有真正地理解图像输入,也未能有效地利用图像信息中的全部细节,而是主要依靠文本描述在进行推理。实验同时也发现,直接提升视觉输入token的注意力权重也并不能增强模型的表现;相反,如果能把模型的注意力更好地集中在图像输入中与目标任务相关的细节上,模型在推理任务上的准确性则会有效提升。这证明对于模型来说,提升推理能力需要模型能够做到深入理解图像输入、捕捉与任务有关的视觉细节。为了解决这一问题,Chen et.al.在工作中提出了ADAPTVIS方法:根据当前生成答案的置信度,对注意力进行缩放——置信度高时强化现有关注区域;置信度低时促使模型重新探索其他空间关系。在不改动视觉编码器和语言模型参数的前提下,该方法通过解码阶段的注意力调控显著缓解 VLM 模型的空间推理缺陷。 图13:ADAPTVIS方法 [22] 可以根据模型对于当前生成答案的置信度,来对模型的注意力进行缩放,让模型在置信程度高时专注于细节,而在置信程度低时重新探索其它区域。这种方法有效提高了模型的推理准确性。其次,Kamath et.al. [31] 的实验证明类似CLIP架构的模型普遍缺乏对于空间关系的理解,不能将视觉图像中物体之间的空间关系与文字中类似“上,下,前,后”等方位介词对应起来。这一根本性缺陷的源头仍然是在CLIP架构的训练数据与训练方法上,主流的数据集中,图像的文字描述很少提供关于空间关系的准确描述,“上,下,前,后”等方位介词的使用混淆不清;而且空间关系的表示方法在不同数据中也并不一致,有些文字对空间关系的描述对应的是观众视角,而有些却对应的是图像中物体的视角;另外,早期数据集中训练任务的设计也并没有针对性检验模型的空间理解能力。该实验也再一次验证了目前的模型缺乏对于语言和视觉信息的跨模态整合能力,不能将文字、图像对应起来,以致于缺乏对于空间关系等关键知识的掌握与应用能力。因此,Kamath et al.在工作中号召未来的研究工作将目光放在如何进一步整合模型的图像与视觉感知能力,以便更好地实现跨模态理解与推理能力。

6. 总结

人工智能领域近几年来取得了突飞猛进的发展。基于多模态大模型的广泛运用,可以猜测未来更先进的人工智能模型一定会通用性更强、泛用性更广,并且在对知识和经验的总结、学习、应用能力上达到并超过人类水准。物理AI是目前科研界对于更先进的人工智能模型的期望之一,是人类对于实现AGI的一次尝试。本文总结了物理AI这一新兴研究领域的发展现状,将物理AI视为一种新颖的人工智能设计理念,其关键在于构建“行动-反馈-学习-改变”的循环,以行动的方式驱动模型的持续学习、自主适应。物理AI的发展目前面临着三大重要问题,即训练数据缺乏物理属性、对物理空间的感知能力不足、缺乏物理知识;针对这些问题,科研界正积极探索符合物理规律的数据生成、增强物理空间感知能力、提升物理推理能力三个研究方向,并已经取得了一定进展。可以相信,在不远的将来,学习能力更强、推理水平更高、行动更加智能的物理AI会成为现实。

7. 参考文献

[1] Yang, Jihan, Shusheng Yang, Anjali W. Gupta, Rilyn Han, Li Fei-Fei, and Saining Xie. 2025. Thinking in space: How multimodal large language models see, remember, and recall spaces. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 10632-10643. [2] Goertzel, Ben. 2014. Artificial general intelligence: Concept, state of the art, and future prospects. Journal of Artificial General Intelligence 5.1. [3] Salehi, Vahid. 2025. Fundamentals of Physical AI. Journal of Intelligent System of Systems Lifecycle Management 2. [4] Miriyev, Aslan, and Mirko Kovač. 2020. Skills for physical artificial intelligence. Nature Machine Intelligence 2.11: 658-660. [5] Nvidia. 2025. Cosmos world foundation model platform for physical ai. arXiv preprint arXiv:2501.03575. [6] Nvidia. 2025. Cosmos-transfer1: Conditional world generation with adaptive multimodal control. arXiv preprint arXiv:2503.14492. [7] Nvidia. 2025. Cosmos-Reason1: From Physical Common Sense To Embodied Reasoning. arXiv preprint arXiv preprint arXiv:2503.15558. [8] Gemini Robotics Team. 2025. Gemini robotics 1.5: Pushing the frontier of generalist robots with advanced embodied reasoning, thinking, and motion transfer. arXiv preprint arXiv:2510.03342. [9] Wang, Jing, Ao Ma, Ke Cao, Jun Zheng, Zhanjie Zhang, Jiasong Feng, Shanyuan Liu et al. 2025. Wisa: World simulator assistant for physics-aware text-to-video generation. arXiv preprint arXiv:2503.08153. [10] Wang, Zehan, Sashuai Zhou, Shaoxuan He, Haifeng Huang, Lihe Yang, Ziang Zhang, Xize Cheng et al. 2025. SpatialCLIP: Learning 3D-aware Image Representations from Spatially Discriminative Language. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 29656-29666. [11] Cao, Ziang, Zhaoxi Chen, Liang Pan, and Ziwei Liu. 2025. Physx-3d: Physical-grounded 3d asset generation. arXiv preprint arXiv:2507.12465. [12] Hao, Yutong, Chen Chen, Ajmal Saeed Mian, Chang Xu, and Daochang Liu. 2025. Enhancing physical plausibility in video generation by reasoning the implausibility. arXiv preprint arXiv:2509.24702. [13] Yang, Deshun, Luhui Hu, Yu Tian, Zihao Li, Chris Kelly, Bang Yang, Cindy Yang, and Yuexian Zou. 2024. WorldGPT: a Sora-Inspired Video AI Agent as Rich World Models from Text and Image Inputs. arXiv preprint arXiv:2403.07944. [14] Zhang, Xiangdong, Jiaqi Liao, Shaofeng Zhang, et al. 2025. VideoREPA: Learning Physics for Video Generation through Relational Alignment with Foundation Models. arXiv preprint arXiv:2505.23656. [15] Ji, Sihui, Xi Chen, Xin Tao, Pengfei Wan, and Hengshuang Zhao. 2025. PhysMaster: Mastering Physical Representation for Video Generation via Reinforcement Learning. arXiv preprint arXiv:2510.13809. [16] Lin, Wang, Liyu Jia, Wentao Hu, et al. 2025. Reasoning Physical Video Generation with Diffusion Timestep Tokens via Reinforcement Learning. arXiv preprint arXiv:2504.15932. [17] Cai, Wenxiao, Iaroslav Ponomarenko, Jianhao Yuan, Xiaoqi Li, Wankou Yang, Hao Dong, and Bo Zhao. 2025. Spatialbot: Precise spatial understanding with vision language models." In 2025 IEEE International Conference on Robotics and Automation (ICRA), pp. 9490-9498. IEEE. [18] Xu, Runsen, Shuai Yang, Xiaolong Wang, Tai Wang, Yilun Chen, Jiangmiao Pang, and Dahua Lin. 2025. Pointllm-v2: Empowering large language models to better understand point clouds. IEEE Transactions on Pattern Analysis and Machine Intelligence. [19] Wang, Jianyuan, Minghao Chen, Nikita Karaev, Andrea Vedaldi, Christian Rupprecht, and David Novotny. 2025. Vggt: Visual geometry grounded transformer. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 5294-5306. [20] Wu, Diankun, Fangfu Liu, Yi-Hsin Hung, and Yueqi Duan. 2025. Spatial-mllm: Boosting mllm capabilities in visual-based spatial intelligence. arXiv preprint arXiv:2505.23747. [21] Lin, Tao, Gen Li, Yilei Zhong, Yanwen Zou, Yuxin Du, Jiting Liu, Encheng Gu, and Bo Zhao. 2025. Evo-0: Vision-language-action model with implicit spatial understanding. arXiv preprint arXiv:2507.00416. [22] Chen, Shiqi, Tongyao Zhu, Ruochen Zhou, Jinghan Zhang, Siyang Gao, Juan Carlos Niebles, Mor Geva, Junxian He, Jiajun Wu, and Manling Li. 2025. Why is spatial reasoning hard for vlms? an attention mechanism perspective on focus areas. arXiv preprint arXiv:2503.01773. [23] Ma, Wufei, Yu-Cheng Chou, Qihao Liu, Xingrui Wang, Celso de Melo, Jianwen Xie, and Alan Yuille. 2025. Spatialreasoner: Towards explicit and generalizable 3d spatial reasoning. arXiv preprint arXiv:2504.20024. [24] Qi, Zhangyang, Zhixiong Zhang, Ye Fang, Jiaqi Wang, and Hengshuang Zhao. 2025. Gpt4scene: Understand 3d scenes from videos with vision-language models. arXiv preprint arXiv:2501.01428. [25] Luo, Hao, Yicheng Feng, Wanpeng Zhang, Sipeng Zheng, Ye Wang, Haoqi Yuan, Jiazheng Liu, Chaoyi Xu, Qin Jin, and Zongqing Lu. 2025. Being-h0: vision-language-action pretraining from large-scale human videos. arXiv preprint arXiv:2507.15597. [26] Muturi, Tanner W., Blessing Agyei Kyem, Joshua Kofi Asamoah, Neema Jakisa Owor, Richard Dzinyela, Andrews Danyo, Yaw Adu-Gyamfi, and Armstrong Aboah. 2025 Prompt-guided spatial understanding with rgb-d transformers for fine-grained object relation reasoning. In Proceedings of the IEEE/CVF International Conference on Computer Vision, pp. 5280-5288. [27] Chen, Boyuan, Zhuo Xu, Sean Kirmani, Brain Ichter, Dorsa Sadigh, Leonidas Guibas, and Fei Xia. 2024. Spatialvlm: Endowing vision-language models with spatial reasoning capabilities. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 14455-14465. [28] Chow, Wei, Jiageng Mao, Boyi Li, Daniel Seita, Vitor Campagnolo Guizilini, and Yue Wang. 2025. PhysBench: Benchmarking and Enhancing Vision-Language Models for Physical World Understanding. In ICLR 2025 Workshop on Foundation Models in the Wild. [29] Shen, Hui, Taiqiang Wu, Qi Han, Yunta Hsieh, Jizhou Wang, Yuyue Zhang, Yuxin Cheng et al. 2025. PhyX: Does Your Model Have the" Wits" for Physical Reasoning?. arXiv preprint arXiv:2505.15929. [30] Dong, Zhuobai, Junchao Yi, Ziyuan Zheng, Haochen Han, Xiangxi Zheng, Alex Jinpeng Wang, Fangming Liu, and Linjie Li. 2025. Seeing is Not Reasoning: MVPBench for Graph-based Evaluation of Multi-path Visual Physical CoT. arXiv preprint arXiv:2505.24182. [31] Kamath, Amita, Jack Hessel, and Kai-Wei Chang. 2023. What’s "up" with vision-language models? Investigating their struggle with spatial reasoning. In Proceedings of the 2023 Conference on Empirical Methods in Natural Language Processing, pp. 9161-9175. [32] Tong, Shengbang, Zhuang Liu, Yuexiang Zhai, Yi Ma, Yann LeCun, and Saining Xie. 2024. Eyes wide shut? exploring the visual shortcomings of multimodal llms. In Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, pp. 9568-9578. [33] Zhao, Qingqing, Yao Lu, Moo Jin Kim, Zipeng Fu, Zhuoyang Zhang, Yecheng Wu, Zhaoshuo Li et al. 2025. Cot-vla: Visual chain-of-thought reasoning for vision-language-action models. In Proceedings of the Computer Vision and Pattern Recognition Conference, pp. 1702-1713.