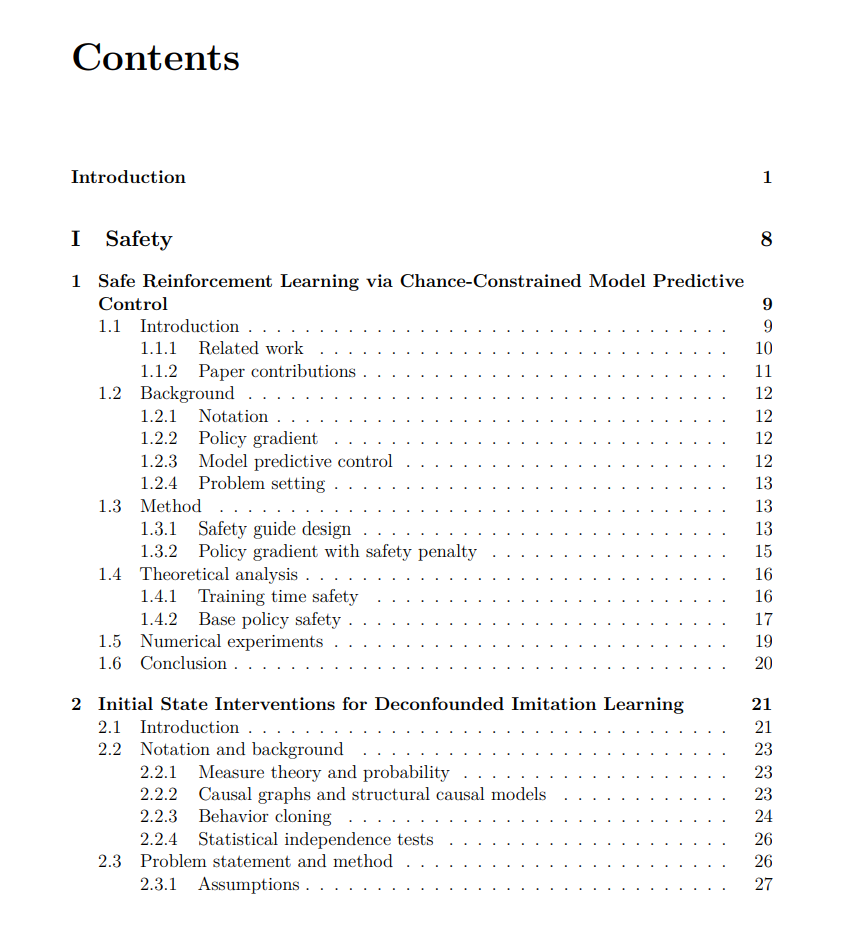

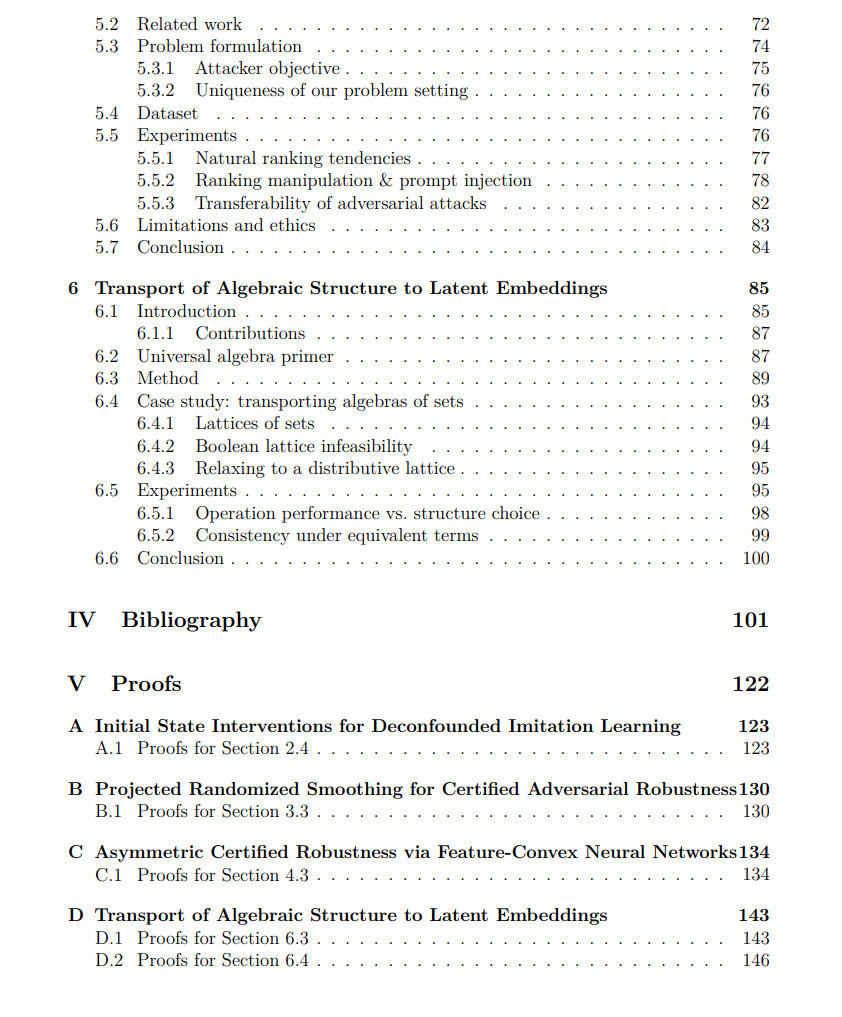

机器学习有望在科学、工业和社会等众多领域产生深远影响。尽管当前的人工智能(AI)系统仍普遍依赖人类监督,未来的应用将越来越多地要求系统具备高度自治能力。要实现这一转变,我们必须能够信任这些日益庞大的模型的行为。为此,本论文围绕三个关键研究方向展开:安全性、鲁棒性与可解释性。 我们首先聚焦于强化学习(Reinforcement Learning, RL)与模仿学习(Imitation Learning, IL)中的安全问题。尽管学习得到的策略在性能上取得了显著成果,但它们在训练过程中的探索行为及测试阶段环境的变化,常常会导致不安全的决策。为此,我们提出了一种基于模型预测控制(Model Predictive Control, MPC)的安全引导机制,可在用户指定约束条件下,对基础 RL 策略的动作进行修正。通过合理的优化建模与损失函数设计,我们从理论上证明了最终优化得到的基础策略在最优点上具有可证明的安全性。 针对 IL 中独有的因果混淆(causal confusion)问题,即观测数据与专家行为之间存在虚假相关,进而可能在部署时引发不安全行为,我们引入结构因果模型(Structural Causal Models, SCMs)的工具来识别并屏蔽存在问题的观测信息。与此前需依赖专家反馈或专家奖励函数的做法不同,我们的方法仅需实验者能对初始状态进行干预这一更为现实的假设。 论文第二部分关注如何增强分类器对抗扰动下的鲁棒性。分类器是众多 AI 系统的核心组件,但实验表明其对输入中的微小扰动极为敏感。我们首先扩展了随机平滑(randomized smoothing)方法的适用性,从传统各向同性认证推广至数据流形子空间的投影,从而在认证体积上获得数量级的提升。随后,我们从更基础的层面重新审视鲁棒性问题,提出了非对称鲁棒认证(asymmetric certification)框架。在该二分类场景下,我们仅要求模型在某一特定类别上具备认证鲁棒性,符合现实中对抗者主要关注产生“假阴性”(false negatives)的实际需求。我们进一步引入一类特征凸(feature-convex)结构,从而实现高效、确定性、封闭形式的认证半径计算。 论文的第三部分探讨了模型可解释性的两个方面:一是大型语言模型(LLMs)如何决定向人类用户推荐什么,二是如何构建结构上可解释的学习模型。我们首先分析了对话式搜索引擎中 LLM 对消费产品排序的行为,结果表明,模型在优先考虑产品名称、网站内容及输入上下文位置方面存在显著差异。最后,我们提出了一类新的可解释模型——结构传输网络(Structural Transport Nets),用于那些潜在表示具备数学结构的领域。通过学习一个到“镜像代数结构”的双射映射,我们能够在潜在空间中执行满足原始输入空间代数规律的操作。实验表明,遵守底层代数规律对于学习准确且自洽的表示操作至关重要。