论文题目:RTQA: Recursive Thinking for Complex Temporal Knowledge Graph Question Answering with Large Language Models

本文作者:宫照堰(浙江大学)、李娟(浙江大学)、刘治强(浙江大学)、梁磊(蚂蚁集团)、陈华钧(浙江大学)、张文(浙江大学)

发表会议:EMNLP 2025

论文链接:https://arxiv.org/abs/2509.03995

代码链接:https://github.com/zjukg/RTQA

欢迎转载,转载请注明出处****

一、研究背景

在现实世界中,人物、事件与关系都在不断随时间推移而变化。如何让机器理解“时间”这一动态维度,是人工智能领域一个长期而重要的挑战。 时间知识图谱(Temporal Knowledge Graph, TKG) 通过在实体关系中引入时间戳,能够更真实地反映事件演化过程。基于此的 时间知识图谱问答(Temporal Knowledge Graph Question Answering, TKGQA) 任务,要求模型在时间维度上进行推理,例如: “Before Kuwait, which country received the Government Delegation of North Korea's visit last?” “在访问科威特之前,朝鲜政府代表团最后访问的是哪个国家?” 这样的问题不仅涉及实体间的逻辑关系,还包含复杂的时间约束与顺序逻辑。 现有 TKGQA 方法虽然在处理简单时间问题(如“在某年谁担任总统”)时表现良好,但在面对多种时间约束的组合问题、多跳时序问题、多种时间粒度时,往往容易出现以下两类问题:

- 推理能力有限 —— 模型难以同时处理多个时间约束,容易出现“幻觉式”回答;

- 误差累积严重 —— 在多轮分解式推理中,子问题的错误会逐层放大,导致最终答案偏离事实。

二、研究创新

为解决上述挑战,提出了一个全新的、无需训练的推理框架 —— RTQA(Recursive Thinking Temporal Knowledge Graph Question Answering)。 RTQA 以“递归思维(Recursive Thinking)”为核心理念,模仿人类解决复杂问题的方式:将复杂问题分解为若干子问题,自底向上逐步求解。整个框架由三个核心组件构成:

- Temporal Question Decomposer(时间问题分解器)

将复杂时序问题分解为若干个子问题。例如:

原问题:“Before Kuwait, which country received the visit last?” 分解后: ① When did Kuwait receive the visit? ② Before #1, which country received the visit? ③ Which was the last among them? * Recursive Solver(递归求解器)

结合 大语言模型(LLM) 的推理能力与时间知识图谱中的事实信息,递归地求解每个子问题。 * Answer Aggregator(答案聚合器)

为避免误差传播,RTQA 设计了多路径答案融合机制,综合来自原问题与子问题的多条推理路径,选取最可靠的最终答案,从而提升整体鲁棒性。

这一设计使得 RTQA 能够在不依赖额外训练的情况下实现“复杂多约束时间逻辑推理”,让大语言模型具备“时间感知”的递归思考能力。 三、实验结果

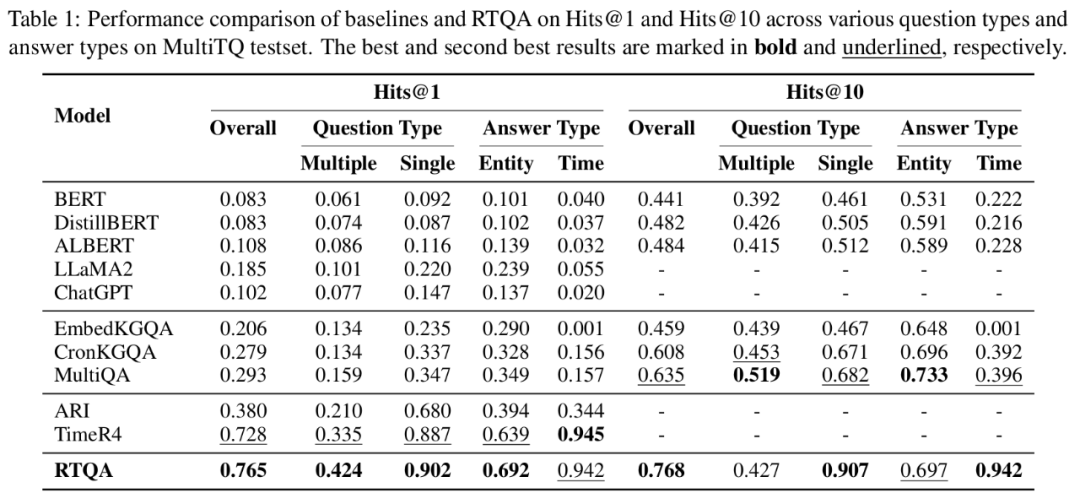

RTQA在两个权威时间知识图谱问答基准数据集上对 RTQA 进行了全面评测:

- MultiTQ:涵盖多种时间粒度(年、月、日)的 50 万条问答样本;

- TimelineKGQA:针对事件序列与时间顺序设计的复杂时序问答数据集。

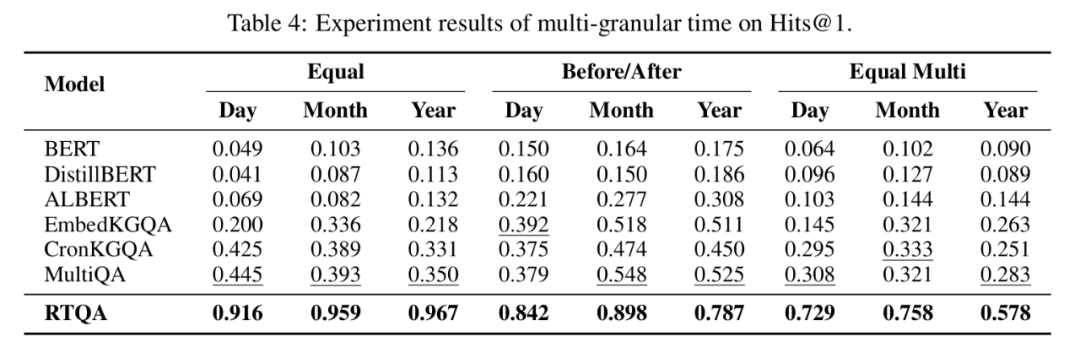

- 在主流指标 Hits@1 与 Hits@10 上,RTQA 均取得了显著领先:

- 在 MultiTQ 上,RTQA 的 Hits@1 达到 0.765;

- 同时在多粒度时间推理任务(年/月/日)上均保持领先表现。

- RTQA是一个无需训练的框架,能在不同语言模型间无缝切换,保持稳定性能,体现出优异的可迁移性与可扩展性。

**

**

四、结论与展望

RTQA 的提出,不仅提升了大语言模型在复杂时序问题上的推理能力,更为知识增强大语言模型提供了新思路。 它证明了通过“递归式分解与聚合”的思想,可以在无需额外训练的前提下,显著增强大模型的时间推理能力。