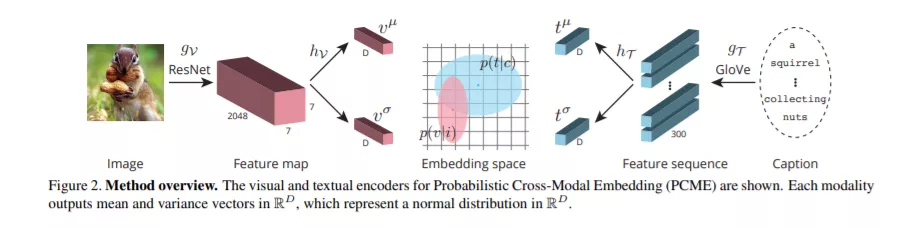

跨模态检索方法为来自多种模态的样本建立了一个共同的表示空间,尤其是来自视觉和语言领域的样本。对于图像和它们的说明文字,对应的多样性使得这项任务特别具有挑战性。给定一个图像(分别是一个标题),有多个同样有意义的标题(分别是图像)。在本文中,我们认为确定性函数不足以捕获这种一对多对应。相反,我们提出使用概率交叉模态嵌入(PCME),来自不同模态的样本在公共嵌入空间中表示为概率分布。由于诸如COCO这样的通用基准测试在跨模态匹配时存在非详尽注释的问题,我们建议额外评估CUB数据集上的检索,这是一个更小但更干净的数据库,其中所有可能的图像标题对都被注释。我们广泛地ablate PCME,并证明它不仅提高了检索性能,其确定性对等物,但也提供不确定性估计,使嵌入更可解释。

成为VIP会员查看完整内容

相关内容

Arxiv

3+阅读 · 2019年10月17日

Arxiv

12+阅读 · 2018年3月9日