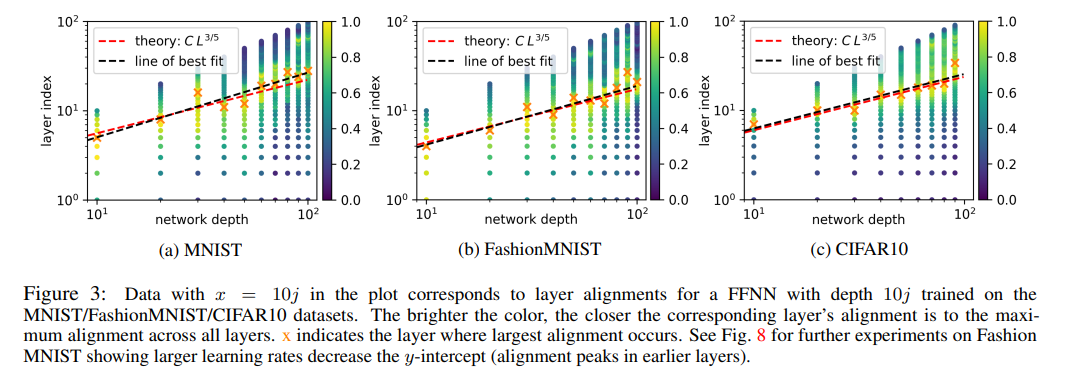

Baratin等人最近的工作(2021)揭示了深度神经网络训练期间发生的一个有趣的模式:与其他层相比,一些层与数据的对齐更多(其中对齐被定义为切线特征矩阵和数据标签矩阵的欧氏乘积)。对齐曲线作为层指数的函数(通常)表现出一种上升-下降模式,在某些隐藏层达到最大值。在这项工作中,我们为这一现象提供了第一种解释。我们引入平衡假设,将这种对齐模式与深度神经网络中的信号传播联系起来。我们的实验证明与理论预测非常吻合。

https://www.zhuanzhi.ai/paper/eb536aebcbd07e082fa029bfa966c533

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年7月20日

Arxiv

0+阅读 · 2022年7月16日