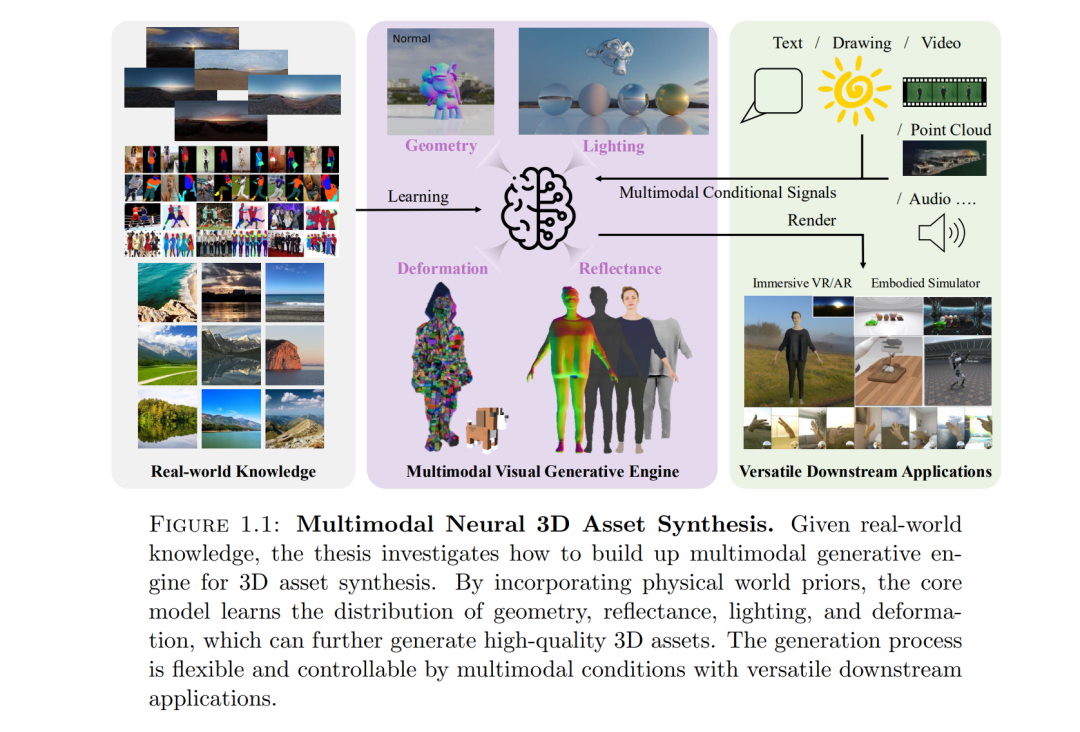

三维资产合成(3D asset synthesis)位于计算机图形学、计算机视觉与人工智能的交叉点,核心目标是创建高质量的三维模型,包括几何结构、纹理、材质以及动画,以支持逼真渲染(photorealistic rendering)。 本论文针对该领域的三个基本挑战展开研究:如何高效地从非结构化数据中学习;如何通过物理先验实现超越训练分布的泛化能力;以及如何灵活地与多模态控制进行对齐。此外,本论文涵盖了三个研究层次:人类级资产合成、场景级辐射生成、以及物体级资产生成,并提出了六种创新方法,共同推动了神经三维资产合成的最新进展。

首先,论文提出 Relighting4D,这是首个能够从单目视频(无需详细标注)合成 四维人类反射率(4D human-level reflectance) 的方法。该系统通过基于可变形人体模型的神经场,在时空维度上聚合观测,并将其分解为几何与反射分量,以支持物理渲染。这使得从普通视频输入即可实现动态人体重光照和自由视角渲染,从而大幅降低高质量人体资产创建的门槛。

其次,论文提出 PrimDiffusion,这是首个用于 三维人体生成 的扩散模型。该方法引入了一种新颖的 基于体素原语(volumetric primitive-based)表示,既保留了体素表示的强大能力,又具备高效的基于原语渲染特性。这种表示形式使得扩散模型拥有紧凑的参数空间、灵活的人体先验引入、以及无需解码器的高效渲染,同时自然捕获稠密对应关系,利于下游任务。

第三,论文提出 URHand,这是首个 通用可重光照手部模型,能够跨视角、跨动作、跨光照、跨身份进行泛化。该模型通过保持线性特性的单阶段训练实现跨身份泛化,并能有效扩展至大规模光舞台数据采集,展现出对新光照条件的鲁棒泛化能力。

第四,论文在 场景级辐射生成 上提出 Text2Light,这是首个 零样本文本驱动的 HDR 全景生成方法。该方法采用两阶段框架:第一阶段根据文本描述生成低动态范围(LDR)、低分辨率的 360° 全景图;第二阶段通过超分辨率反色调映射算子同时提升分辨率与动态范围。最终实现了从简单文本输入即可生成高质量、超高分辨率的 HDR 全景图像。

第五,论文提出 SceneDreamer,这是一个 无界三维场景生成 的学习范式,能够从“自然采集的二维图像集”(无相机参数)中生成无界三维场景。该框架结合了高效的三维场景表示、生成式场景参数化,以及体积渲染器,充分利用二维图像知识,从而生成多样化、逼真的无界三维环境。

第六,论文提出 3DTopia-XL,这是一个面向规模化三维资产生成的 高质量原生三维生成模型。该系统基于新颖的 原语驱动三维表示(PrimX),能够统一编码形状、反照率与材质,并支持高效的可微渲染。它能够快速从带纹理的网格进行张量化,并在生成高分辨率几何和基于物理渲染(PBR)的三维资产方面展现出卓越性能。