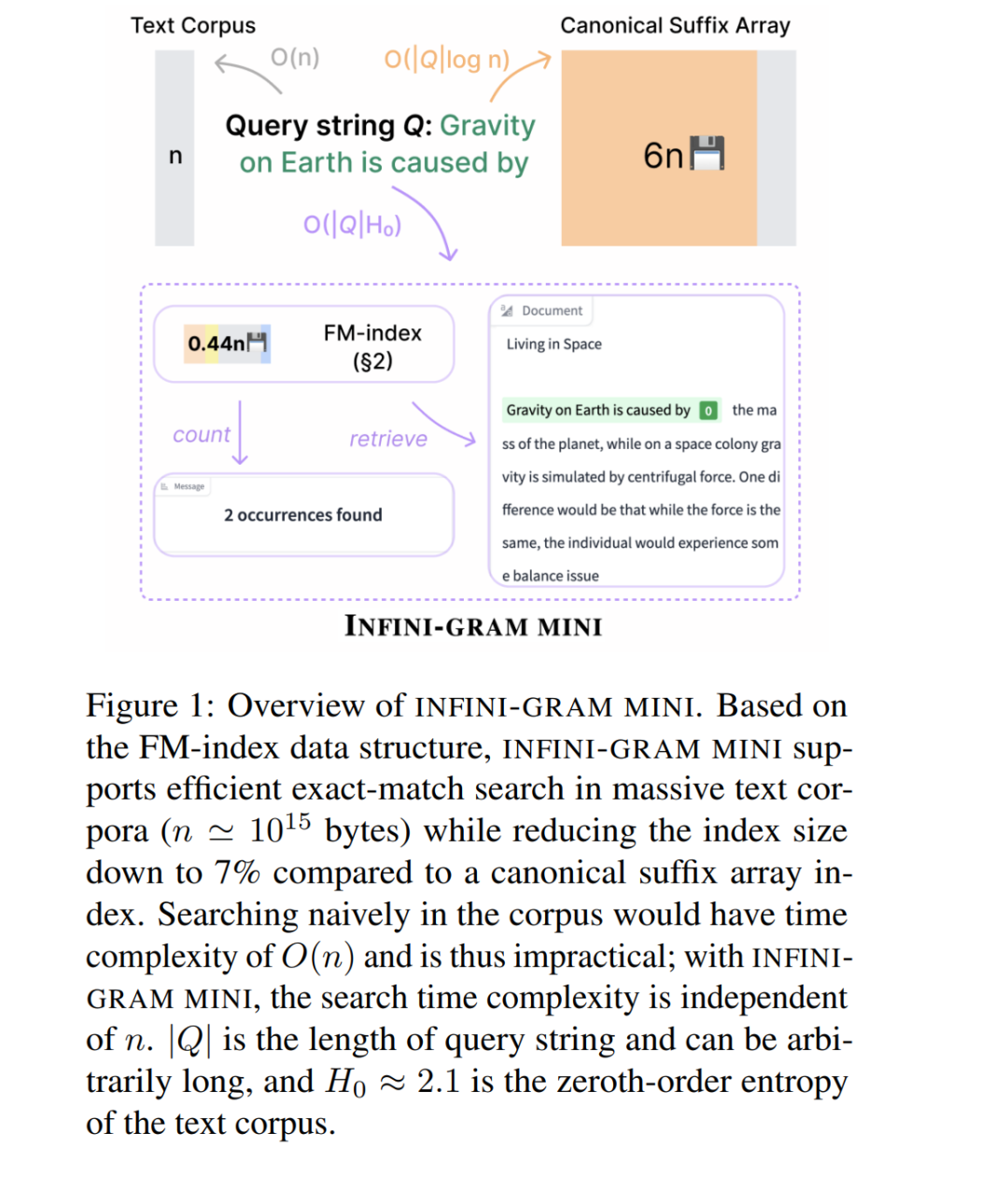

语言模型主要在来自互联网的大规模文本数据上进行训练,因此理解这些数据源变得愈发重要。精确匹配的搜索引擎可以在大型文本语料库中进行搜索——统计字符串出现次数并检索包含它们的文档——但其高存储开销限制了其在互联网规模数据上的应用。本文提出 INFINI-GRAM MINI,一个高效且可扩展的系统,使得PB级文本语料也能实现可搜索。 该系统基于 FM-index 数据结构(Ferragina 和 Manzini,2000),该结构能够同时实现文本的索引与压缩。INFINI-GRAM MINI 生成的索引仅占语料库大小的 44%。与现有最优的 FM-index 实现相比,INFINI-GRAM MINI 在索引速度上提升了 18 倍,在索引阶段的内存使用上减少了 3.2 倍,而查询阶段的内存消耗则降低到可忽略的水平。我们在一台拥有 128 个 vCPU 的单节点 CPU 服务器上,在 99 天内完成了 83TB 互联网文本的索引(若使用 137 个此类节点,则仅需 19 小时)。 我们展示了 INFINI-GRAM MINI 的一个重要应用场景——大规模基准数据污染分析。结果显示,多个核心语言模型评测基准在互联网抓取数据中存在严重污染(例如 GSM8K 的污染率高达 74.2%),这可能导致在使用此类数据训练语言模型时高估其能力。我们建立了一个“基准污染通报平台”,以共享核心及社区贡献基准的数据污染率。同时,我们还发布了一个网页界面与 API 接口,以支持基于 INFINI-GRAM MINI 索引的一般搜索查询。

成为VIP会员查看完整内容

相关内容

专知会员服务

108+阅读 · 2020年3月29日

Arxiv

221+阅读 · 2023年4月7日