机器人已至。人工智能(AI)或人工智能自动化,正伴随着社会中本质上并非纯技术性的讨论而展开。相反,AI高度嵌入社会、伦理、法律和政治话语之中。关于机遇与风险的问题随之产生。人工智能在公众中引发了担忧和恐惧,并且在冲突中——因而也在军事背景下——扮演着越来越重要的角色。

如同任何发展路径和影响尚不明确的新技术一样,对AI的未知引发了各种看法和恐惧,这些看法和恐惧体现在广泛的辩论中。显然,为了做出明智的决策,我们需要更广泛的知识和讨论。美国计算机科学家和未来学家杰里·卡普兰(Jerry Kaplan)警告不要对人工智能持有简单化、片面化和缺乏依据的看法。他指出:“以人类智能为基准来衡量机器智能是徒劳无功的。人们倾向于将能力日益强大的计算机程序视为初具意识的胚胎生物,可能对人类构成某种生存挑战。[…] 这种拟人化的框架强化了一种常见的说法,即智能机器可能突然‘觉醒’并产生意识,可能衍生出它们自己的意图、目标、判断和欲望。天啊,‘它们’什么时候会来取代我的工作、我的家、我的生活?如果它们决定不再需要我们,我们该怎么办?好吧,最新消息是:它们不会来找我们,因为根本没有‘它们’。尽管表面如此,但其内部并无‘居住者’。通用人工智能(GAI)并非以人类的方式‘思考’,它们没有‘心智’。”(Kaplan, 2024, p. 6)

未知的悖论似乎已写入人类的文化密码之中,一方面,新事物和未知事物激发出巨大的兴奋感和对进步(想看看下一个转角有什么)的渴望;而另一方面,新事物和未知事物也是危险的来源,并引发最严重的生存恐惧。考虑到这一点,认识到影响对人工智能自动化态度和接受度的文化根源至关重要。不可能在单一学科内解决这些问题。技术系统与人类系统及其相互关系的复杂性需要多学科的交流,并考虑到从个体到大型社会系统等不同层面的影响。唯有如此,知识才能引向明智和知情的决策。

军事领域中的人工智能自动化备受关注。 基于AI的技术正在改变战争的性质,从提供态势感知和以“机器速度”辅助决策的技术,到战场上可能出现的致命武器系统。将人工智能和自主性引入战争将对国家安全和人类社会产生深远且不可预见的后果。似乎有太多利害关系——危险和风险似乎无限高。特别是在军事应用方面,人工智能自动化引发的许多问题如同通过聚焦镜般凸显出来。这在关于致命性自主武器系统(LAWS)的辩论中变得尤为明显——从部署此类系统所涉及的伦理和法律视角来看。

一方面,自动化显然发生在生活的各个领域,并且在军事领域尤为重要。期望在一个承载着获得对敌优势和效能期望的领域不发生自动化是天真的。另一方面,这带来了压力,要求更仔细地考量可能的风险和不良后果。应当明确,在军事背景下不当使用技术或使用技术上不可控的技术本身是不道德和非法的。伦理原则和国际法适用于新兴技术,其方式与适用于传统技术相同。伦理框架应包含负责任应用技术的原则和适用于军事AI并指导开发者、制造商、采购方和军事最终用户的“数字伦理”。唯有如此,才可能克服对使用该技术“灰色地带”的恐惧,以及对难以预测或在其发生甚至技术发展至此之前赋予其法律效力的、涉及军事AI的“无先例情景”的恐惧。

本书的背景也是关于致命性自主武器系统(LAWS)的利弊乃至禁令的辩论(Reichberg & Syse, 2021)。 这就提出了一个问题:“自主性”究竟意指为何(Koch, 2019, p. 27)。在欧洲议会于2018年9月通过的一项决议中,这被理解为指“在目标选择和接战等关键功能上缺乏人类控制”的武器(RC-B8-0308/2018, 2018, L.4.)。应确保“对武器系统的关键功能,包括在部署期间,进行有意义的人类控制”(RC-B8-0308/2018, 2018, L.2.)。然而,欧盟成员国的各自立场差异很大。在全球层面更是如此(Dahlmann & Dickow, 2019, pp. 17–23)。

在伦理辩论中,通常区分义务论(deontological)和后果论(consequentialist)的论证。根据义务论的论证,“行为、原则、法律或性格特征的道德价值不仅由其效果决定,也由其内在价值决定,而内在价值可能受到例如意图、动机或所评估行为或原则的类型的影响”(Bodziany, 2021, p. 56)。相反,后果论的论证指出“行为、规则、法律、性格特征或制度的非工具性、内在道德价值仅在于其效果”(Bodziany, 2021, p. 56)。反对使用LAWS的最著名的义务论论证是认为使用此类系统侵犯了人的尊严(Koch, 2019, pp. 30–31)。根据这一论证,技术自动化机制原则上不具备做出良心决策的能力。此类武器系统的目标“仅仅是数学计算出的杀戮决策的对象”(Geiß, 2019, p. 54)。3 “对于自主系统来说,它面对的是土豆袋、动物还是人类,完全无关紧要”(Koch, 2019, p. 31)。反对LAWS的后果论论证则适用,例如,当指出与使用此类技术相关的巨大风险时(Koch, 2019, pp. 32–33)。所讨论的此类风险之一是不稳定的军备竞赛(Altmann, 2019)。

禁止使用的论点也遭到反驳。 例如,迪特·比恩巴赫(Dieter Birnbacher)(2016年,第120页)认为:当然,机器无法理解人类生命的价值。但是,如果受害者面临的替代威胁是来自诸如轰炸机等有人操控武器的伤害或杀戮,那么这对受害者而言又有什么不同呢?对于那些尊严受到威胁的受害者来说,只要情况的所有其他参数相同,他们所面临的威胁是来自有人还是无人武器是无关紧要的。

然而,从社会学的角度来看,将技术自动化的使用置于具体情境中至关重要——无论其在话语中被描述得多么“智能”。这里特别重要的是使用技术自动化的组织情境(卢曼,1966年)。当然,这也适用于军队。在武装部队中,所有“自主”系统都应像任何士兵一样,服从指挥。他或她在指挥链中“自主”行动。这同样适用于“自主”人工智能系统,不同之处在于它们不理解自己在做什么。正如技术社会学中可能说的那样,它们在因果关系的媒介中运作,而不是在意义的媒介中运作(埃斯波西托,2022年;哈尔夫曼,1996年)。但没有人需要以永久偏离常态的方式运作的机器——没有公司、没有当局、没有军队、没有私人用户。正如人类社会行动者或组织一样,机器也应在规范定义的期望框架内运作。

在这个意义上,这些系统实际上并非严格意义上的“自主”,而是半自主的。从这样的社会学视角来看,人类(在社会角色中)是并且应当对人工智能武器系统的行为负责(科赫等人,2024年;斯普林,2023年)。这种方法也带来伦理后果。在什么条件下,士兵能够良心无愧地承担使用具有致命效果的人工智能武器系统的责任?这背后的理念是,这种问责制确保了人工智能武器系统的使用受限于社会的伦理框架,从而限制了这种武器技术所提供的潜在暴力。这不是关于禁令,而是关于在负责任处理的含义下的遏制。

在这样的社会学背景下,在军事中使用AI技术并非全无问题;事实上,情况恰恰相反。然而,这并不能证明全面禁止是合理的——更重要的是审视使用的具体情境,而这些情境是多种多样的。例如,它们包括法律与伦理、军事组织与社会沟通、媒体技能、机器人技术的文化概念、人机交互(HMI)、开发背景以及当然还有战场上决策过程的复杂性。这表明需要一种跨学科的方法,这也是我们希望通过本书来鼓励的。

毫无疑问,人工智能自动化如同任何新技术一样,承载着担忧和风险。人们可能会因此望而却步,但那样的话,也应该停止谈论创新和进步。最终,正如卢曼(1993年,第89页)指出的,新技术只有通过尝试、在社会中实施并反复反思才能变得安全。还必须看到,新技术使社会能够增加其复杂性。例如,有了一座桥,交通、贸易和沟通的新可能性就出现了。

本书汇集了来自科学界、政界和军方本身对军事AI应用的多学科、差异化、知情且开放的方法。基于人工智能自动化发展所提出的问题,本书设定了一项任务,即批判性地审视当前和未来军事技术领域的挑战。

第一部分探讨了与技术进步(包括人工智能)相关的文化和社会话语。它审视了影响人工智能自动化发展,更重要的是影响对其态度和接受度的流行、科学和政治话语的文化起源。迪尔克·斯普林(Dierk Spreen)和凯里·塔尔维斯(Kairi Talves)分析了作为技术自动化话语主题的机器人恐惧在整个现代历史的若干文化叙事中是如何被反映的。人工智能自动化的理念自其发展初期就创造了巨大希望,但也带有警示标志,这使得公众讨论充满了既迷恋又恐惧的矛盾心理。在下一章中,迪尔克·斯普林(Dierk Spreen)就人类增强(human enhancement)的伦理和社会方面进行了讨论,延续了类似的主题。他分析了赛博格(cyborg)——人体与现代技术之间的共生关系——这一概念如何与技术进步以及关于人体的后人类主义话语相结合。人类增强引起了军方的兴趣,并需要在这一社会领域进行伦理反思。文化产物可能强烈影响对未知事物——人类与技术的未来——的沟通。贝恩德·弗莱斯纳(Bernd Flessner)的章节对此进行了审视,他讨论了科幻小说在这一沟通领域中的作用。科幻小说作者勾勒出的未来让我们得以一窥即将到来的景象,因此被视为关于多样化转型的文化投射的重要来源。费迪南德·格林格(Ferdinand Gehringer)和亚历山大·舒斯特(Alexander Schuster)专注于政治舞台,通过分析关于AI军事应用潜在监管限制的国际辩论。对军事应用中AI的监管是当前和未来安全秩序的关键方面,但这需要国家间采取动态的倡议和建立动态的监管框架。凯里·塔尔维斯(Kairi Talves)、普里特·瓦尔诺(Priit Värno)和埃勒里·利勒梅(Eleri Lillemäe)介绍了一项关于小国武装部队对自主技术的态度和接受度的实证研究。他们考察了在爱沙尼亚,在受全球技术和安全挑战影响的特定背景下,军方的态度如何影响武装部队中技术自动化的推进。

本书第二部分将注意力转向在军事冲突中使用人工智能所带来的挑战与变革。 它提出了军事组织中哪些方面是变革的关键点这一问题,同时也审视了伦理与法律层面。它考察了军事组织的作用、其基本概念及其条令,以及人的因素在自主技术的开发与实施中的影响。伊戈尔·科皮亚京(Igor Kopõtin)、卡雷尔·皮里迈(Kaarel Piirimäe)和阿尔托·奥尔(Arto Oll)从历史视角分析了技术在军事冲突中的作用。他们认为,任何军事技术发明只有成功融入军事组织并且其使用与军事行动目标相关联时才能发挥效力。战争仍然是人与人之间的战争,人的因素将永远是决定性的,因为武器,无论其为何物,将始终是人类手中的工具。类似地,沃尔夫冈·科赫(Wolfgang Koch)、约尔格·福尔默(Jörg Vollmer)和弗洛里安·凯辛格(Florian Keisinger)的章节指出,开发和部署基于人工智能的防御技术不仅仅是一个技术创新的方面。它影响着武装部队思维和行动的整体方式。在军事领域负责任地使用人工智能是必然要求,这需要在人工智能开发与部署的全谱系——包括研究、开发和防御规划界——中贯彻“数字伦理”。彼得·安德烈亚斯·波普(Peter Andreas Popp)以德国联邦国防军的领导力概念“内部领导”(Innere Führung)为例,探讨了构成军事精神“价值指南针”的原则与人工智能自动化等军事技术发展之间提出了何种挑战。斯图尔特·凯西-马森(Stuart Casey-Maslen)审视了与自主武器系统发展相关的法律挑战。武装冲突的合规性是一个快速增长的辩论主题。

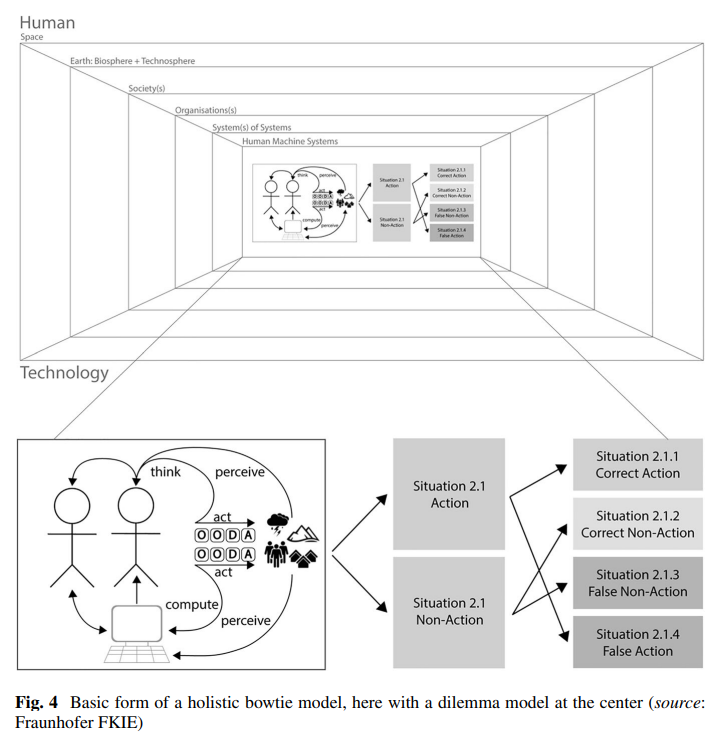

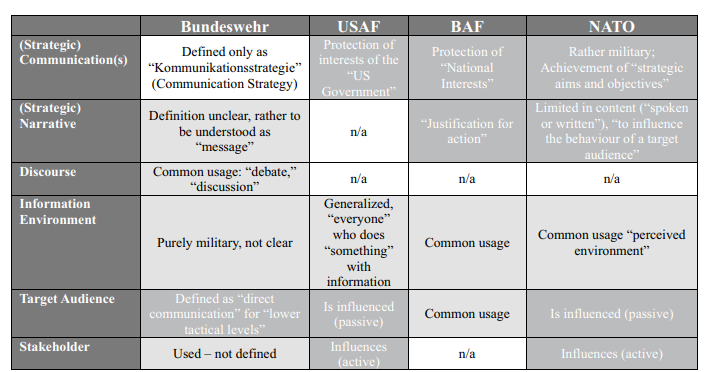

第三部分探讨了在军事中实施人工智能所带来的沟通挑战及其相关的机遇与风险。 只有当背景和影响被恰当理解时,沟通才能搭建桥梁。在技术领域尤其如此,其沟通要素依赖于技术维度的风险、信任、责任和问责制,并与之紧密相连(Koch等人,2024年)。索尼娅·索萨(Sonia Sousa)、加布里埃拉·贝尔特朗(Gabriela Beltrão)、尤利娅·帕拉莫诺娃(Iuliia Paramonova)和德博拉·C·菲尔米诺·德索萨(Debora C. Firmino de Souza)探讨了可信系统设计的概念,认为这是整合和缓解与人工智能系统相关的可能沟通挑战并增强用户对人机相互关系的信任的一种可能性。娜塔莎·佐维斯洛-格吕内瓦尔德(Natascha Zowislo-Grünewald)和弗朗兹·拜辛格(Franz Beitzinger)处理了沟通挑战的另一个方面——关于军事技术创新。应对这一沟通挑战不仅仅是信息的传播;它需要理解受军事组织创新影响的社会和符号学背景。在下一章中,娜塔莎·佐维斯洛-格吕内瓦尔德(Natascha Zowislo-Grünewald)讨论了术语和统一定义的重要性,认为这对于像人工智能这样的新技术的沟通和实现互操作性至关重要。在最后一章中,弗兰克·奥勒·弗莱米施(Frank Ole Flemisch)、迪尔克·斯普林(Dierk Spreen)、玛丽-皮埃尔·帕科-勒穆瓦纳(Marie-Pierre Pacaux-Lemoine)、本杰明·J·诺克斯(Benjamin J. Knox)、凯里·塔尔维斯(Kairi Talves)和约翰·克里斯托弗·布里尔(John Christopher Brill)介绍了“整体蝴蝶结模型”(holistic bowtie model),这是一个多层概念方法,从系统理论的角度解释关于国防中人工智能和自动化的整体性思考。

此处收录的文章旨在帮助理解社会背景中的人工智能。 军事组织尤其值得关注。自然,“负责任的信息处理”问题在“作战部队”中尤为严峻地出现(卢曼,1995年,第176页)。另一方面,军队也是社会的功能系统之一(达曼,2022年,第121页)。这意味着,军事人工智能系统的例子能特别好地聚焦于应用人工智能自动化可能产生的问题。我们关注的是确保人工智能在军事以及社会的其他功能背景中得到负责任的使用,即,它仍然服从于处于组织角色中的人类行为者的问责和控制。

提纲

引言:人工智能正在走向战争

理解人工智能

对机器人的恐惧:技术自主性的文化视角

赛博格士兵与伦理强化

科幻小说中的自主武器系统

“SMART倡议”:在未来战场上使用人工智能的政治限度?

小国背景下人工智能军事技术的接受模型

人工智能与军事冲突

战争中人的因素与军事技术:历史视角

未来战争中负责任地使用人工智能系统

从“内部领导”(Innere Fuehrung)视角看人工智能(AI)与联邦国防军

国际法下的自主武器系统

沟通面临的挑战

可信系统设计:人的因素视角

沟通军事创新面临的挑战

混合战争与话语防御

防御系统中基于人工智能技术的整体蝴蝶结模型